前言

前段时间OpenClaw比较火,部署玩了几天感觉还不错。然后今天突然看到沉寂多时的ChatGPT-On-Wechat项目(以下简称COW)又活了,该项目原来主要是实现把AI接入个微、企微、飞书、钉钉之类的渠道,当时主要接个微玩了,后来腾子封禁力度越来越严,基本就没得玩了。然后COW也就几个月没得更新了,毕竟没啥可更,这次更新CowAgent我估摸着是看到OpenClaw的功能,找到了新的开发方向了

至于目前CowAgent有啥功能,跟OpenClaw差不多,只不过CowAgent原本就是接入国内平台的,在使用体验上来说应该更好一些,至于细节我还没上手试,毕竟我还没部署,这篇文章就是我边首次部署边写的

本篇文章的教程仅包含Linux云服务器部署,因为我个人没有MacOS电脑,没法写,Windows上部署的教程,看情况吧,有时间就写

没有服务器的,还没地方买的,推荐看下方文章

服务器配置

系统:Debian12 (虽说官方推荐Ubuntu 22.04,但是我不用,我用Debian12多一点)

核心:4C

运存:4G

位置:国内

实际上可运行的服务器配置2C2G就够了,我这刚好有一台限制的4C4G就拿来用了

我个人使用的SSH工具是FinalShell,方便改文件啥的

部署

安装Python环境

官方提供了一键安装脚本,但是没有Python环境的安装,想必后边可能会加上,但是现在就得手动安装了

安装依赖

首先安装依赖(以前的COW需要这一步,我不确定CowAgent要不要,所以就当它要好了)

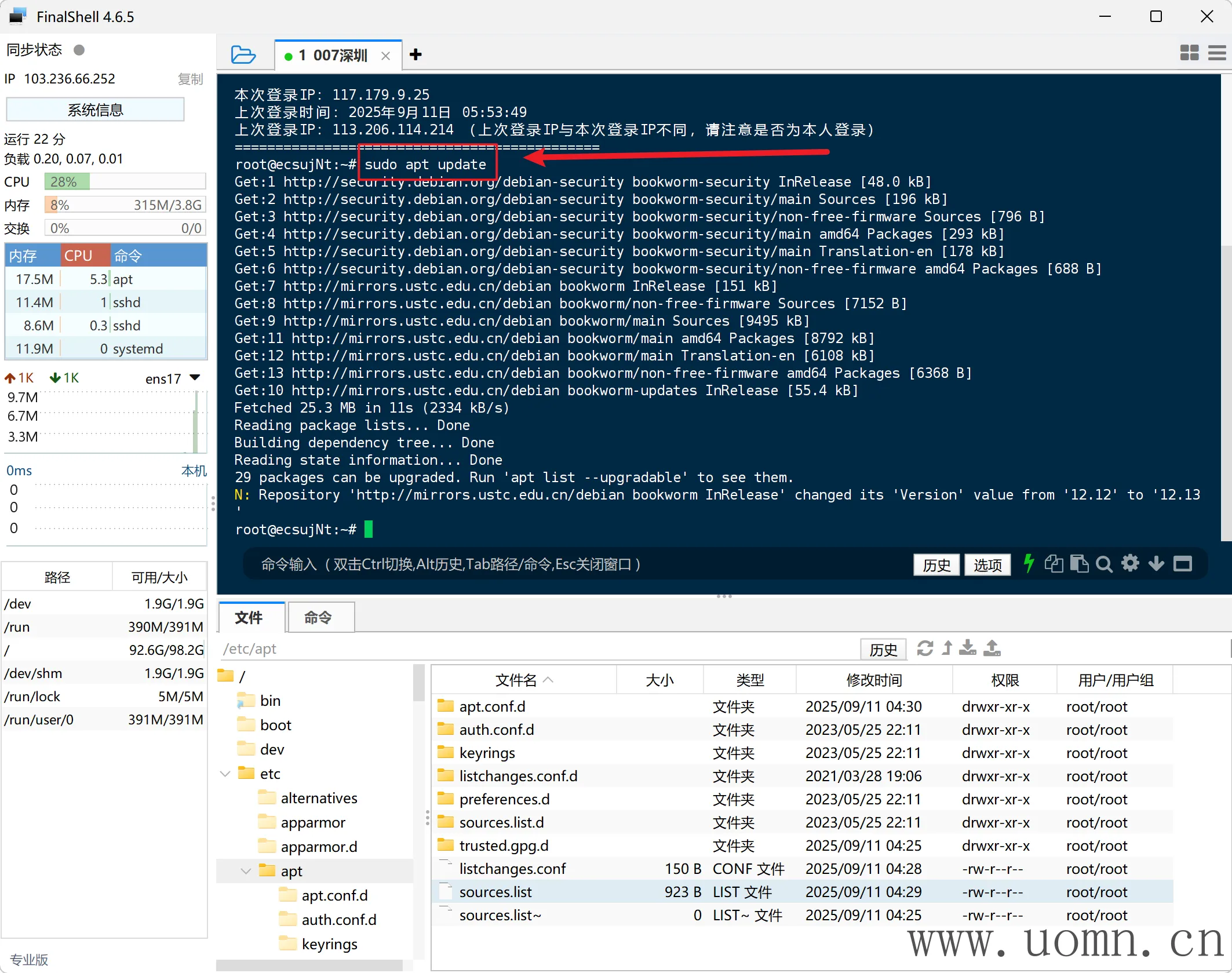

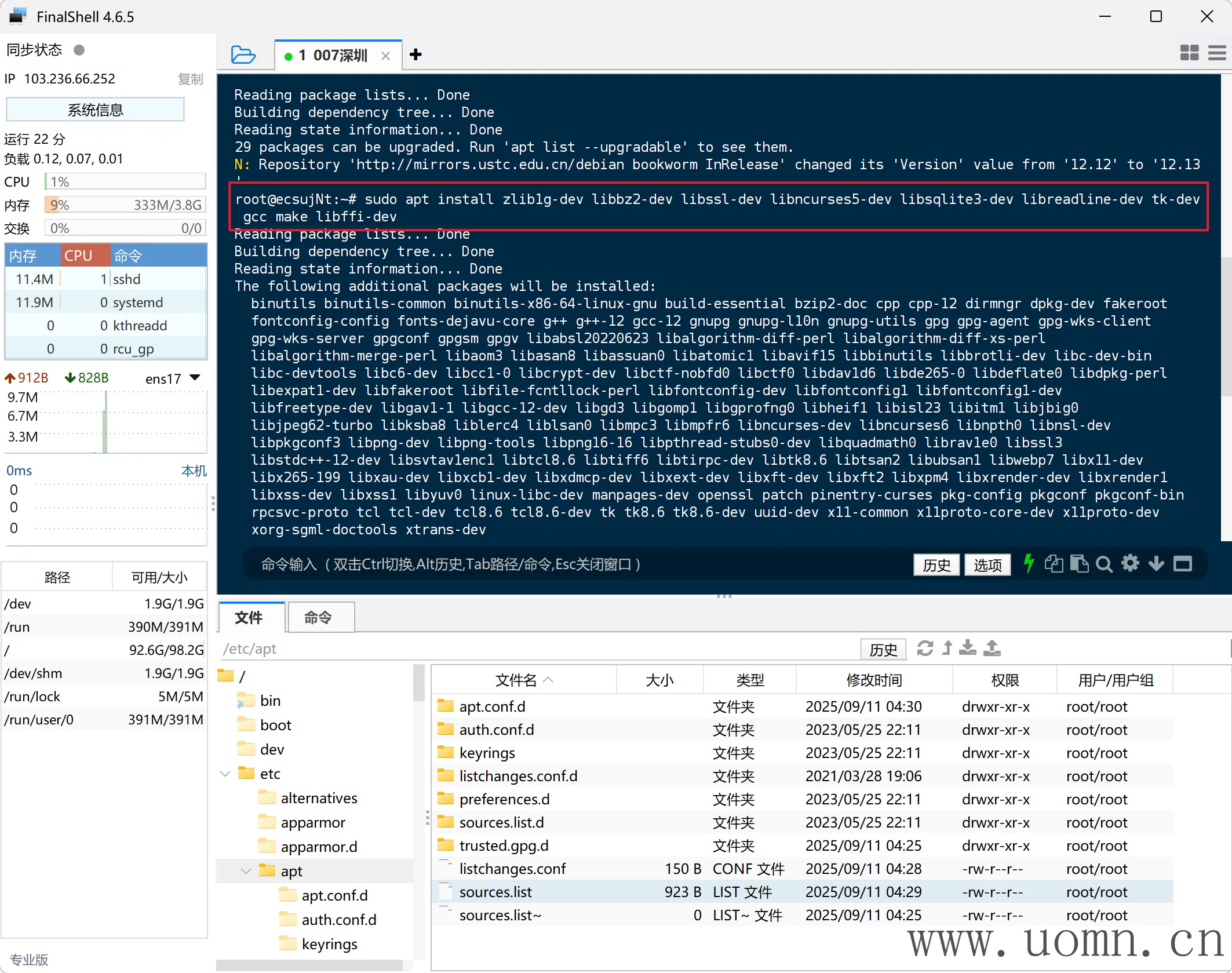

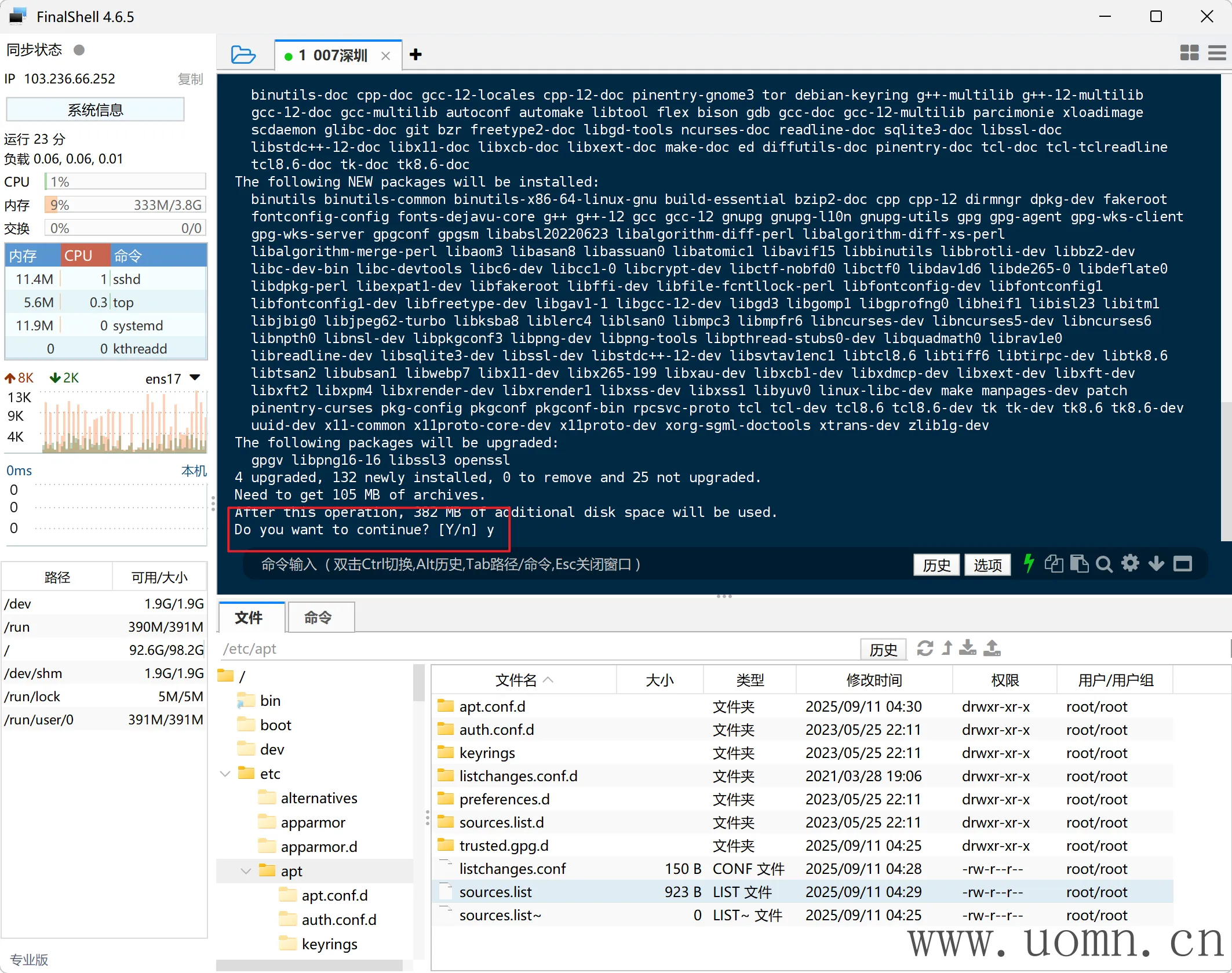

sudo apt update

sudo apt install -y git zlib1g-dev libbz2-dev libssl-dev libncurses5-dev libsqlite3-dev libreadline-dev tk-dev gcc make libffi-dev

安装依赖的时候如果提示【y/n】,则输入y然后回车继续就行了

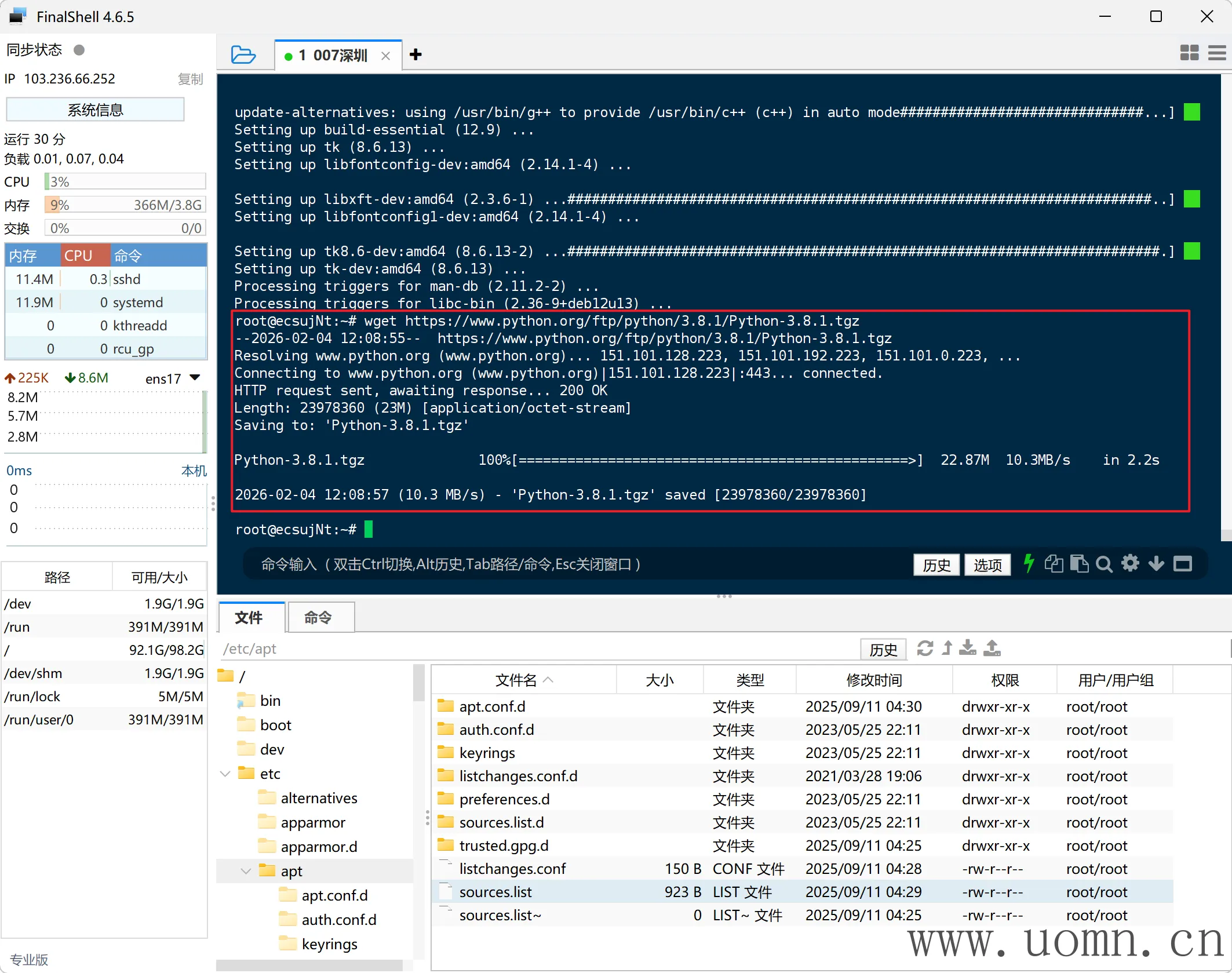

下载Python

如果下载很慢,可以在本机下载后,手动上传到root目录

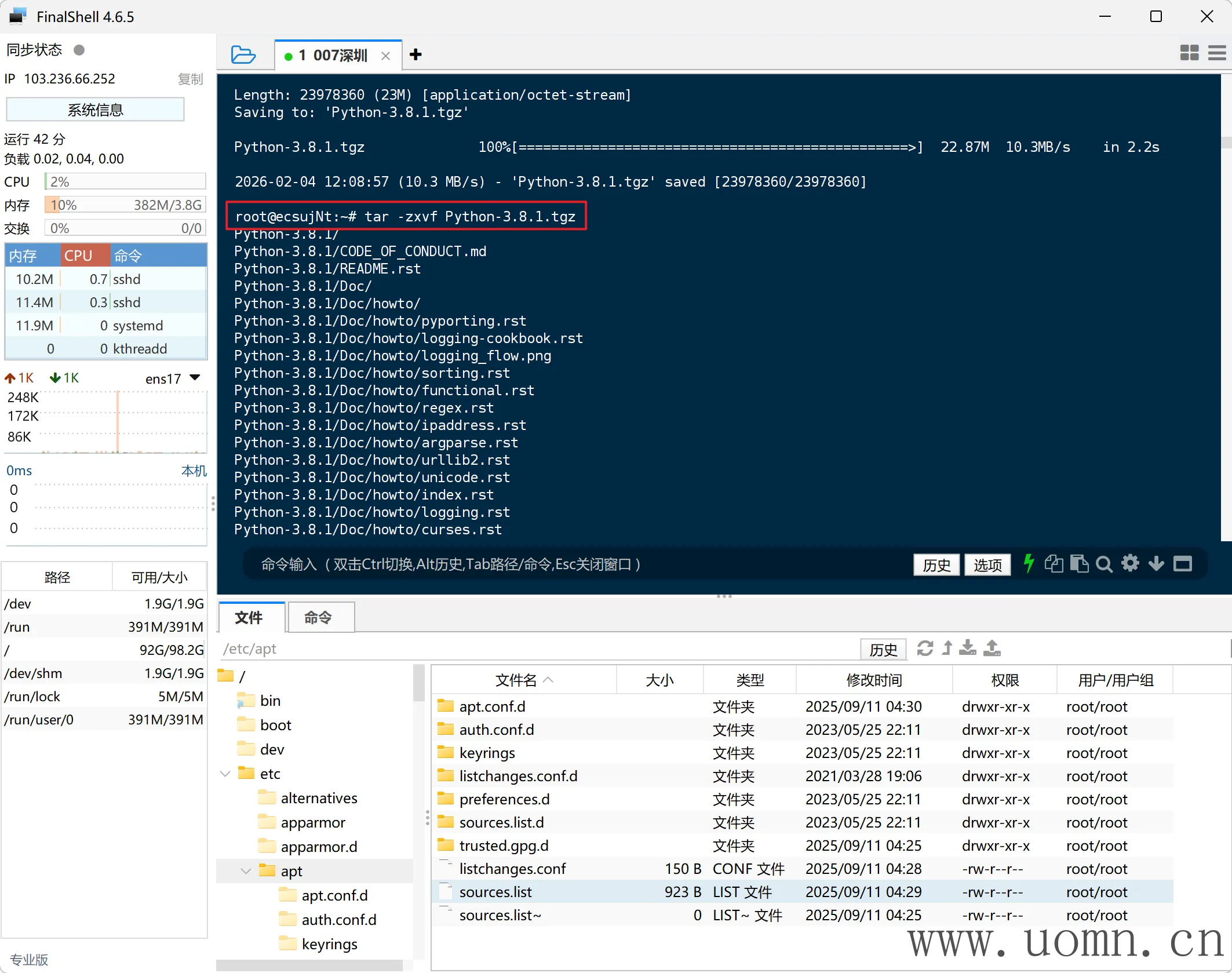

wget https://www.python.org/ftp/python/3.8.1/Python-3.8.1.tgz

解压文件

tar -zxvf Python-3.8.1.tgz

进入文件夹并配置安装位置

cd Python-3.8.1

./configure prefix=/usr/local/python3

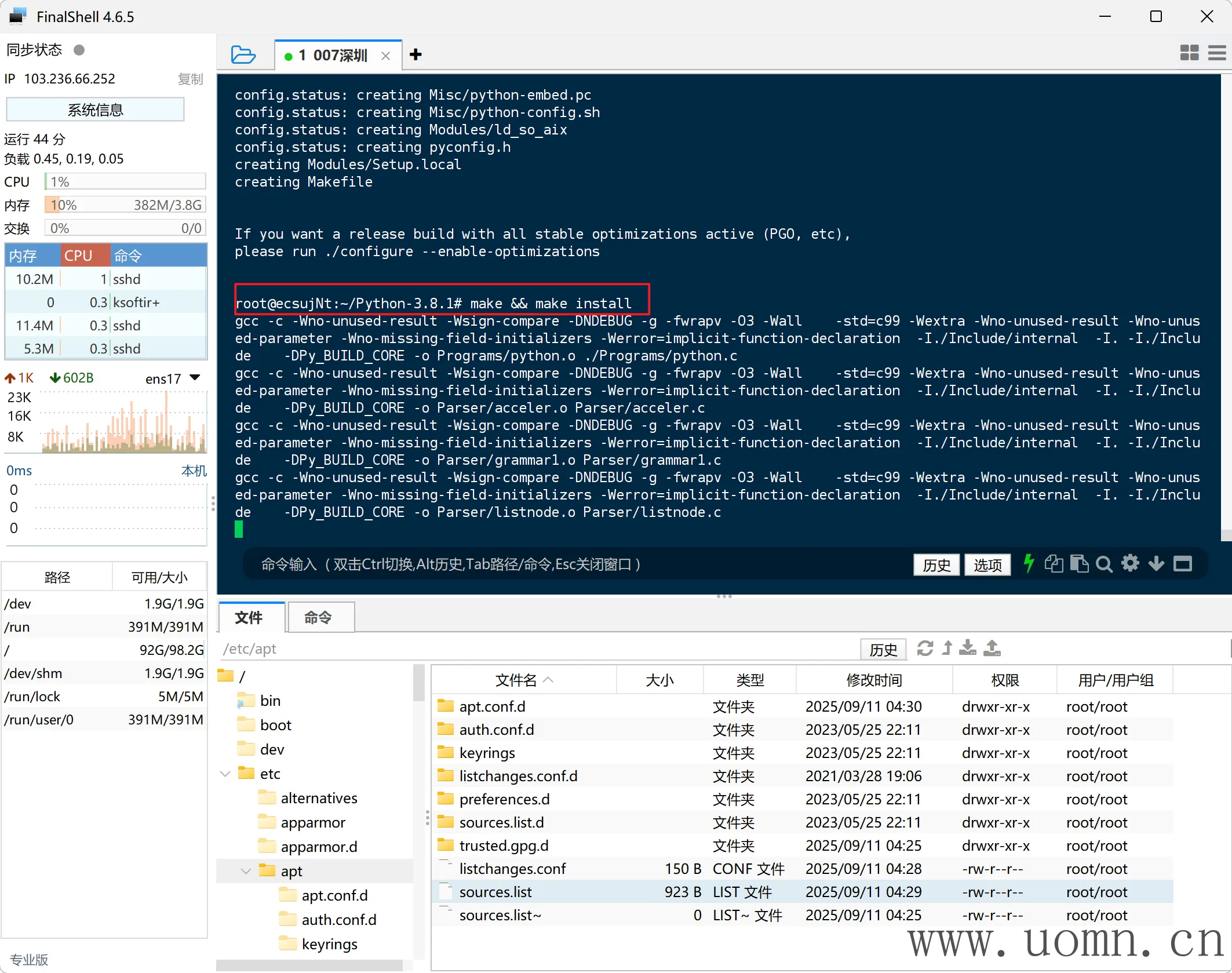

开始安装(此步骤耗时较长,主要取决于服务器性能)

make && make install

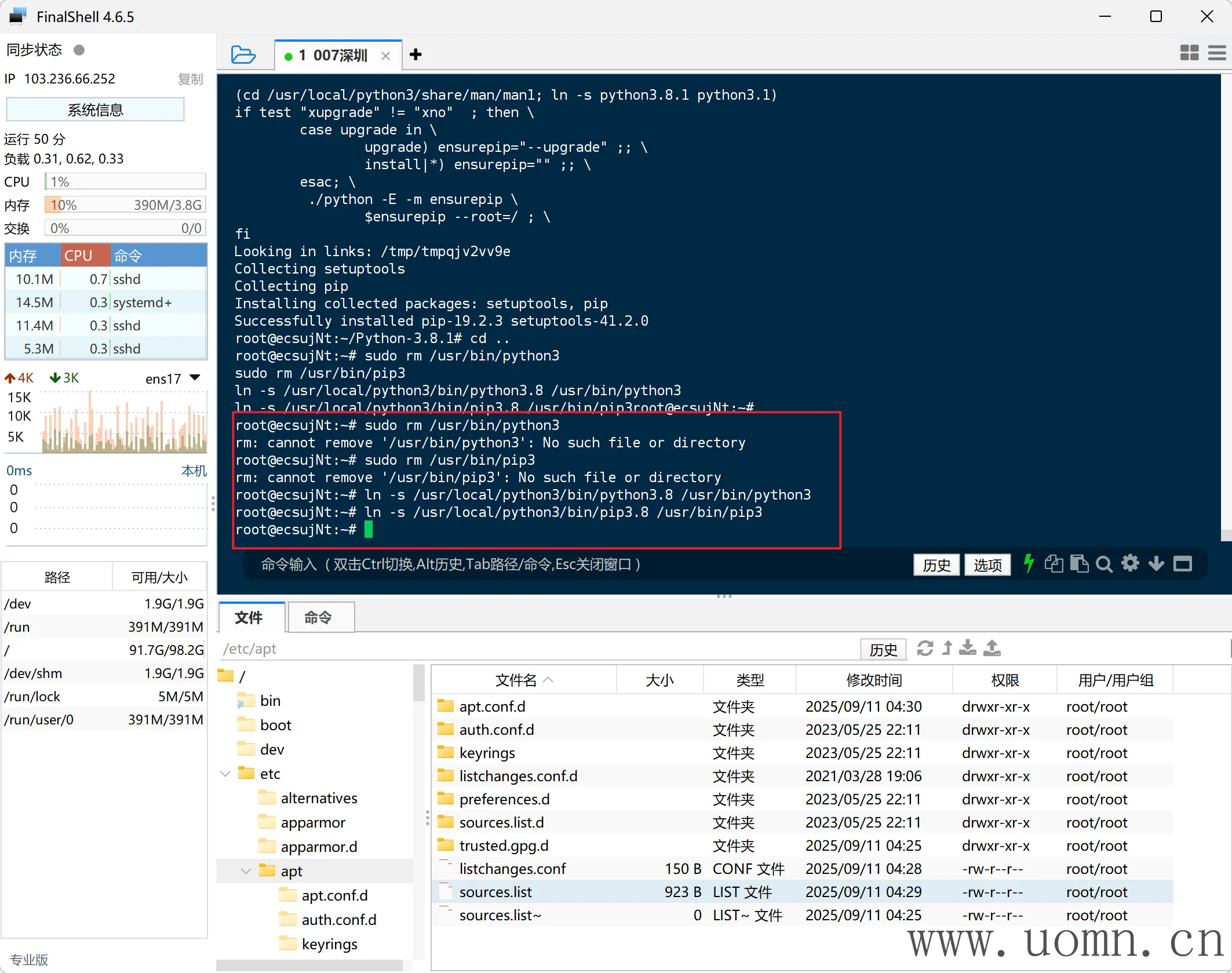

配置软链接

cd ..

# 移除原有软连接(可能不需要此步骤)

sudo rm /usr/bin/python3

sudo rm /usr/bin/pip3

# 创建软连接

ln -s /usr/local/python3/bin/python3.8 /usr/bin/python3

ln -s /usr/local/python3/bin/pip3.8 /usr/bin/pip3

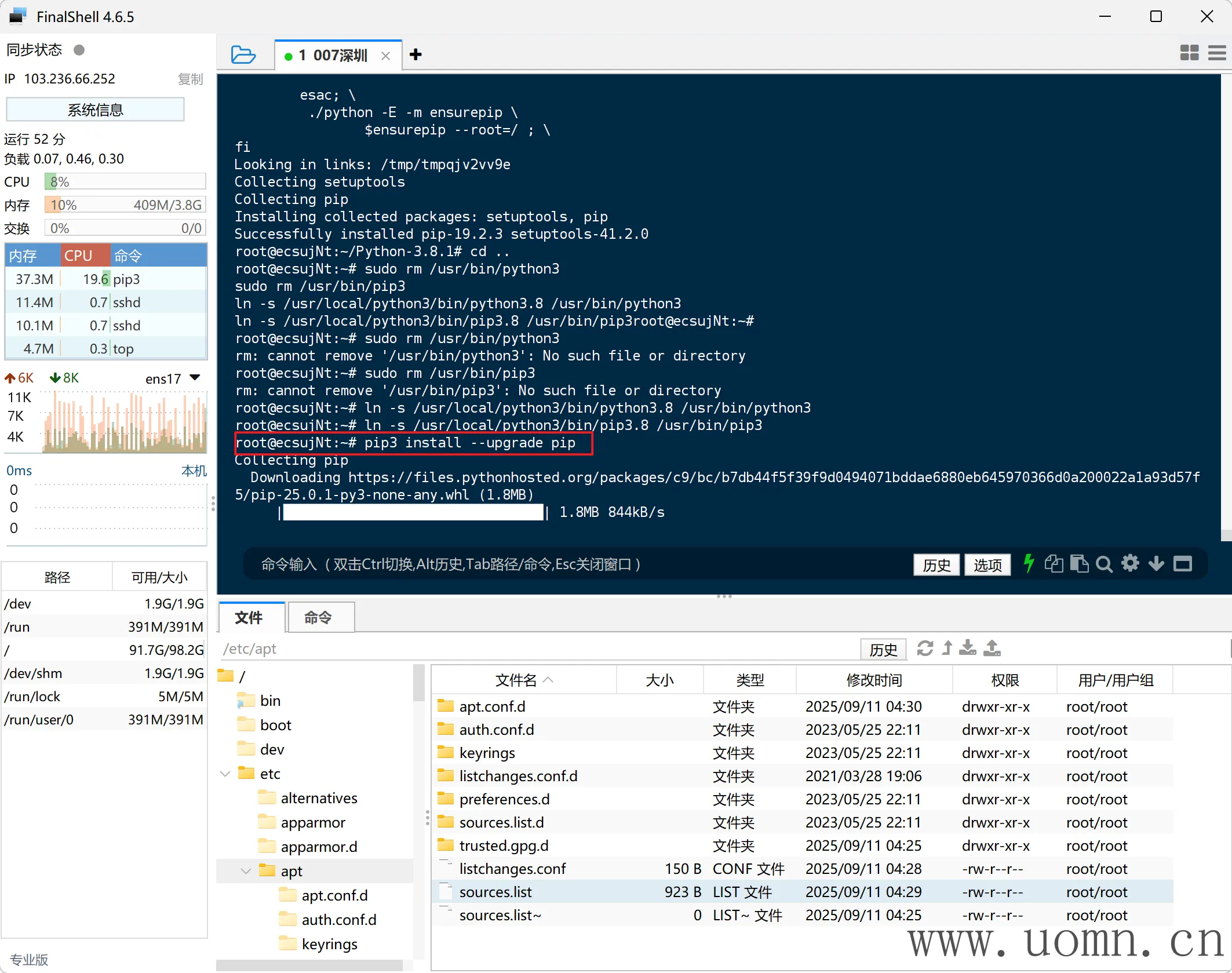

更新pip

pip3 install --upgrade pip

安装CowAgent

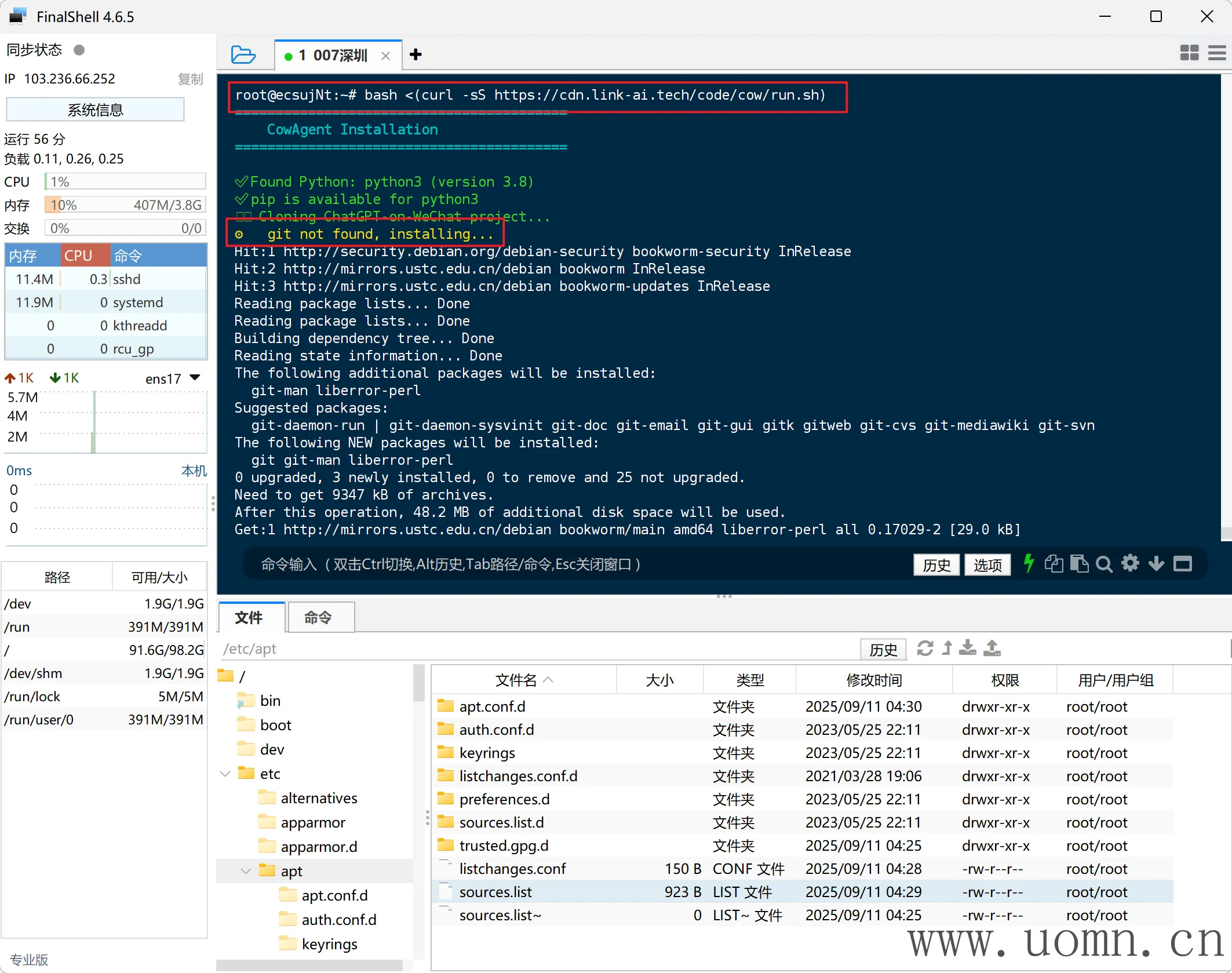

官方提供了一键部署命令,直接用,该命令会检查一些必要的环境。一般来说,上边部署完之后,应该只差个Git没有安装了,执行命令后会自动装上(刚更新了上边的安装依赖的命令,git也会默认安装完成)

bash <(curl -sS https://cdn.link-ai.tech/code/cow/run.sh)

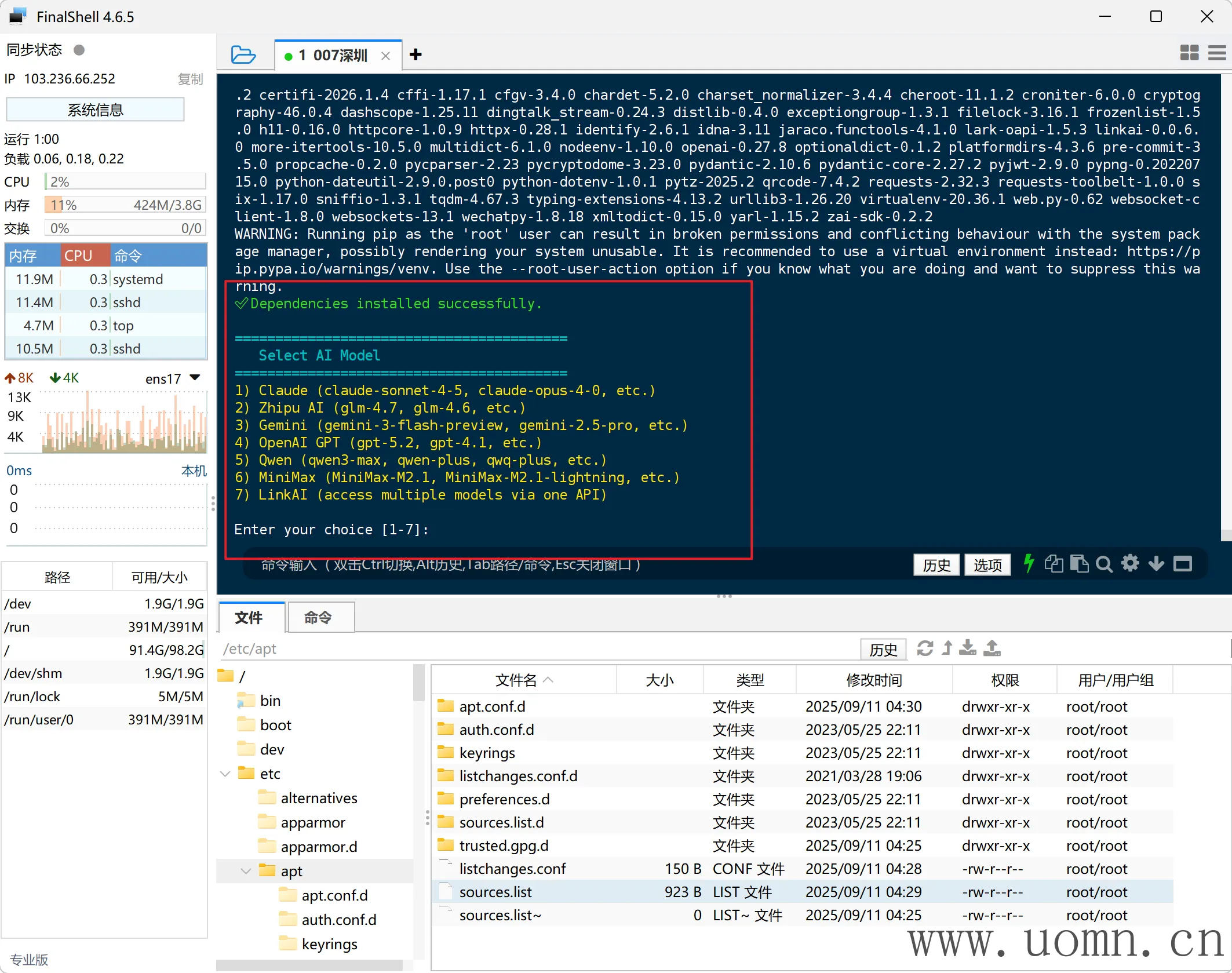

安装完成后会进入配置页面

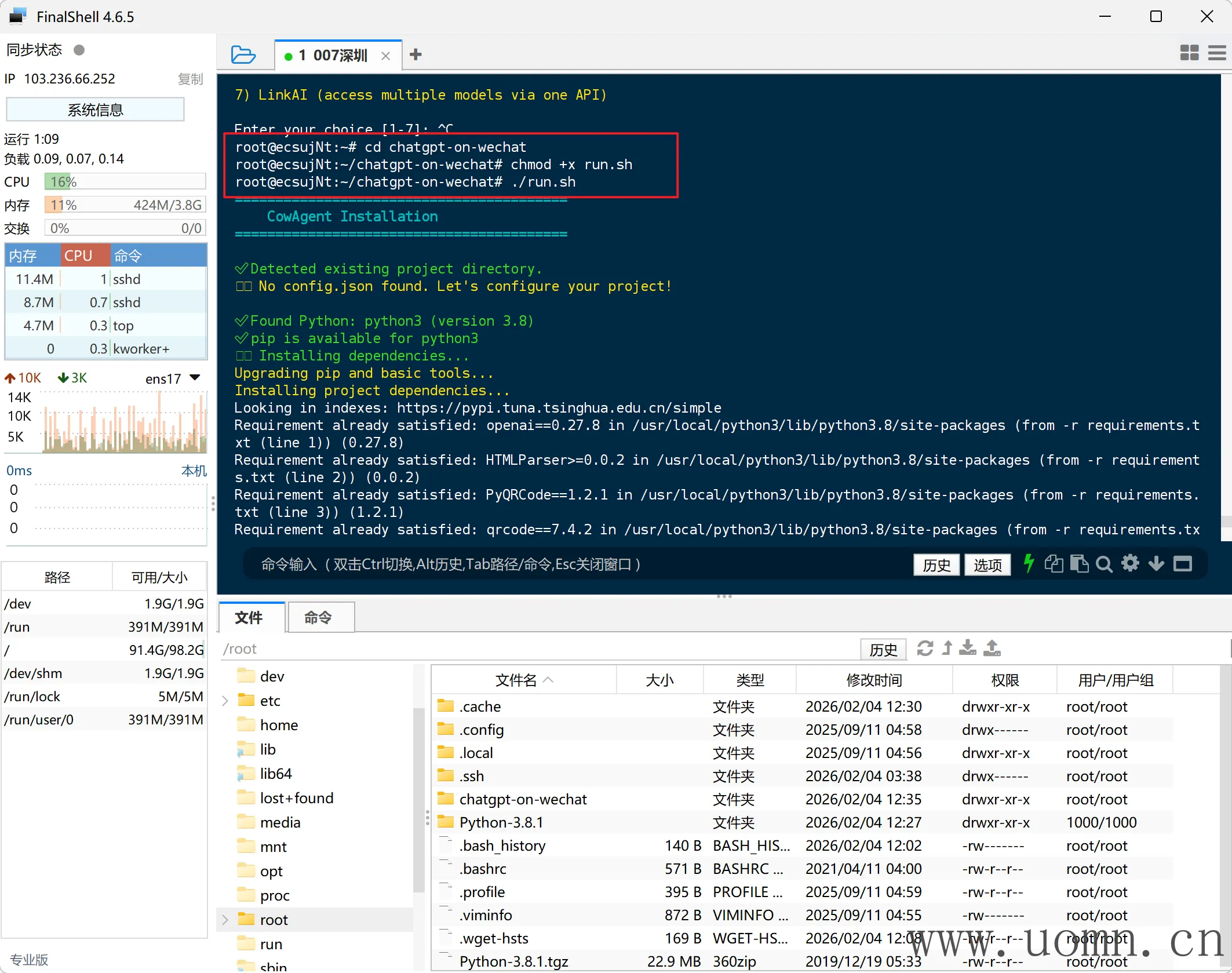

这里我故意Crtl+C中断流程,为了防止有的小小伙伴不小心退出后无法继续初始化

重新进入初始化,需要进入项目目录并执行安装命令

cd chatgpt-on-wechat

# 配置脚本权限

chmod +x run.sh

# 初始化

./run.sh

接下来就是选模型的阶段,我这刚好有个现成的Minimax密钥,那我就选minimax的了

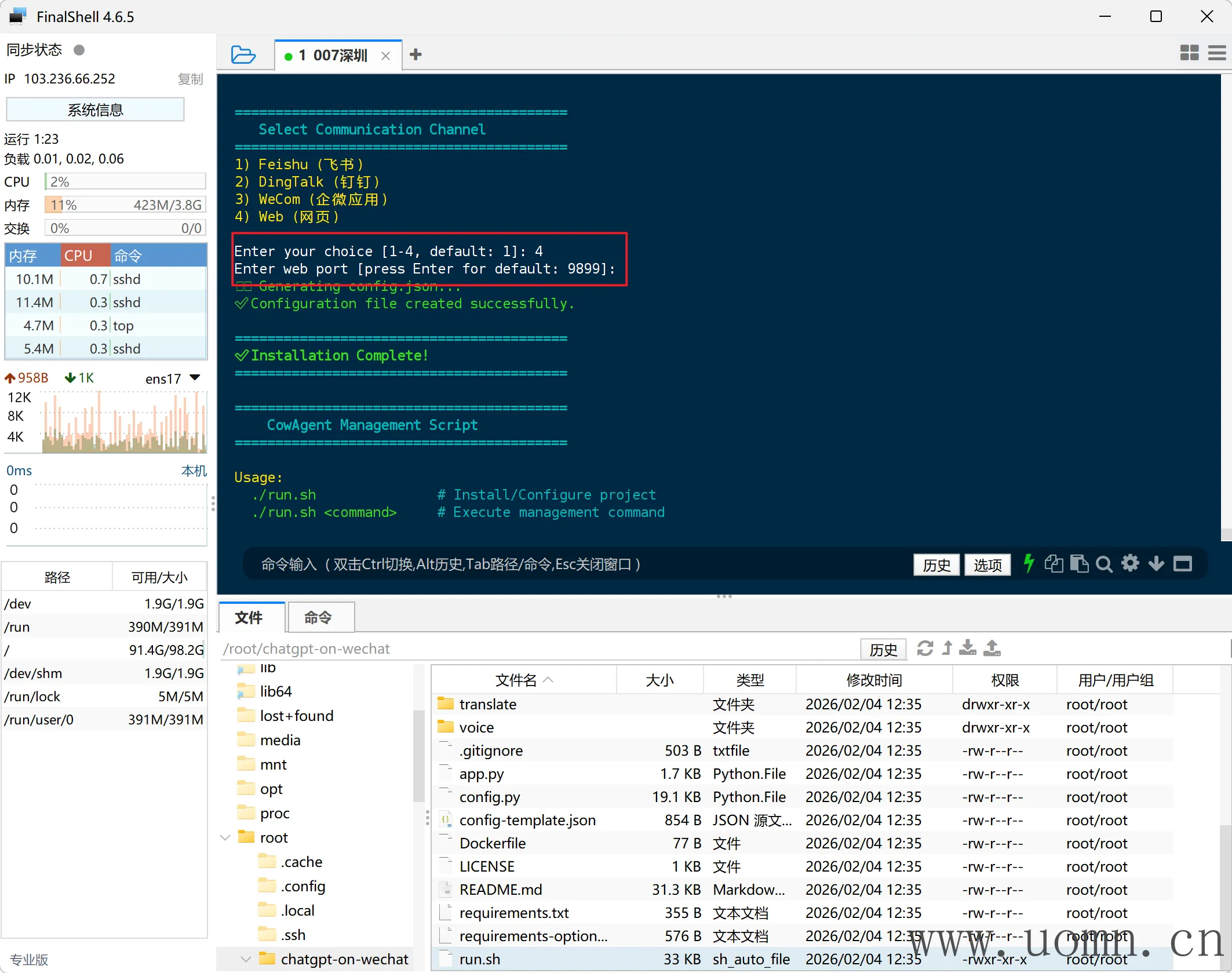

下一步接入渠道,这里先不接,后边我统一写渠道的接入教程,所以这里先选Web,端口默认即可

常用命令

=========================================

CowAgent Management Script

=========================================

Usage:

./run.sh # Install/Configure project

./run.sh <command> # Execute management command

Commands:

start Start the service

stop Stop the service

restart Restart the service

status Check service status

logs View logs (tail -f)

config Reconfigure project

update Update and restart

Examples:

./run.sh start

./run.sh logs

./run.sh status

=========================================测试

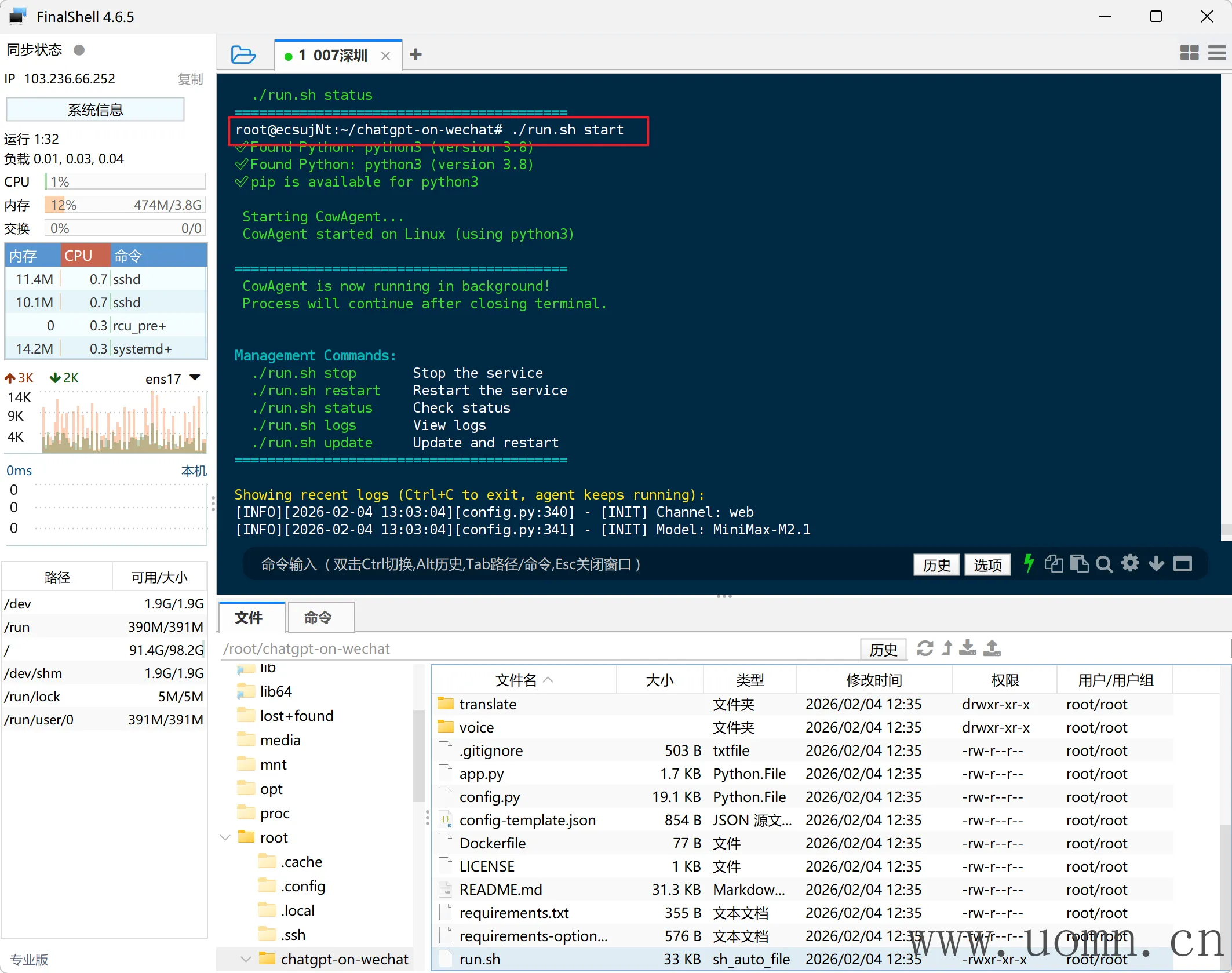

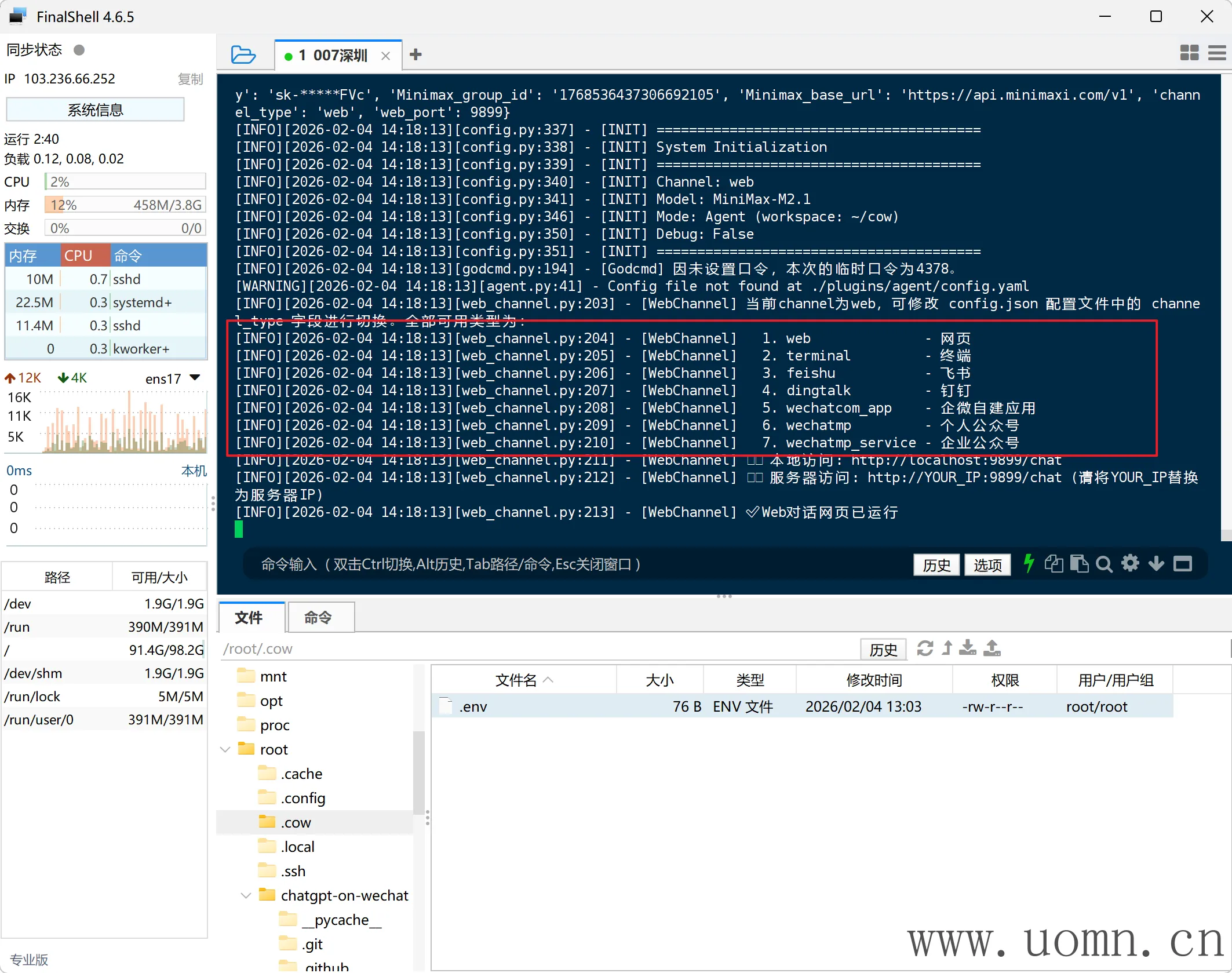

首先就是得启动程序

./run.sh start

然后尝试访问一下Web看看,服务端口默认为9899,确保端口是开放的

http://<服务器IP>:<服务端口>/chat

提示:目前Web看起来没有鉴权,所有人都可以访问,这很危险,所以,后边要关掉

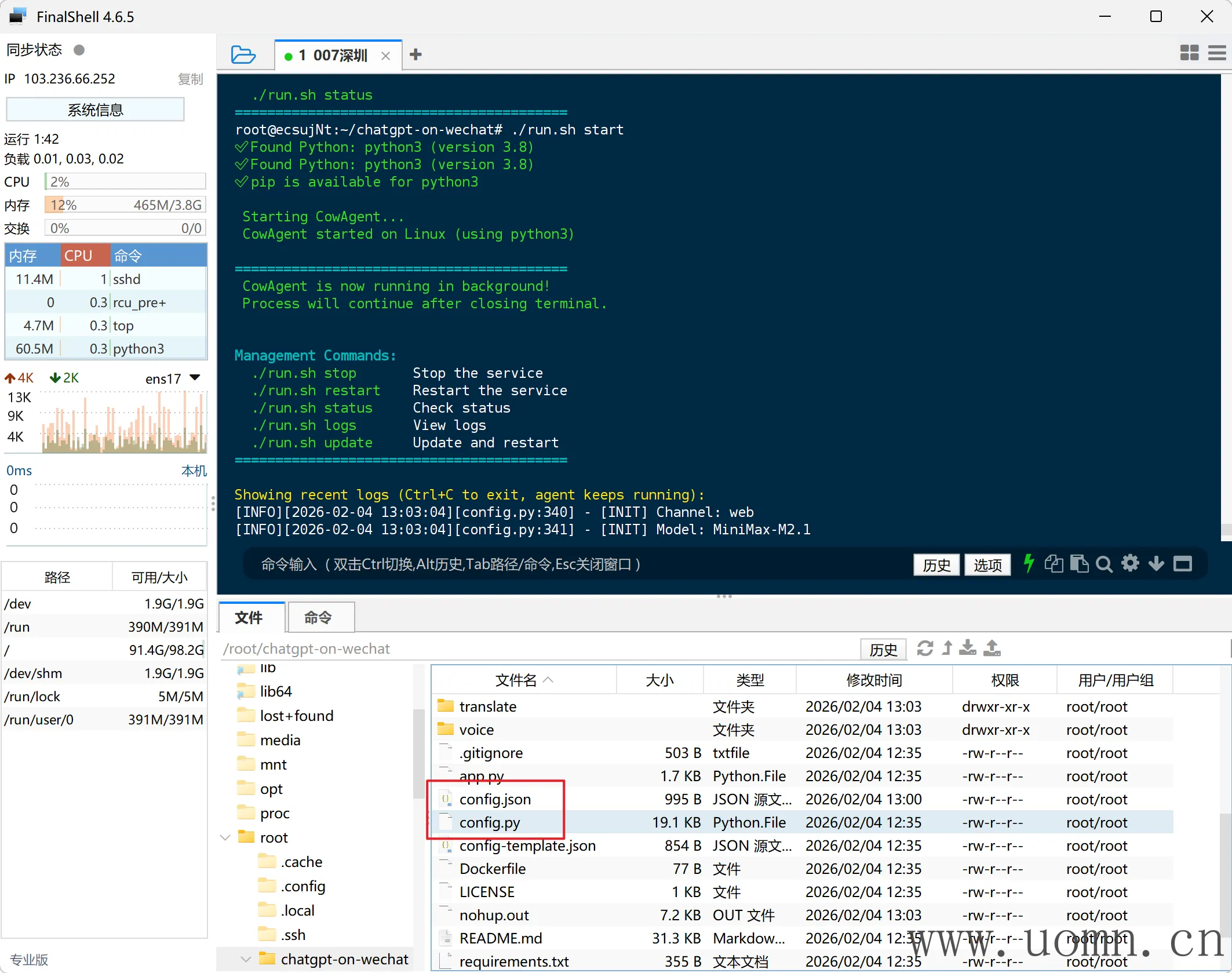

配置教程

首先,我们需要预先了解配置文件,但是这里我就不多说了,因为配置有很多,官方也有中文的说明,在项目目录下的config.json 是配置文件,config.py 是配置说明文件,几乎所有的配置你都能在config.py 中找到

虽说agent能够帮你一键配置好模型,但是我觉得还是有必要写的

在开始配置前,我会清空配置文件,下方标注必须的,为配置文件必不可少的

注意:配置文件内不要出现注解(我记得好像是不行的,可以试试)

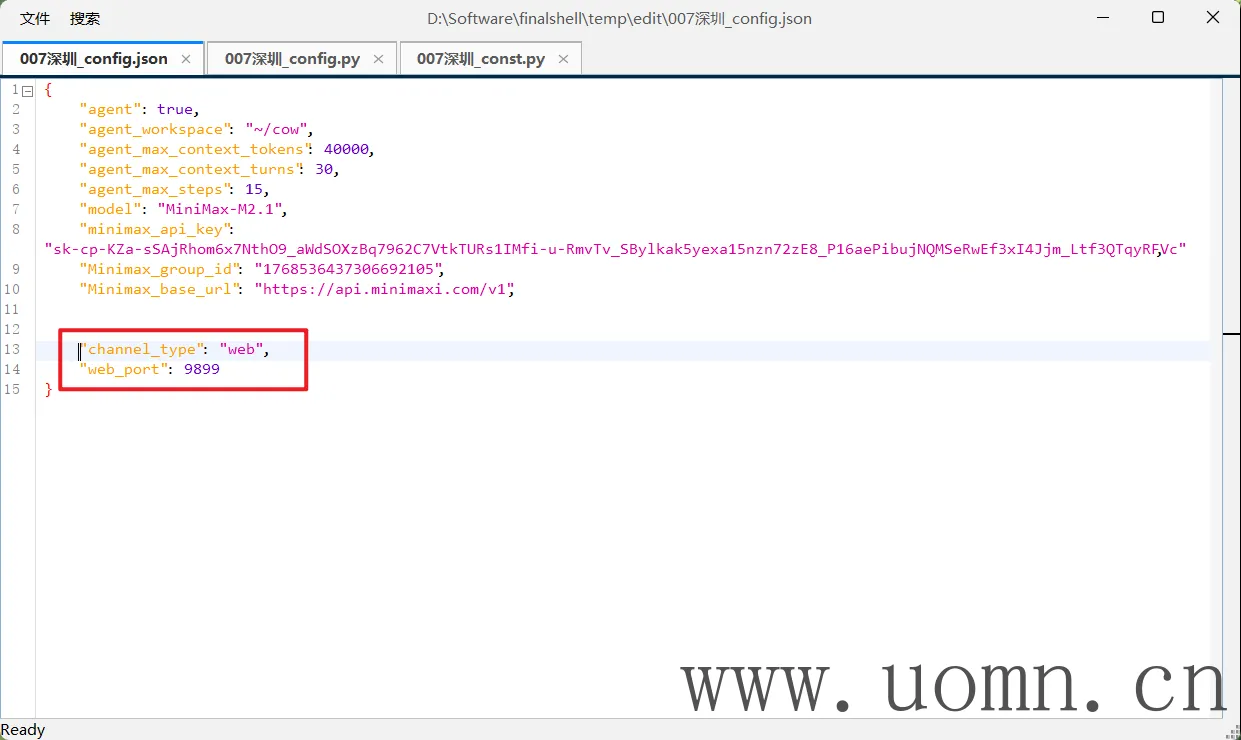

基础设置(必须)

用于启用Agent模式,配置由上到下的说明:

是否启用、工作目录、上下文最大tokens、上下文最大轮数、单次运行最大决策步数

{

"agent": true,

"agent_workspace": "~/cow",

"agent_max_context_tokens": 40000,

"agent_max_context_turns": 30,

"agent_max_steps": 15

}

模型设置(必须选一个模型)

由于agent很耗Tokens,建议用那种coding plan付费计划,就是一个月不限制tokens的,爽用

注意:所有支持的渠道配置均在项目目录下的config.py 中找到相应的配置项

模型使用(必须)

具体使用的模型由model控制,同时只能填入一个模型,但是可以让agent自行修改需要的模型,此配置必须存在

我们可以预先配置好多个模型渠道,后边可以让agent只更改模型名

{

"model": "MiniMax-M2.1"

}

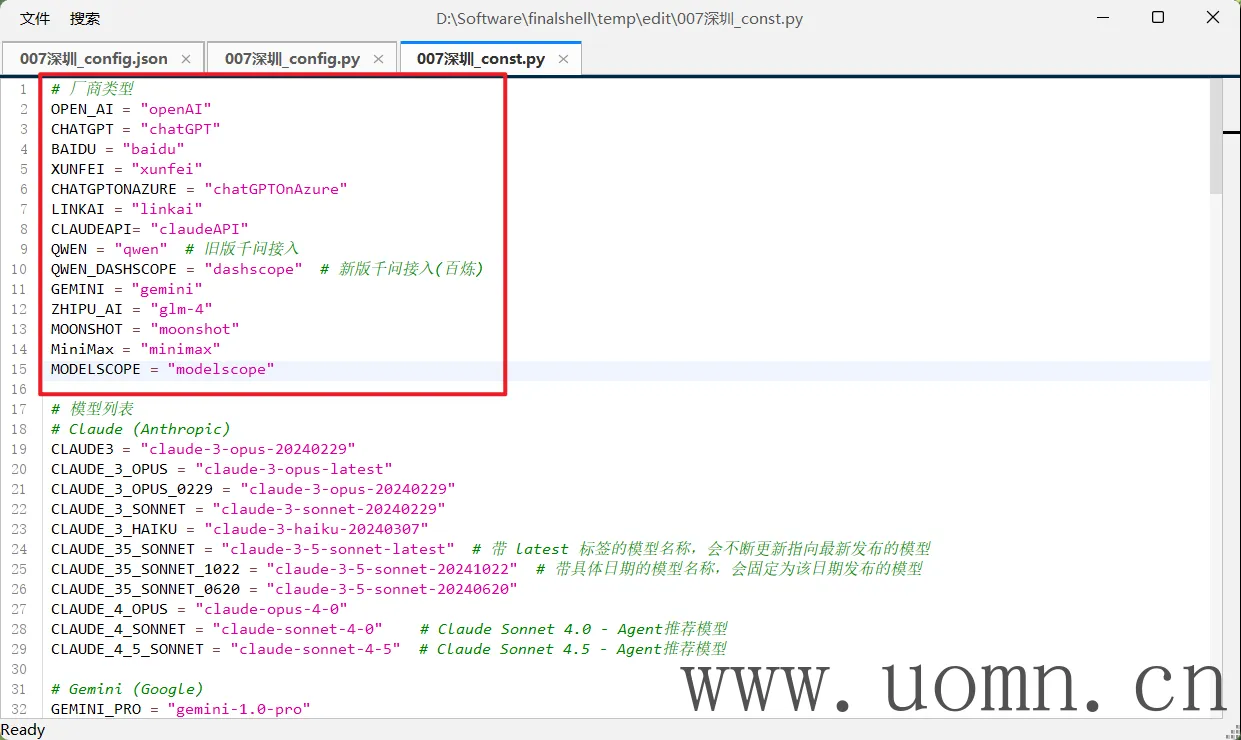

模型类型(可选)

在上边model里我们配置了模型,系统会根据模型名去匹配对应的API地址,那么当使用中转API的时候(OpenAI格式),就会出现错误的匹配API地址,这个时候就要增加模型类型的配置

注意:一旦配置了这个,后续无论使用什么模型,都只会从下方配置中对应类型的API端点发请求

{

"bot_type": "chatGPT"

}

此处变量支持的值如下图

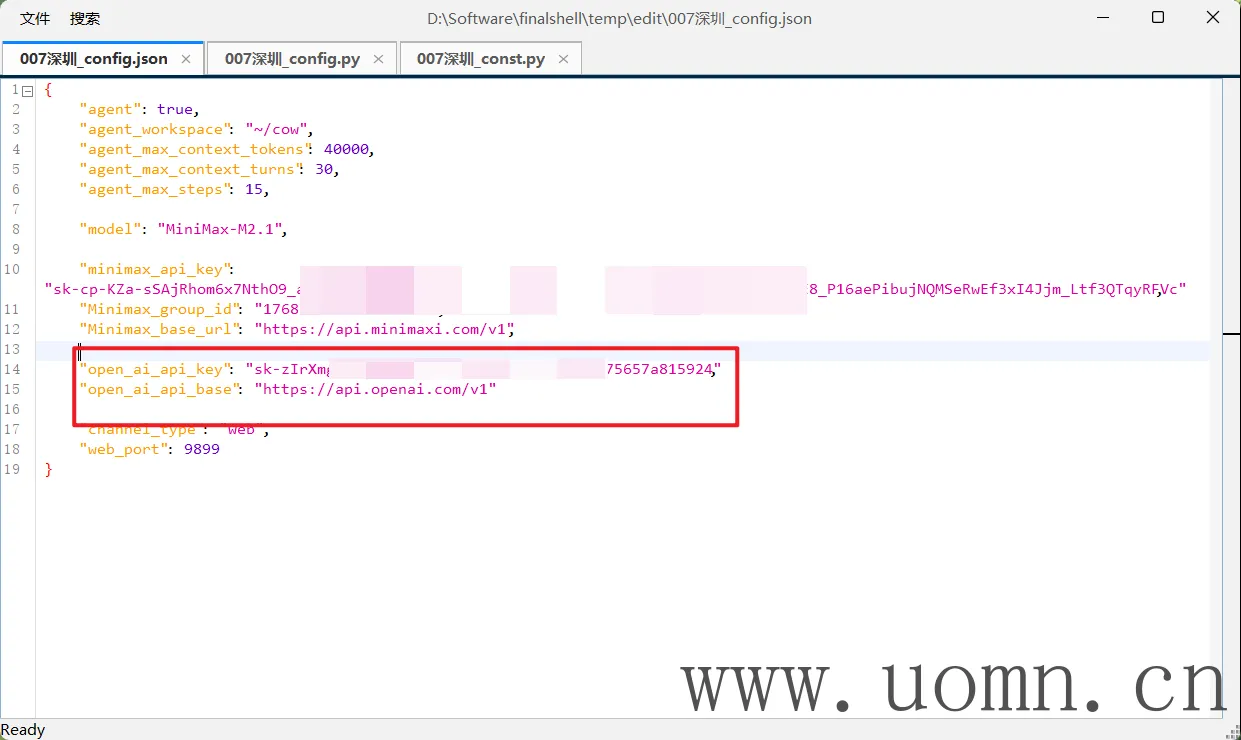

minimax(可选)

在初始化的时候我就选择接入了minimax的模型,但是实际上写入到配置文件中的配置不是完整的

所以我来补全一下配置,方便自定义

{

"minimax_api_key": "",

"Minimax_group_id": "",

"Minimax_base_url": "https://api.minimaxi.com/v1"

}

中转API(可选)

{

"model": "gpt-5.2-chat-latest",

"open_ai_api_key": "",

"open_ai_api_base": "https://api.hallucodex.com/v1"

}

Linkai(可选)

这个是COW开源团队的另一个平台,使用该平台API能够实现更多的功能,比如工作流、知识库、联网、文档等,但是也会稍贵一些

{

"use_linkai": false,

"linkai_api_key": "",

"linkai_app_code": "",

"linkai_api_base": "https://api.link-ai.tech"

}渠道配置(必须选一个渠道)

Web网页(极不推荐,危险)

访问地址:http://<服务器IP>:<服务端口>/chat

{

"channel_type": "web",

"web_port": 9899

}

终端(不存在)

我以为有终端渠道的,结果压根用不了,就酱

飞书&企微&公众号&钉钉

官方已经有教程了,这里我就不重复了

公众号

https://docs.link-ai.tech/cow/multi-platform/wechat-mp

企微应用

https://docs.link-ai.tech/cow/multi-platform/wechat-com

飞书

https://docs.link-ai.tech/cow/multi-platform/feishu

钉钉

https://docs.link-ai.tech/cow/multi-platform/dingtalk

默认评论

Halo系统提供的评论