前言

现在又改名OpenClaw了,麻了

由于没得&买不起Mac Mini,所以只能退而求其次用Linux部署,故本教程在Linux系统下进行

主要内容为程序的初始化以及接入国内的部分聊天软件,例如飞书、企微、QQ等

小贴士:不建议使用日常电脑或部署了服务的服务器,容易删库跑路呢

为了方便,所以使用的带公网的云服务器,装Debian12系统

如果没有备案域名的话,建议直接用香港的服务器,速度快一些且不用备案

如果没有合适的服务器话,可以看看下边推荐的这个,建议4C4G起步

神马?你还没有安装好用的SSH工具,可以参考下方文章安装一个(本教程使用的)

声明:本文中所安装渠道的插件均有Github,都是我在网上搜集的,安全性自查

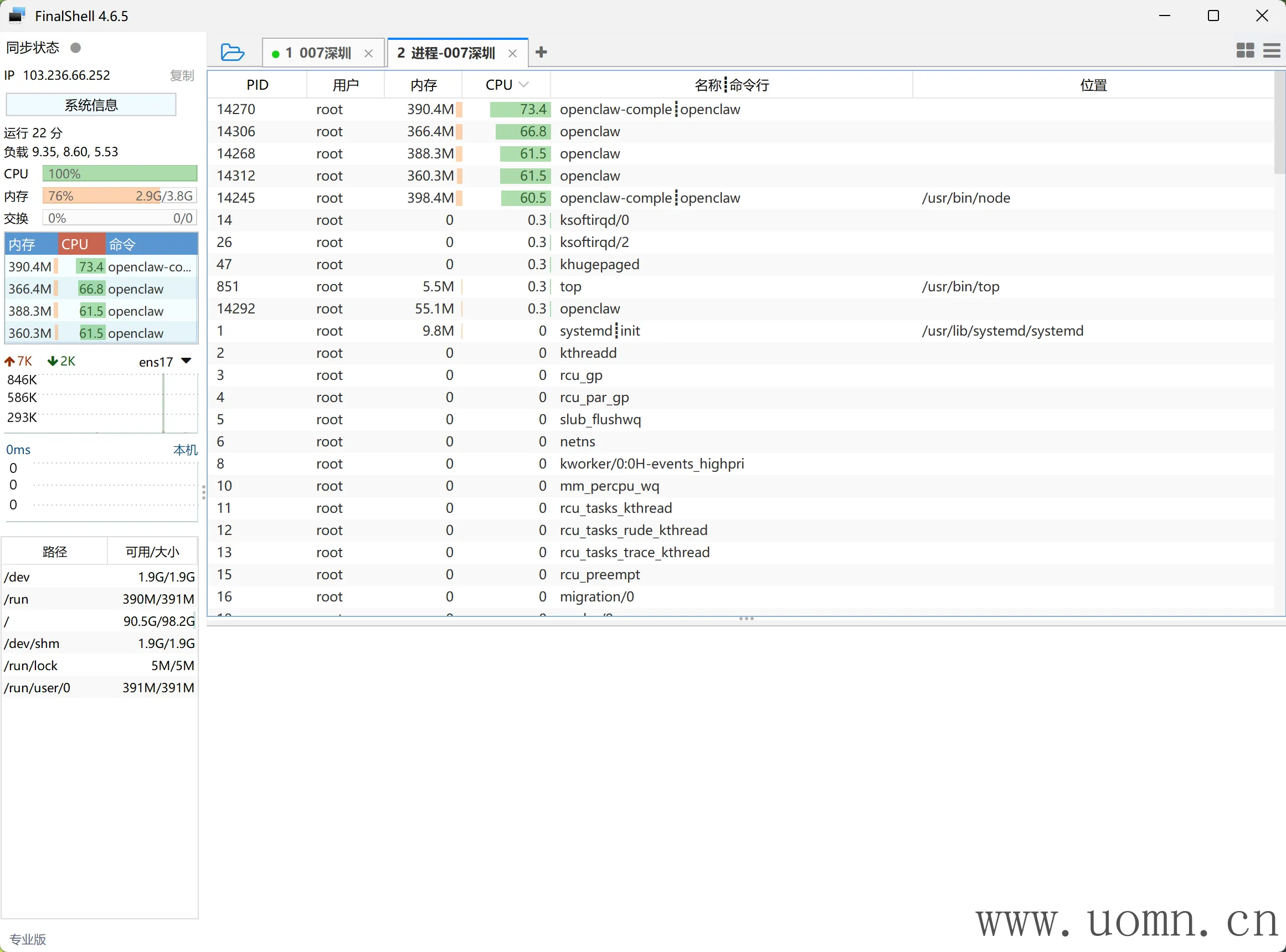

MoltBot主体部署

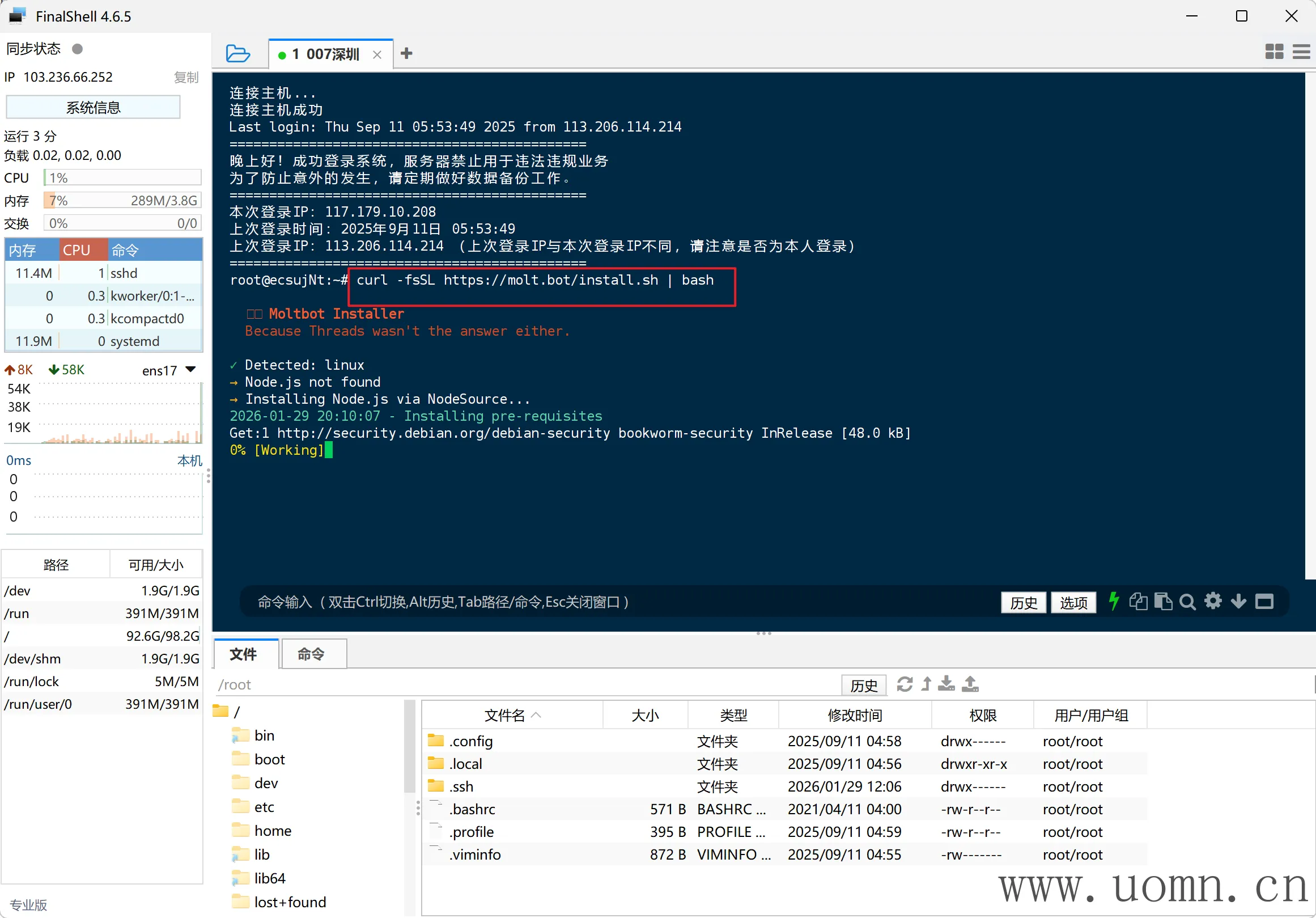

连上SSH后,执行命令进行安装

# npm config set registry https://registry.npmmirror.com

curl -fsSL https://molt.bot/install.sh | bash

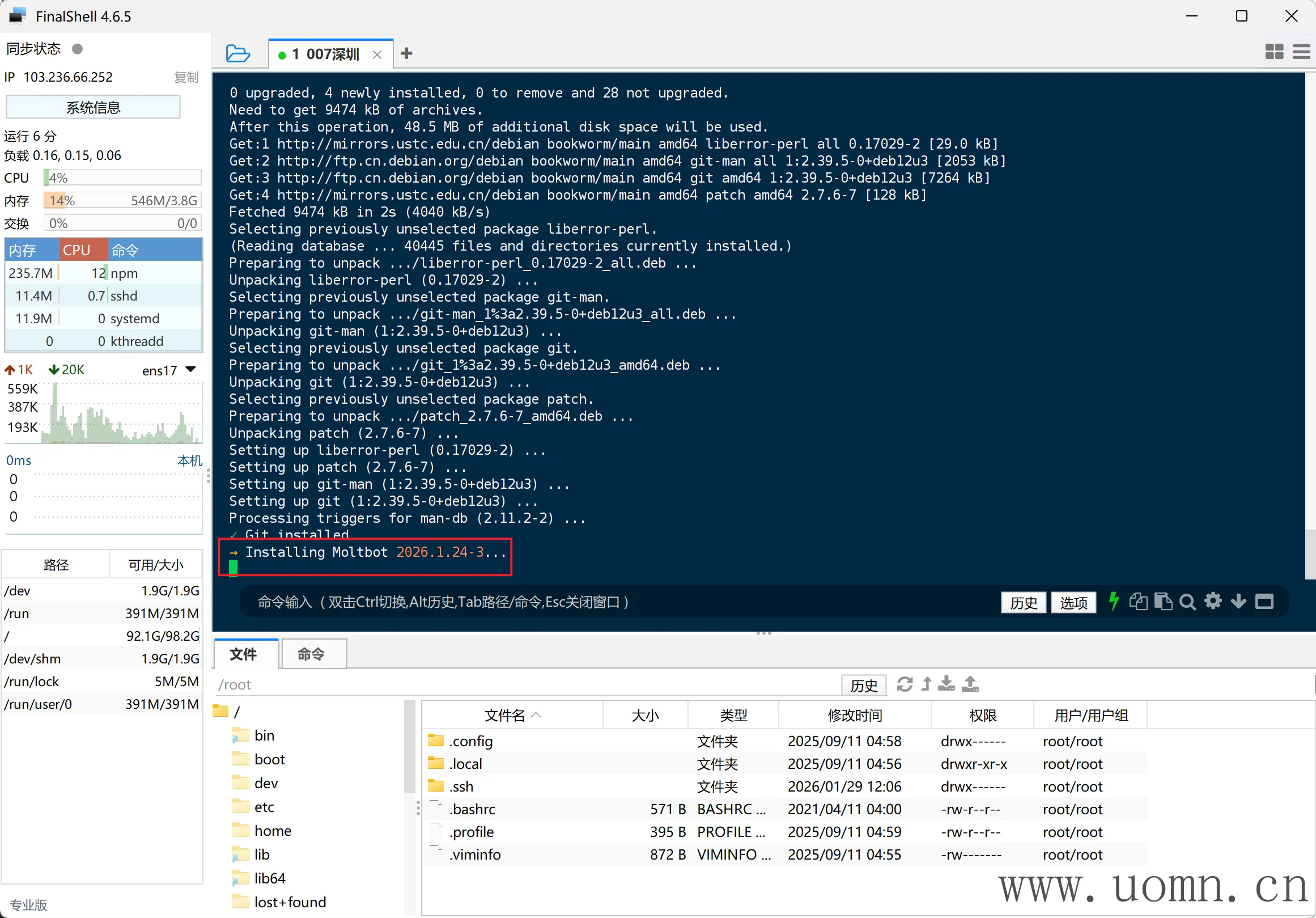

我这个服务器刚装完系统,毛都没有,所以会在执行命令后会自动下载一些必须的环境

下载到后边会一直不动,耐心等待安装完成

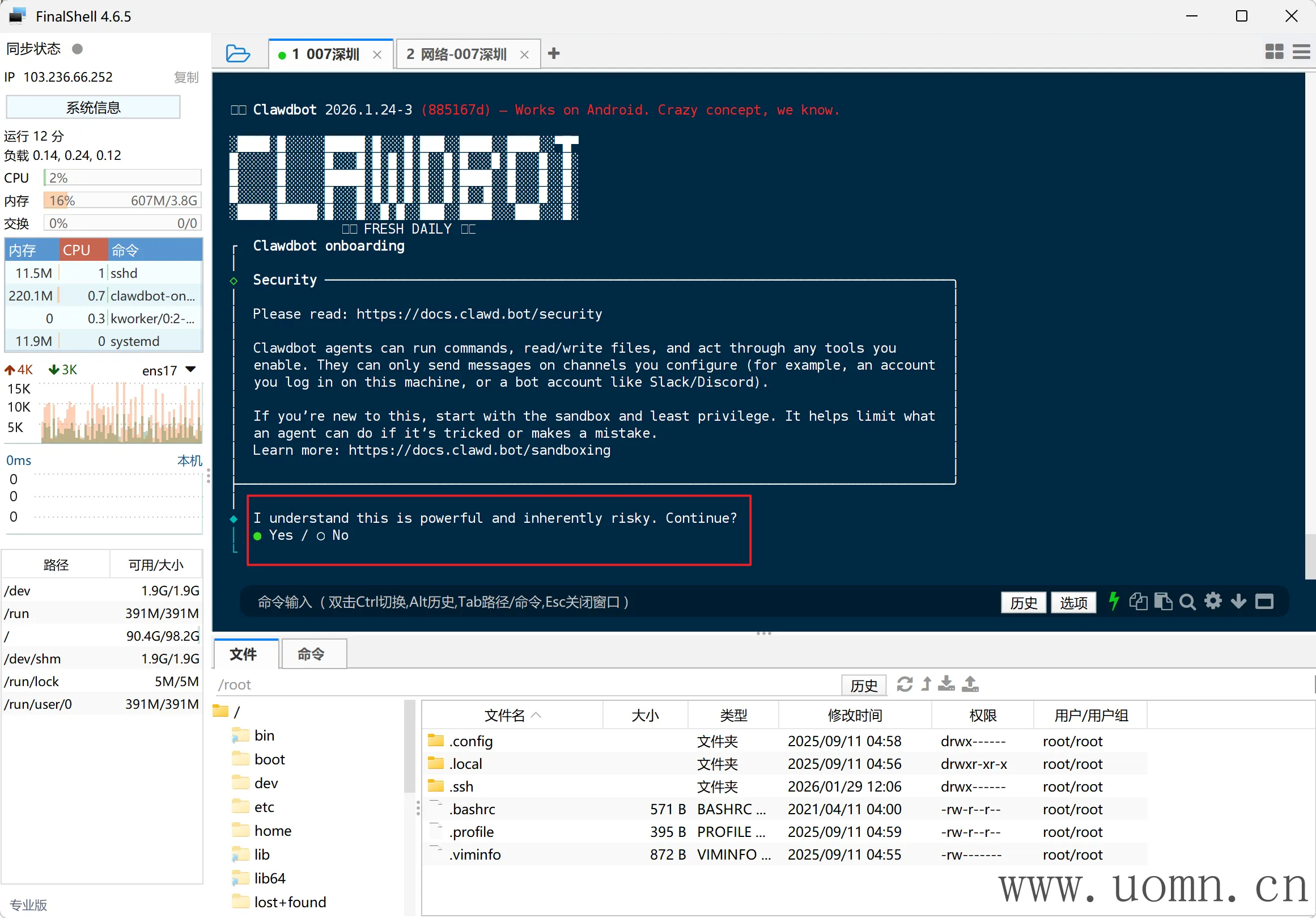

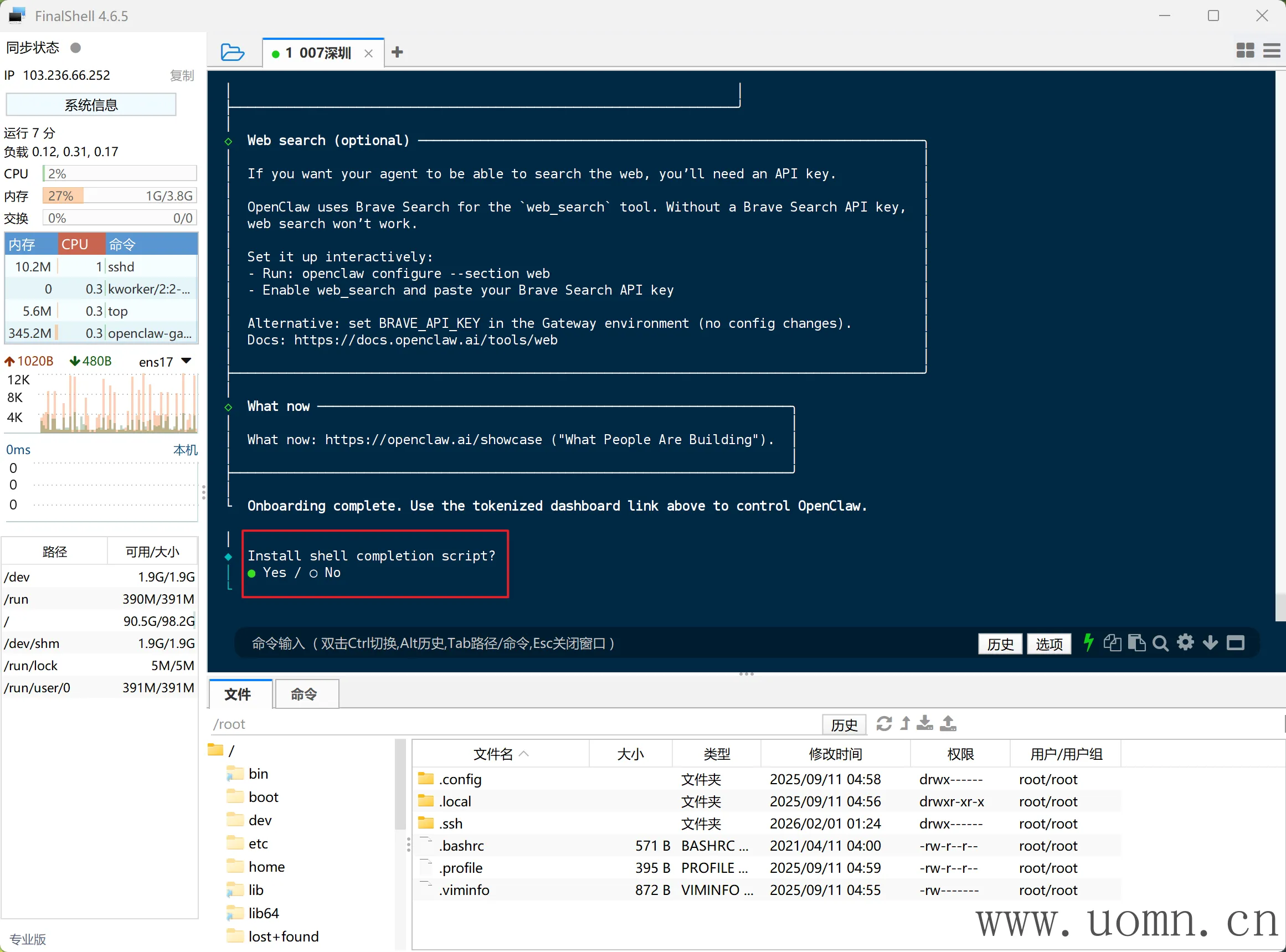

emmm,安装差不多5-10分钟,安装完成后进入初始化页面

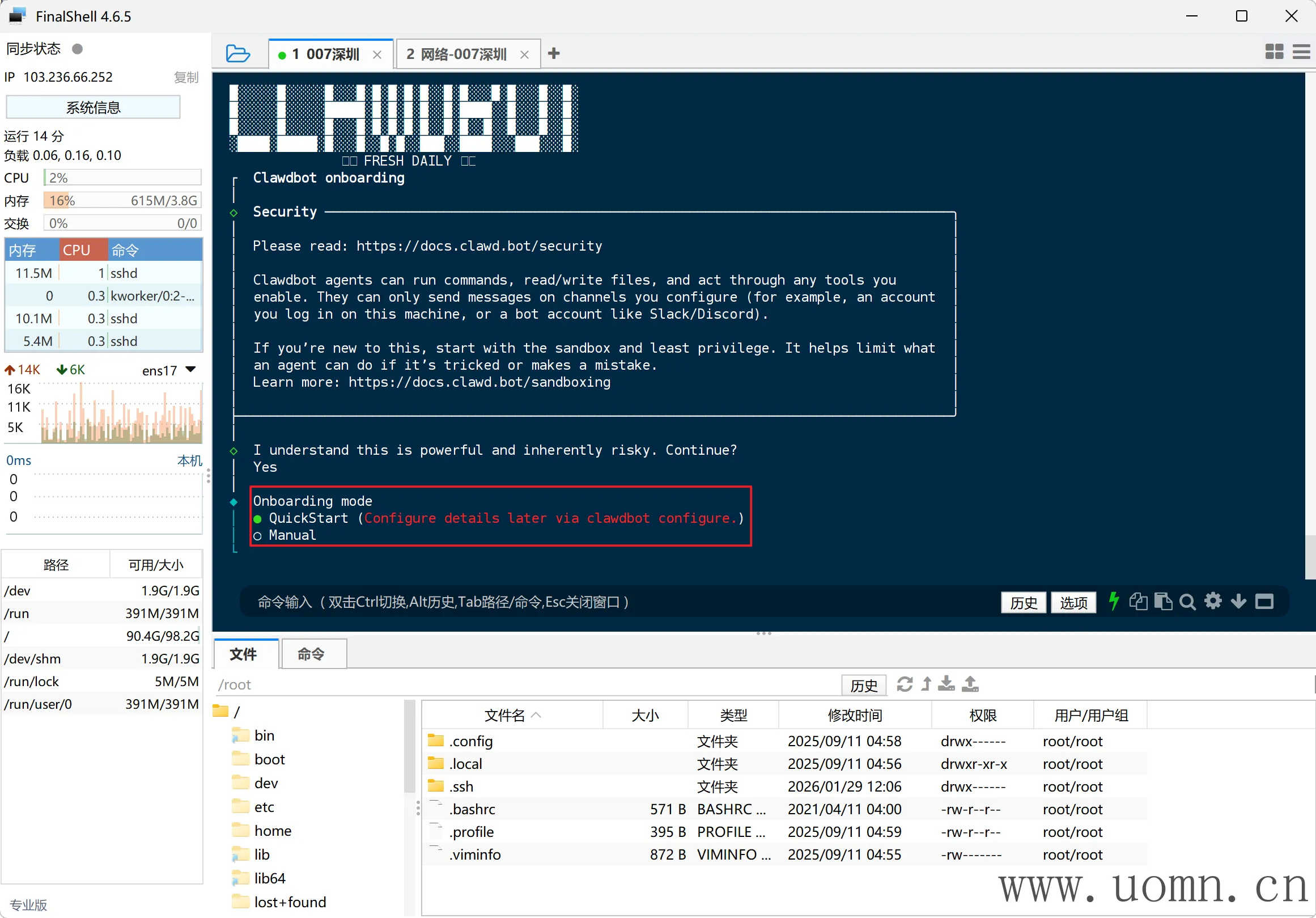

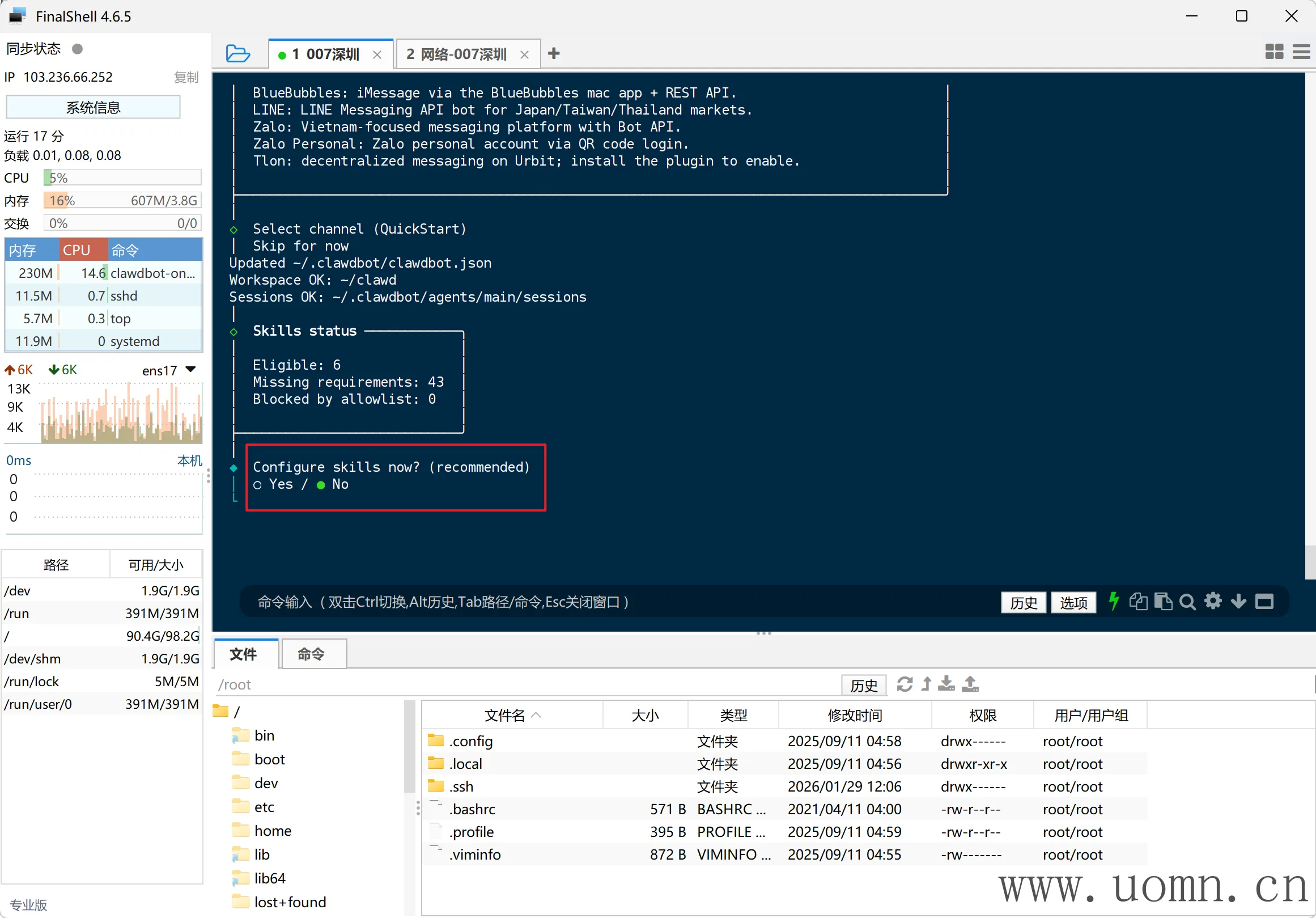

注意:后续初始化过程中,单选使用键盘上的方向键选择,多选使用空格进行选择

第一项:我知道这功能强大且本身存在风险。是否继续?选YES

第二项:引导模式。选QuickStart

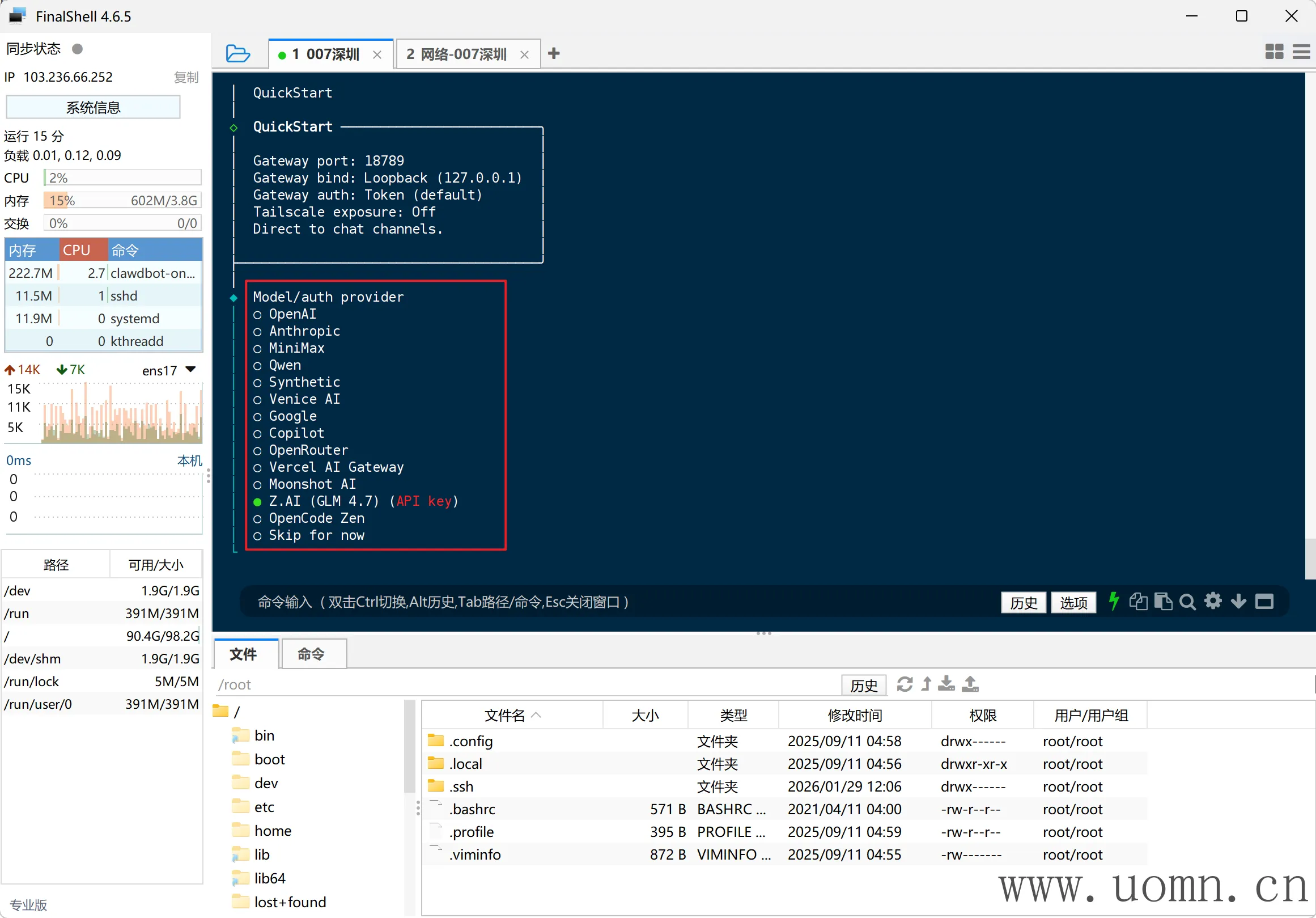

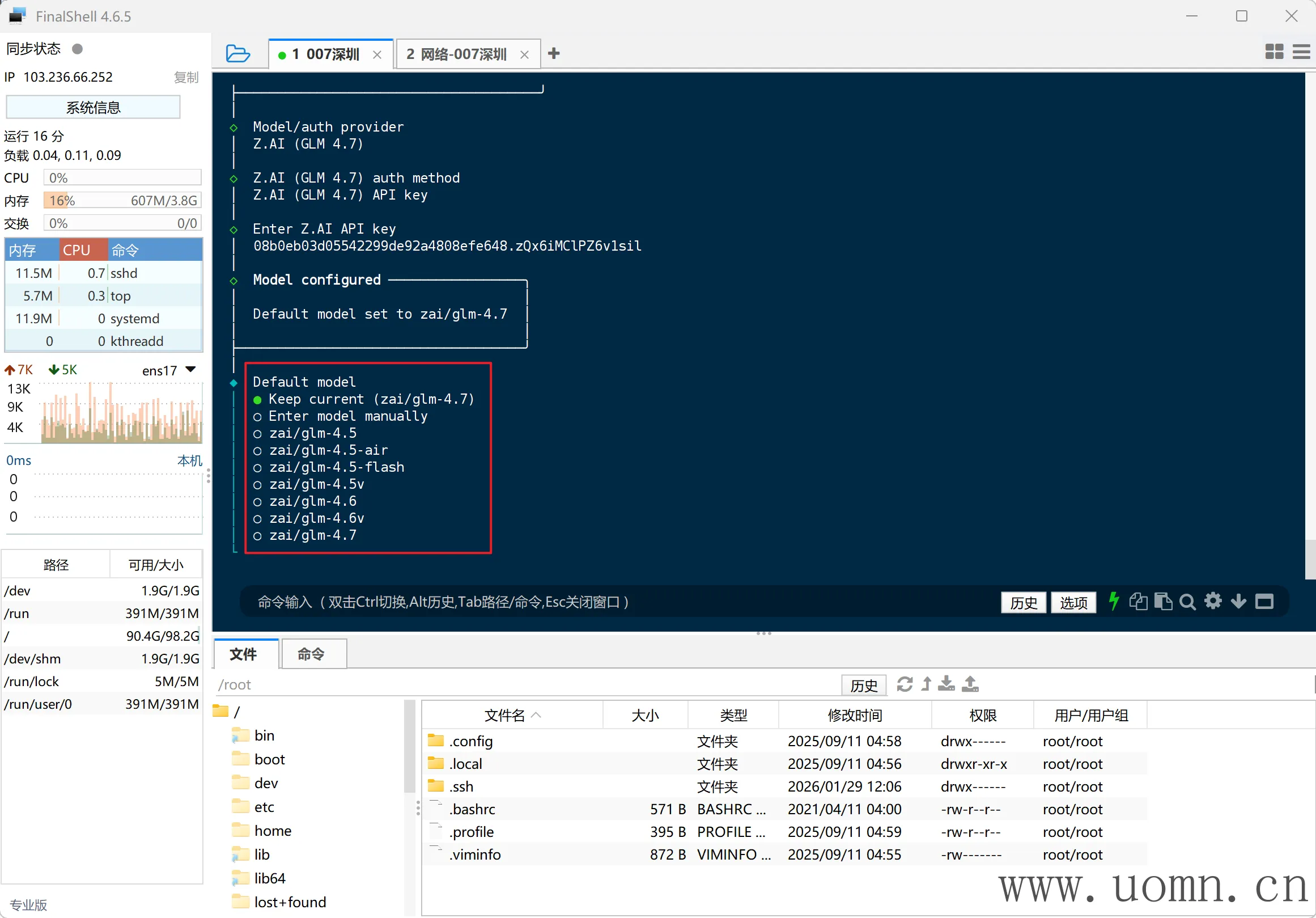

第三项:选模型,这里我就选择了GLM,我还有一点资源包没用,你们随意即可

第四项:选择默认模型,直接默认即可

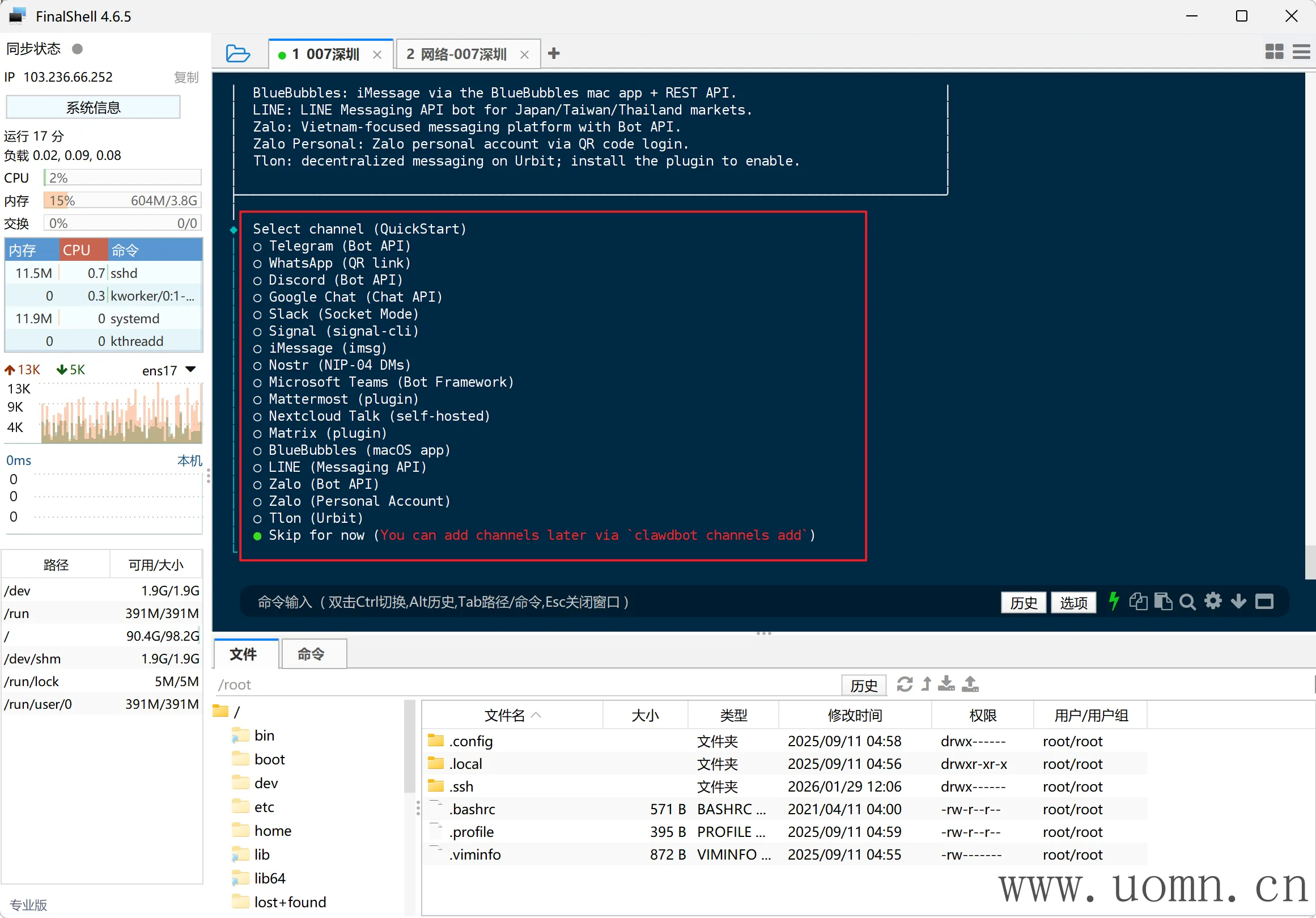

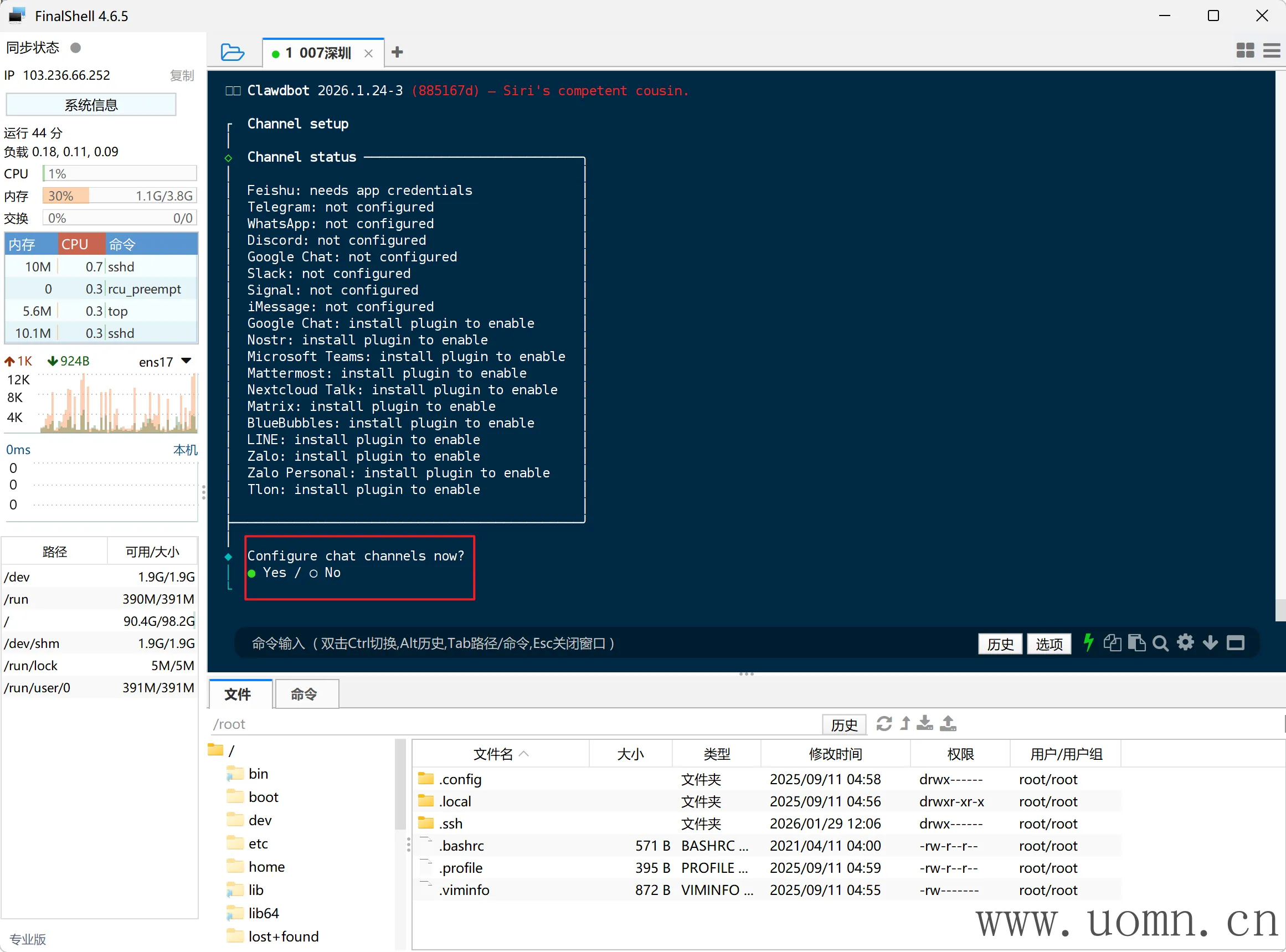

第五项:选择接入的第三方软件,这里跳过

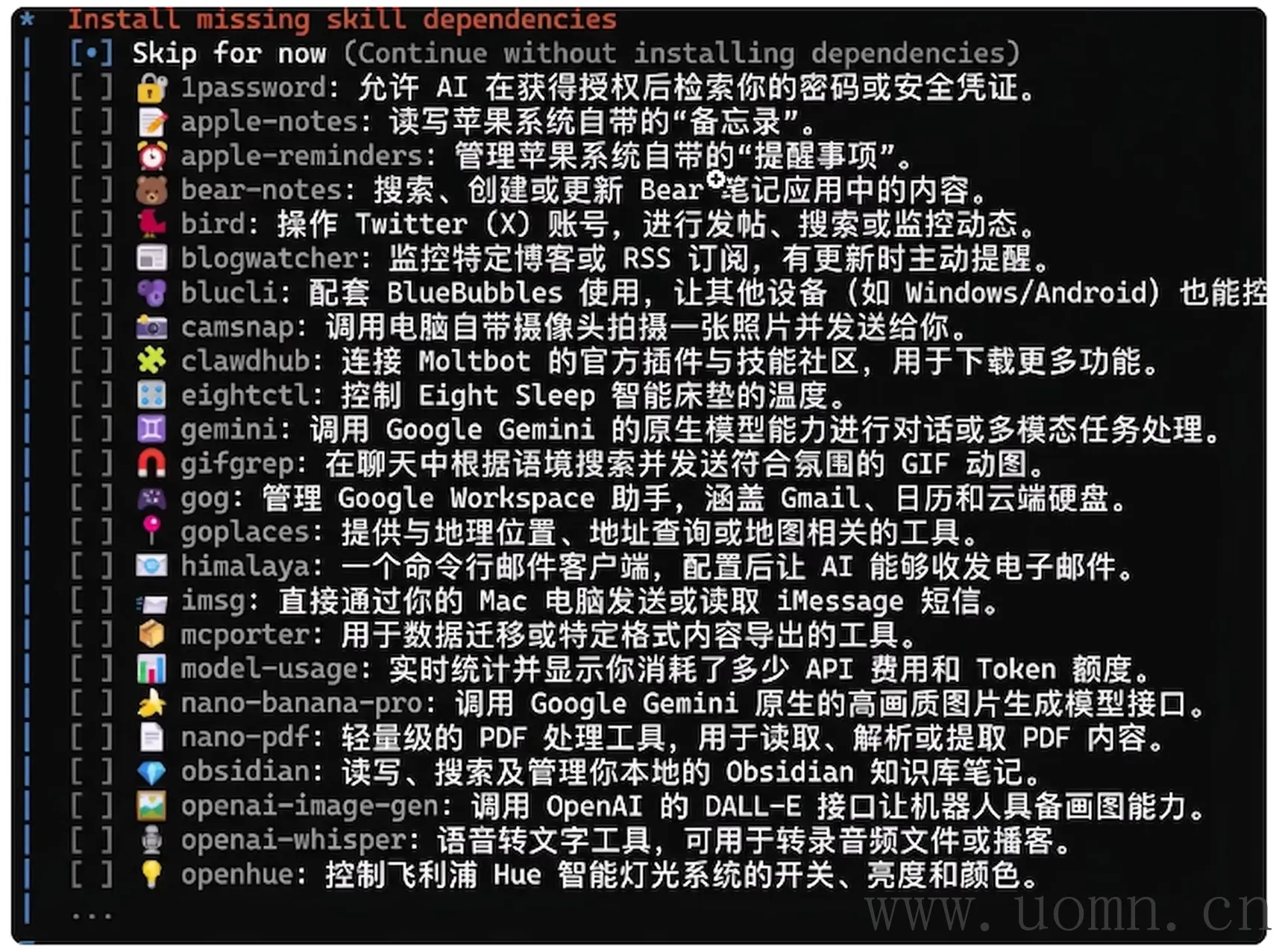

第六项:配置技能,这里先不配置

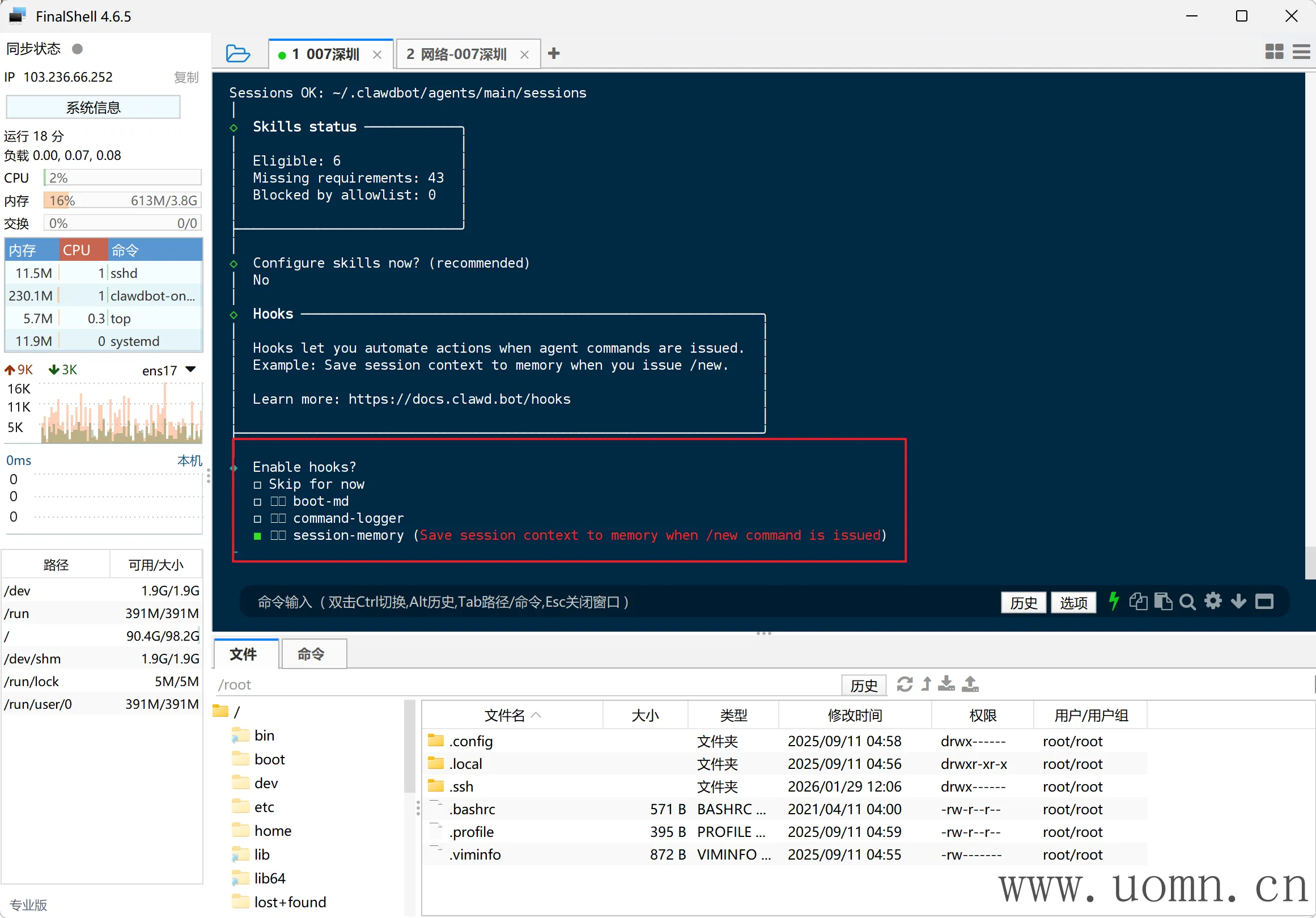

第七项:只启用这个上下文记忆就行了,都选也可以,空格选中,可多选

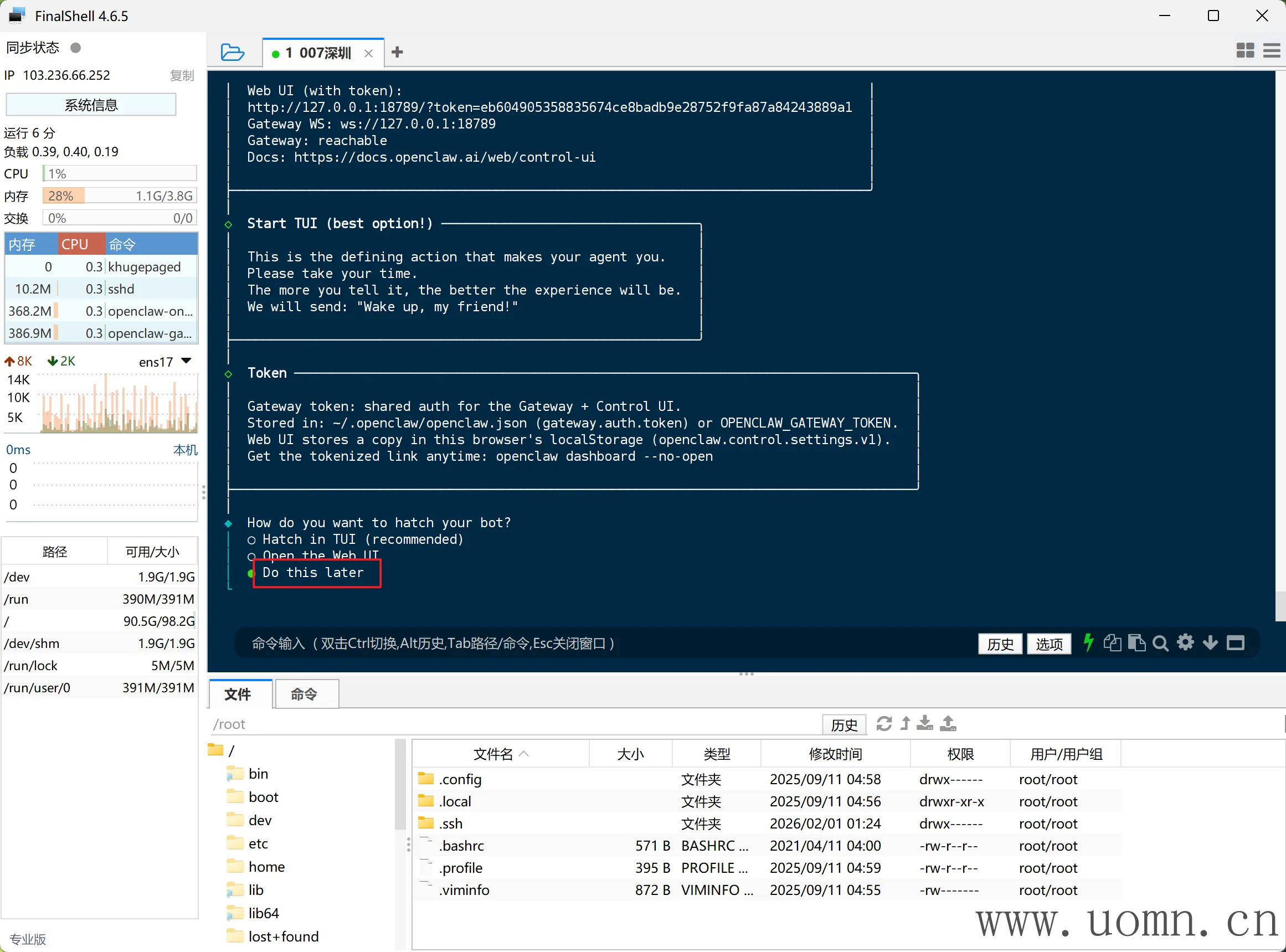

然后问你怎么用BOT,第一项是命令行直接对话,第二个是打开WebUI使用,第三个是都不用,因为后续要接入其他聊天软件,所以这里选第三个

是否安装命令补全,不安装就行

然后就进入了启动阶段,预计耗时1分钟

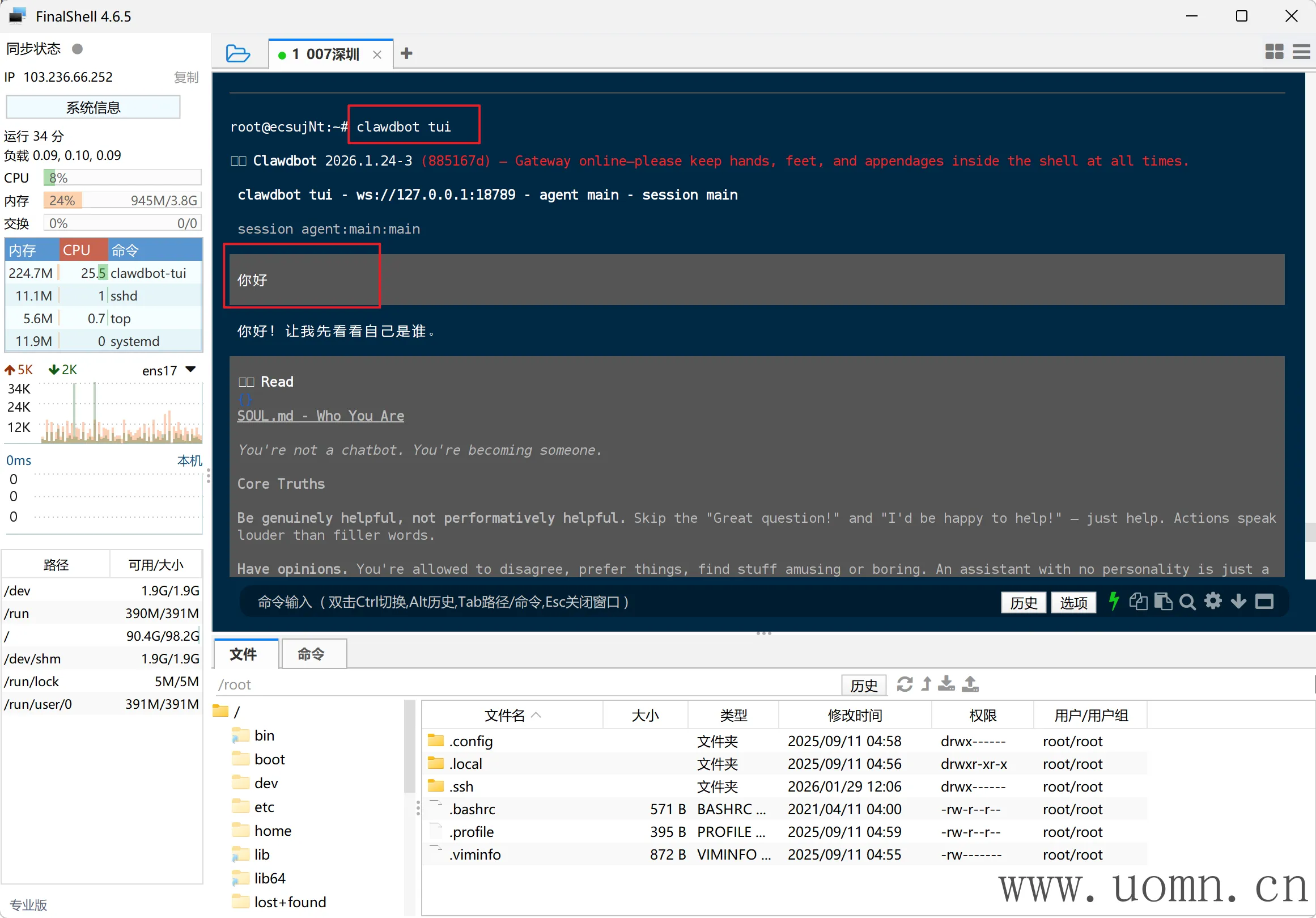

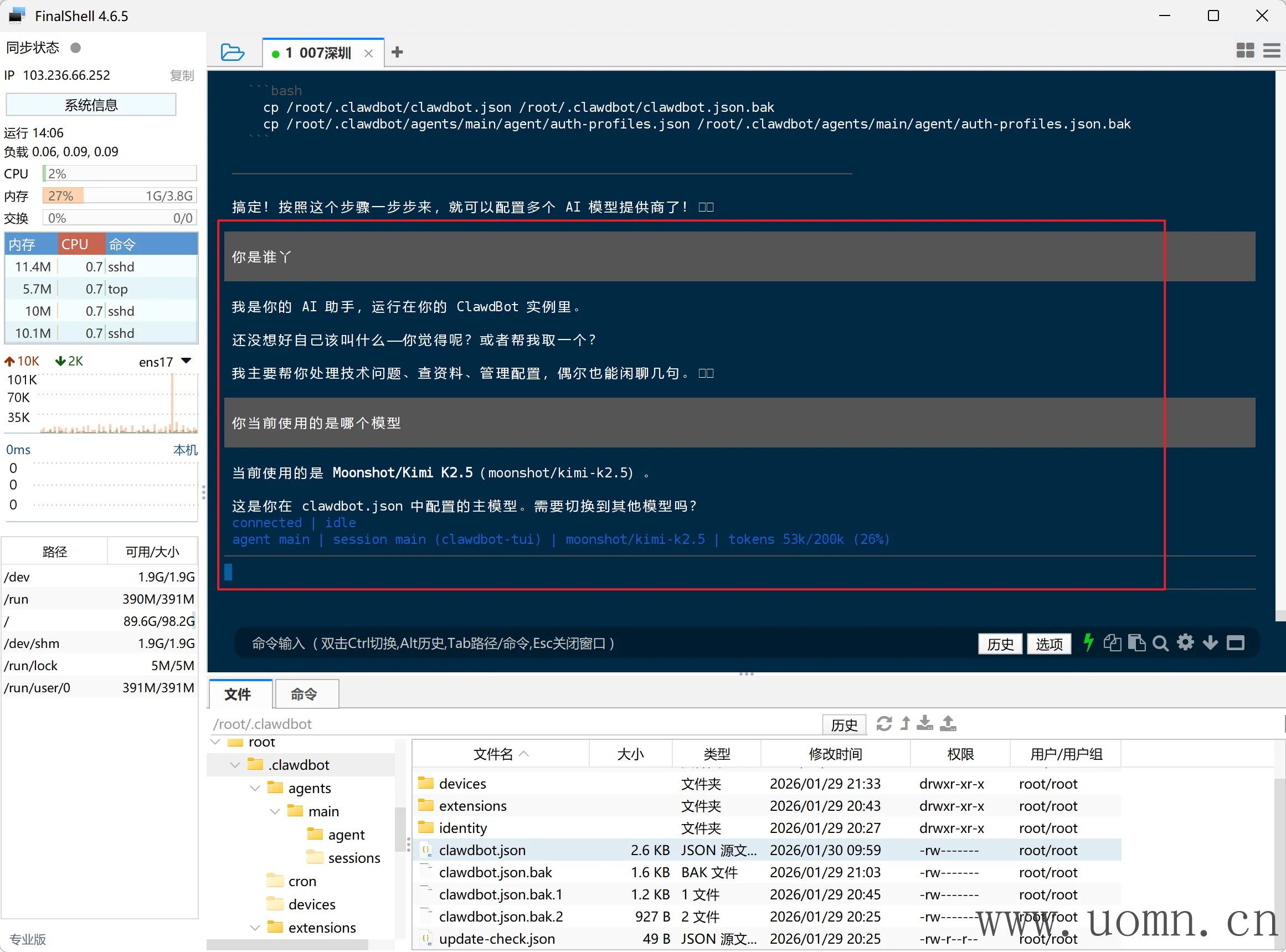

测试MoltBot

终端中执行下方命令开始进行对话

openclaw tui

如果正常回复,则说明测试通过,然后连续快速按两次Crtl+C退出

接入大模型

打算多接入几个渠道的模型(非OAuth授权的渠道),本小结教程主要是接入OpenAI兼容模型的方法

第一步就是找到配置文件,我是Linux部署的,两个需要修改的配置文件路径如下

主配置文件:/root/.openclaw/openclaw.json

模型授权相关配置文件:/root/.openclaw/agents/main/agent/auth-profiles.json

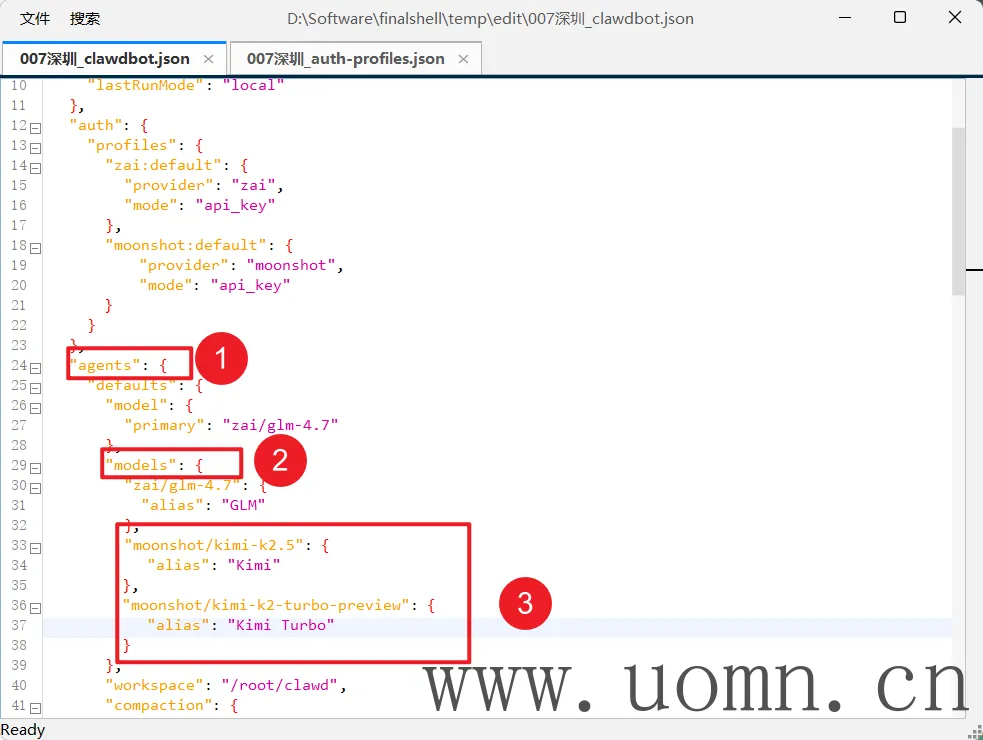

现有配置文件

目前我是接入了GLM的官方模型

openclaw.json配置文件

{

"meta": {

"lastTouchedVersion": "2026.1.24-3",

"lastTouchedAt": "2026-01-29T13:03:16.133Z"

},

"wizard": {

"lastRunAt": "2026-01-29T12:25:10.496Z",

"lastRunVersion": "2026.1.24-3",

"lastRunCommand": "onboard",

"lastRunMode": "local"

},

"auth": {

"profiles": {

"zai:default": {

"provider": "zai",

"mode": "api_key"

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "zai/glm-4.7"

},

"models": {

"zai/glm-4.7": {

"alias": "GLM"

}

},

"workspace": "/root/clawd",

"compaction": {

"mode": "safeguard"

},

"maxConcurrent": 4,

"subagents": {

"maxConcurrent": 8

}

}

},

"messages": {

"ackReactionScope": "group-mentions"

},

"commands": {

"native": "auto",

"nativeSkills": "auto"

},

"hooks": {

"internal": {

"enabled": true,

"entries": {

"session-memory": {

"enabled": true

}

}

}

},

"gateway": {

"port": 18789,

"mode": "local",

"bind": "loopback",

"auth": {

"mode": "token",

"token": "1f9b3ac5c3xxxxxxxxef9f005fa3d492"

},

"tailscale": {

"mode": "off",

"resetOnExit": false

}

}

}

auth-profiles.json配置文件

{

"version": 1,

"profiles": {

"zai:default": {

"type": "api_key",

"provider": "zai",

"key": "08b0ebxxxxxxlPZ6v1sil"

}

},

"lastGood": {

"zai": "zai:default"

},

"usageStats": {

"zai:default": {

"lastUsed": 1769730756847,

"errorCount": 0

}

}

}

理解配置含义

因我我这里不会接入所有的渠道,所以只要理解了一些配置的含义、使用方法后,就可以自行接入其他模型渠道了

# 认证配置声明,主要用于匹配auth-profiles.json文件中的授权信息

"auth": {

"profiles": {

"zai:default": {

# 模型提供商名称

"provider": "zai",

# 认证模式

"mode": "api_key"

}

}

},

# 代理配置

"agents": {

"defaults": {

"model": {

# 默认主模型,只能填一个

"primary": "zai/glm-4.7"

},

"models": {

# 模型白名单,定义允许使用的模型列表

"zai/glm-4.7": {

# 模型别名,方便命令调用

"alias": "GLM"

}

},

# 工作目录,不用管

"workspace": "/root/clawd",

"compaction": {

# 会话压缩模式,不用管

"mode": "safeguard"

},

# 最大并发会话数,不用管

"maxConcurrent": 4,

"subagents": {

# 最大子代理并发数,不用管

"maxConcurrent": 8

}

}

}模型检查

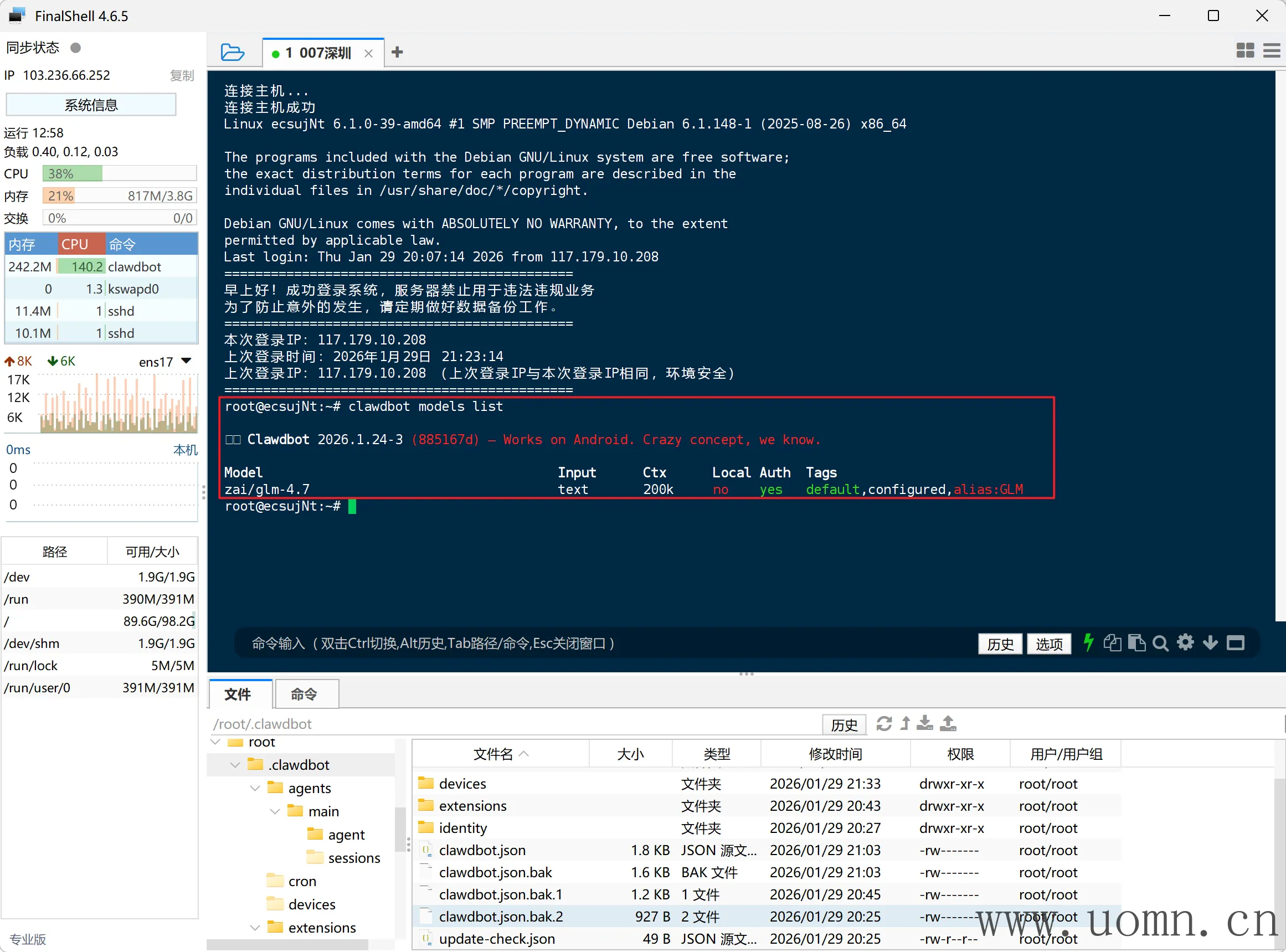

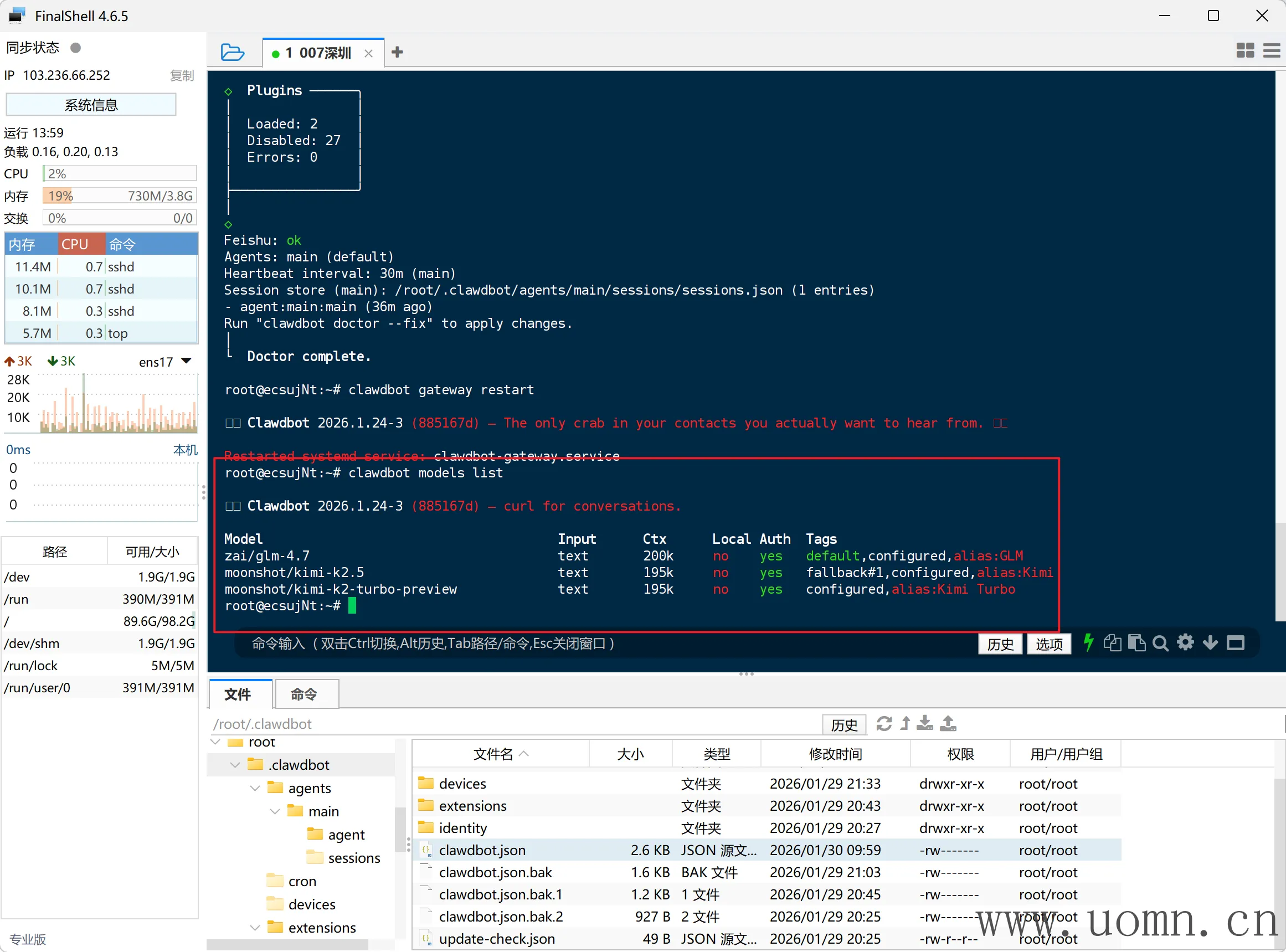

在开始前先看下当前已经启用了的模型

在终端中执行下方命令查看

openclaw models list看到我这里确实只接入了GLM

新增配置项说明

下方models的配置是在最外层的,与上边的提到的不是同一个

以月之暗面为例,这里不要开始着急修改配置文件哈

{

"models": {

# 合并模式:将自定义模型提供商与内置提供商合并,保留内置提供商的同时使用自定义提供商

"mode": "merge",

"providers": {

# 自定义提供商名称,后续引用使用`moonshot/模型名`

"moonshot": {

# 自定义API地址

"baseUrl": "https://api.moonshot.cn/v1",

# OpenAI协议

"api": "openai-completions",

# 模型列表,id是实际调用的模型名,name用于查询模型列表时展示用的

"models": [

{ "id": "kimi-k2.5", "name": "Kimi K2.5" },

{ "id": "kimi-k2-turbo-preview", "name": "Kimi K2 Turbo" },

{ "id": "moonshot-v1-8k", "name": "Moonshot v1 8K" },

{ "id": "moonshot-v1-32k", "name": "Moonshot v1 32K" }

]

}

}

}

}开始接入Kimi

第零步,先备份配置文件,在终端中执行

cp /root/.openclaw/openclaw.json /root/.openclaw/openclaw.json.bak

cp /root/.openclaw/agents/main/agent/auth-profiles.json /root/.openclaw/agents/main/agent/auth-profiles.json.bak第一步,编辑openclaw.json 文件,先新增一个认证配置,该部分配置用于匹配auth-profiles.json 文件中的密钥

"moonshot:default": {

"provider": "moonshot",

"mode": "api_key"

}

第二步,编辑auth-profiles.json 文件,新增密钥

"moonshot:default": {

"type": "api_key",

"provider": "moonshot",

"key": "你的MOONSHOT_API_KEY"

}

第三步,编辑openclaw.json 文件,接入模型提供商,此处添加的模型列表才能用于后续的使用,这个我就加载文件末尾了

"models": {

"mode": "merge",

"providers": {

"moonshot": {

"baseUrl": "https://api.moonshot.cn/v1",

"api": "openai-completions",

"models": [

{ "id": "kimi-k2.5", "name": "Kimi K2.5" },

{ "id": "kimi-k2-turbo-preview", "name": "Kimi K2 Turbo" },

{ "id": "moonshot-v1-8k", "name": "Moonshot v1 8K" },

{ "id": "moonshot-v1-32k", "name": "Moonshot v1 32K" }

]

}

}

}

第四步,编辑openclaw.json 文件,增加模型白名单,这里添加的模型,需要在第三步中的模型列表中存在的

"moonshot/kimi-k2.5": {

"alias": "Kimi"

},

"moonshot/kimi-k2-turbo-preview": {

"alias": "Kimi Turbo"

}

第五步,给当前主模型增加备选模型,即主模型噶了,自动调用备选模型,注意:备选模型可以同时填入多个

"fallbacks": [

"moonshot/kimi-k2.5"

]

合并后的配置文件如下

{

"meta": {

"lastTouchedVersion": "2026.1.24-3",

"lastTouchedAt": "2026-01-29T13:03:16.133Z"

},

"wizard": {

"lastRunAt": "2026-01-29T12:25:10.496Z",

"lastRunVersion": "2026.1.24-3",

"lastRunCommand": "onboard",

"lastRunMode": "local"

},

"auth": {

"profiles": {

"zai:default": {

"provider": "zai",

"mode": "api_key"

},

"moonshot:default": {

"provider": "moonshot",

"mode": "api_key"

}

}

},

"agents": {

"defaults": {

"model": {

"primary": "zai/glm-4.7",

"fallbacks": [

"moonshot/kimi-k2.5"

]

},

"models": {

"zai/glm-4.7": {

"alias": "GLM"

},

"moonshot/kimi-k2.5": {

"alias": "Kimi"

},

"moonshot/kimi-k2-turbo-preview": {

"alias": "Kimi Turbo"

}

},

"workspace": "/root/clawd",

"compaction": {

"mode": "safeguard"

},

"maxConcurrent": 4,

"subagents": {

"maxConcurrent": 8

}

}

},

"messages": {

"ackReactionScope": "group-mentions"

},

"commands": {

"native": "auto",

"nativeSkills": "auto"

},

"hooks": {

"internal": {

"enabled": true,

"entries": {

"session-memory": {

"enabled": true

}

}

}

},

"gateway": {

"port": 18789,

"mode": "local",

"bind": "loopback",

"auth": {

"mode": "token",

"token": "1f9b3ac5c3d504xxxxxxxx681ef9f005fa3d492"

},

"tailscale": {

"mode": "off",

"resetOnExit": false

}

},

"plugins": {

"entries": {

"feishu": {

"enabled": true

}

},

"installs": {

"feishu": {

"source": "npm",

"spec": "@m1heng-clawd/feishu",

"installPath": "/root/.openclaw/extensions/feishu",

"version": "0.1.1",

"installedAt": "2026-01-29T12:45:17.121Z"

}

}

},

"channels": {

"feishu": {

"enabled": true,

"appId": "cli_a9xxxxxx88d389cb5",

"appSecret": "0D52XjxxxxxxxxxxxxX0VyHzB",

"domain": "feishu",

"groupPolicy": "disabled"

}

},

"models": {

"mode": "merge",

"providers": {

"moonshot": {

"baseUrl": "https://api.moonshot.cn/v1",

"api": "openai-completions",

"models": [

{ "id": "kimi-k2.5", "name": "Kimi K2.5" },

{ "id": "kimi-k2-turbo-preview", "name": "Kimi K2 Turbo" },

{ "id": "moonshot-v1-8k", "name": "Moonshot v1 8K" },

{ "id": "moonshot-v1-32k", "name": "Moonshot v1 32K" }

]

}

}

}

}

{

"version": 1,

"profiles": {

"zai:default": {

"type": "api_key",

"provider": "zai",

"key": "08b0eb03d0554xxxxxxxxx6iMClPZ6v1sil"

},

"moonshot:default": {

"type": "api_key",

"provider": "moonshot",

"key": "sk-qsuPdU5xxxxxxxxxxxxxxxiIxDnDlbm"

}

},

"lastGood": {

"zai": "zai:default"

},

"usageStats": {

"zai:default": {

"lastUsed": 1769730756847,

"errorCount": 0

}

}

}

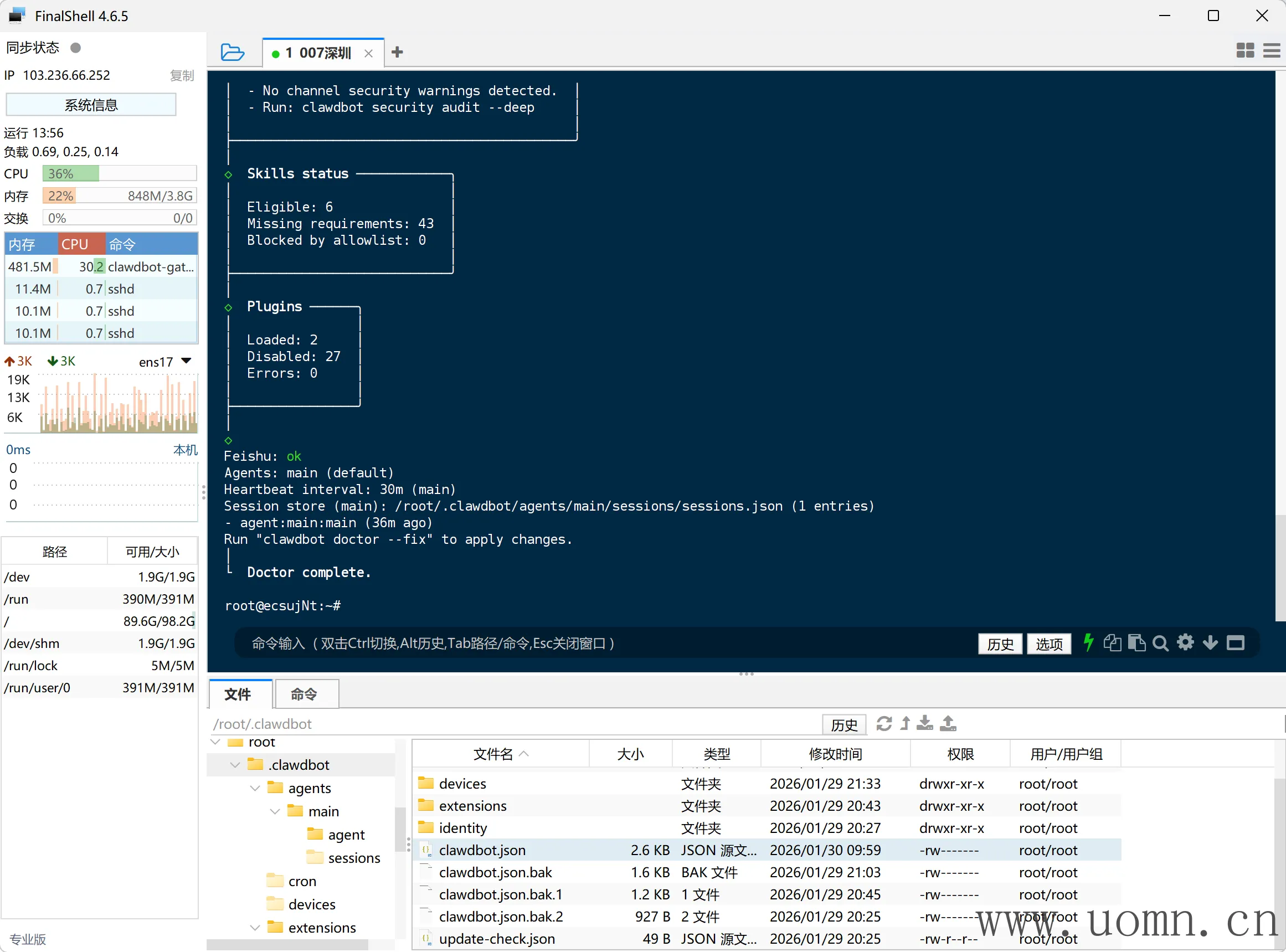

检查配置文件语法

终端执行下方命令,选择两个YES,如果最后没报错,就是没问题

openclaw doctor

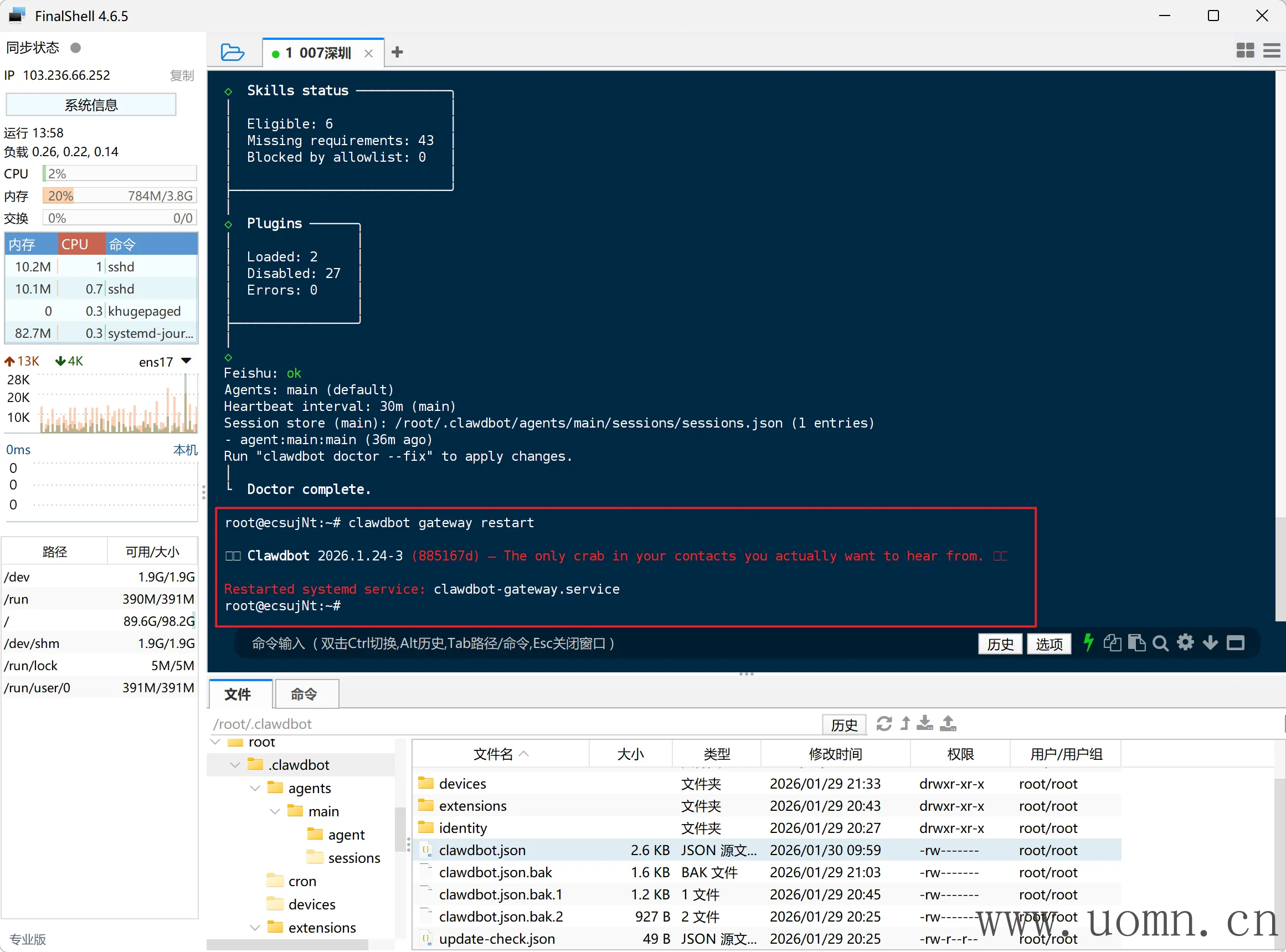

重启&检验

重启后新的配置生效

openclaw gateway restart

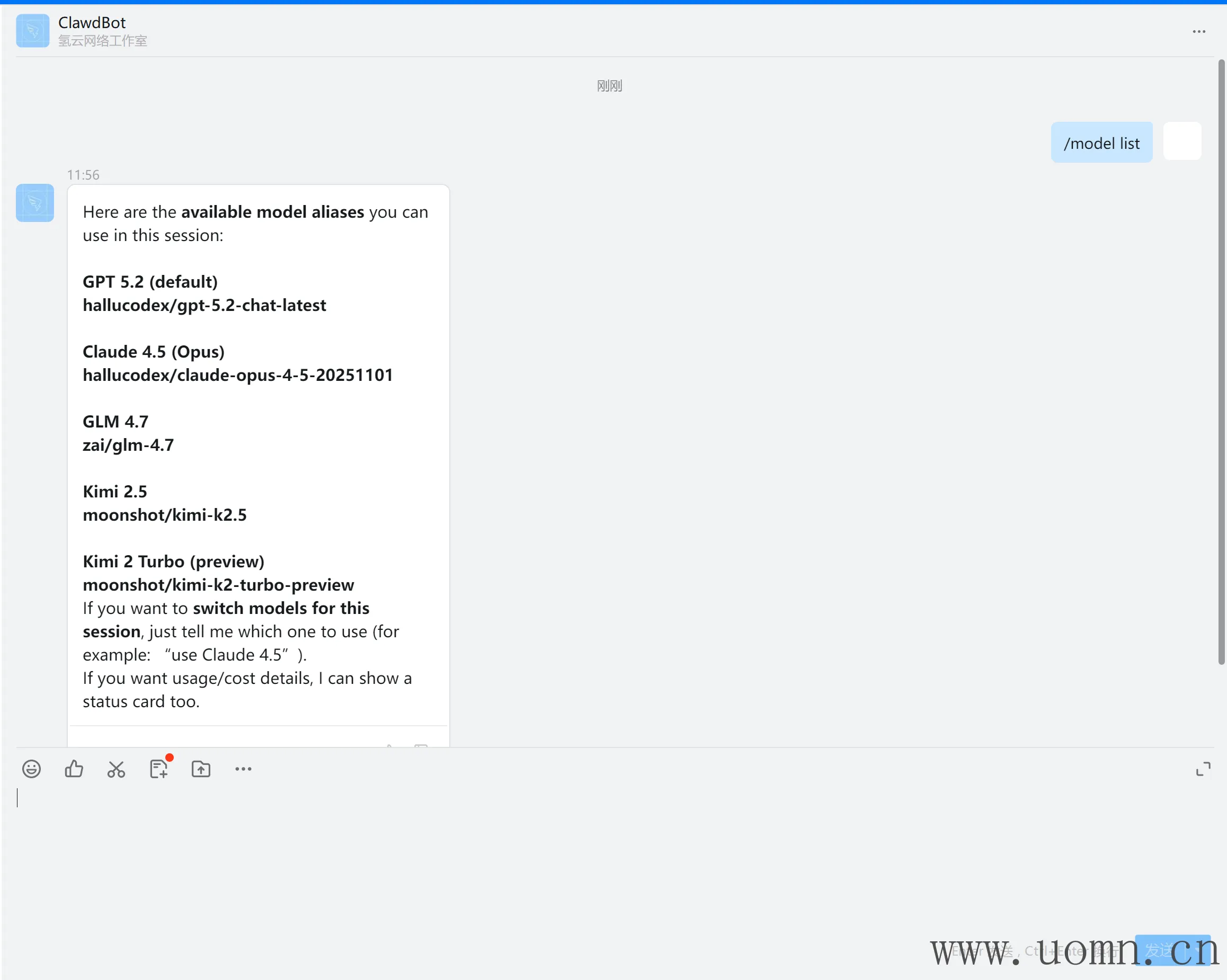

查看可用模型列表

openclaw models list

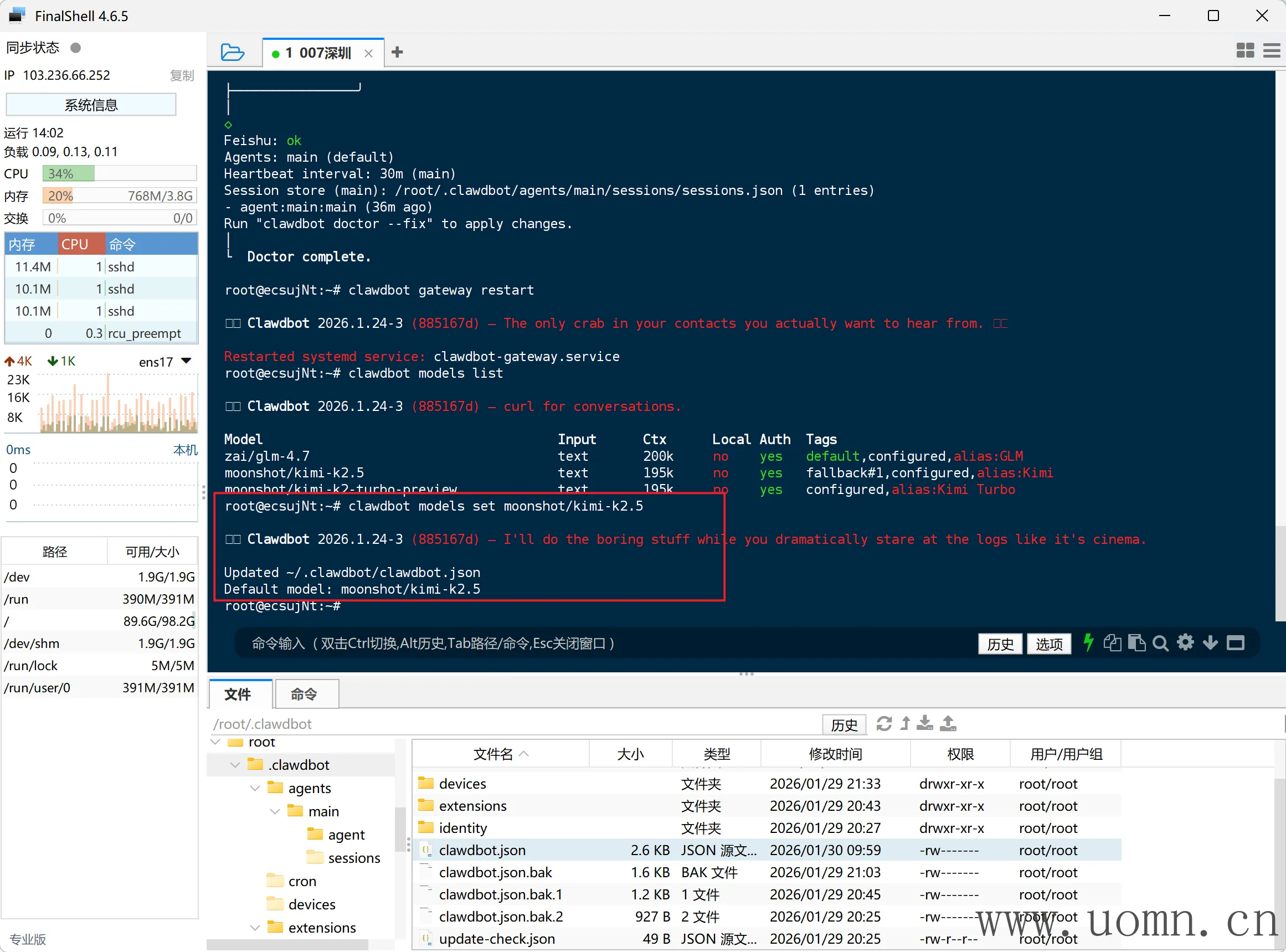

切换到Kimi模型,

openclaw models set moonshot/kimi-k2.5

测试对话,终端执行下方命令开始对话

openclaw tui

然后Kimi就这样水灵灵的接入完成了,中转API也是类似步骤,无法就是改一下模型名、API地址、密钥啥的

神马?还要来一遍中转API的接入教程?那好吧,那我就再写一个中转API的教程好了

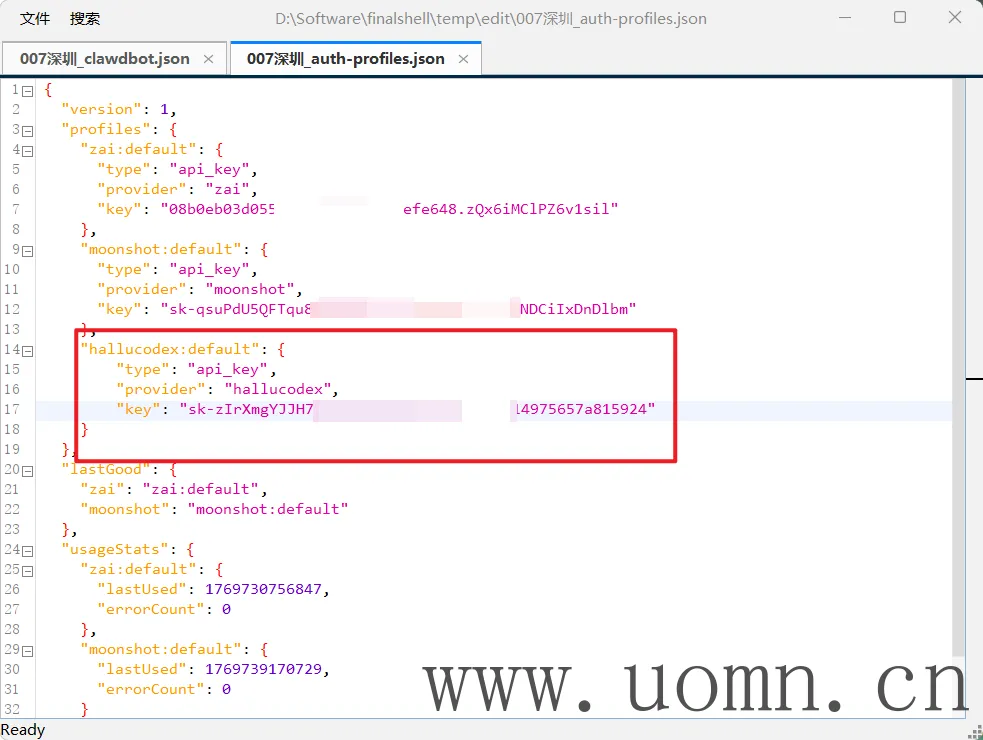

接入中转API

想要接入中转API,前提是要有一个中转API的渠道,如果没有的话,我推荐下边这个

由于我上边教程已经接过kimi的了,所以可能配置文件里边有一些变化

第零步,先备份配置文件,在终端中执行

cp /root/.openclaw/openclaw.json /root/.openclaw/openclaw.json.bak

cp /root/.openclaw/agents/main/agent/auth-profiles.json /root/.openclaw/agents/main/agent/auth-profiles.json.bak第一步,编辑openclaw.json 文件,先新增一个认证配置,该部分配置用于匹配auth-profiles.json 文件中的密钥

我使用的中转域名包含hallucodex,那我就把这个作为模型提供商的

"hallucodex:default": {

"provider": "hallucodex",

"mode": "api_key"

}

第二步,编辑auth-profiles.json 文件,新增密钥

{

"hallucodex:default": {

"type": "api_key",

"provider": "hallucodex",

"key": "sk-xxxxxxxxxxxx"

}

}

第三步,编辑openclaw.json 文件,接入模型提供商,此处添加的模型列表才能用于后续的使用。这里为了方便,我就搞了两个模型

{

"hallucodex": {

"baseUrl": "https://api.hallucodex.com/v1",

"api": "openai-completions",

"models": [

{

"id": "gpt-5.2-chat-latest",

"name": "GPT 5.2"

},

{

"id": "claude-opus-4-5-20251101",

"name": "Claude 4.5"

}

]

}

}

第四步,编辑openclaw.json 文件,增加模型白名单,这里添加的模型,需要在第三步中的模型列表中存在的

{

"hallucodex/gpt-5.2-chat-latest": {

"alias": "GPT 5.2"

},

"hallucodex/claude-opus-4-5-20251101": {

"alias": "Claude 4.5"

}

}

第五步,给当前主模型增加备选模型,即主模型噶了,自动调用备选模型,注意:备选模型可以同时填入多个

"hallucodex/gpt-5.2-chat-latest",

"hallucodex/claude-opus-4-5-20251101"

第六步,新增视图模型,这两个中转模型都支持图片理解,所以这里顺手加上

{

"imageModel": {

"primary": "hallucodex/gpt-5.2-chat-latest",

"fallbacks": [

"hallucodex/claude-opus-4-5-20251101"

]

}

}

合并后的配置文件如下

{

"meta": {

"lastTouchedVersion": "2026.1.24-3",

"lastTouchedAt": "2026-01-30T02:08:15.927Z"

},

"wizard": {

"lastRunAt": "2026-01-29T12:25:10.496Z",

"lastRunVersion": "2026.1.24-3",

"lastRunCommand": "onboard",

"lastRunMode": "local"

},

"auth": {

"profiles": {

"zai:default": {

"provider": "zai",

"mode": "api_key"

},

"moonshot:default": {

"provider": "moonshot",

"mode": "api_key"

},

"hallucodex:default": {

"provider": "hallucodex",

"mode": "api_key"

}

}

},

"models": {

"mode": "merge",

"providers": {

"hallucodex": {

"baseUrl": "https://api.hallucodex.com/v1",

"api": "openai-completions",

"models": [

{

"id": "gpt-5.2-chat-latest",

"name": "GPT 5.2"

},

{

"id": "claude-opus-4-5-20251101",

"name": "Claude 4.5"

}

]

},

"moonshot": {

"baseUrl": "https://api.moonshot.cn/v1",

"api": "openai-completions",

"models": [

{

"id": "kimi-k2.5",

"name": "Kimi K2.5",

"reasoning": false,

"input": [

"text"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

},

"contextWindow": 200000,

"maxTokens": 8192

},

{

"id": "kimi-k2-turbo-preview",

"name": "Kimi K2 Turbo",

"reasoning": false,

"input": [

"text"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

},

"contextWindow": 200000,

"maxTokens": 8192

},

{

"id": "moonshot-v1-8k",

"name": "Moonshot v1 8K",

"reasoning": false,

"input": [

"text"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

},

"contextWindow": 200000,

"maxTokens": 8192

},

{

"id": "moonshot-v1-32k",

"name": "Moonshot v1 32K",

"reasoning": false,

"input": [

"text"

],

"cost": {

"input": 0,

"output": 0,

"cacheRead": 0,

"cacheWrite": 0

},

"contextWindow": 200000,

"maxTokens": 8192

}

]

}

}

},

"agents": {

"defaults": {

"model": {

"fallbacks": [

"moonshot/kimi-k2.5",

"hallucodex/gpt-5.2-chat-latest",

"hallucodex/claude-opus-4-5-20251101"

],

"primary": "moonshot/kimi-k2.5",

"imageModel": {

"primary": "hallucodex/gpt-5.2-chat-latest",

"fallbacks": [

"hallucodex/claude-opus-4-5-20251101"

]

}

},

"models": {

"zai/glm-4.7": {

"alias": "GLM"

},

"moonshot/kimi-k2.5": {

"alias": "Kimi"

},

"moonshot/kimi-k2-turbo-preview": {

"alias": "Kimi Turbo"

},

"hallucodex/gpt-5.2-chat-latest": {

"alias": "GPT 5.2"

},

"hallucodex/claude-opus-4-5-20251101": {

"alias": "Claude 4.5"

}

},

"workspace": "/root/clawd",

"compaction": {

"mode": "safeguard"

},

"maxConcurrent": 4,

"subagents": {

"maxConcurrent": 8

}

}

},

"messages": {

"ackReactionScope": "group-mentions"

},

"commands": {

"native": "auto",

"nativeSkills": "auto"

},

"hooks": {

"internal": {

"enabled": true,

"entries": {

"session-memory": {

"enabled": true

}

}

}

},

"channels": {

"feishu": {

"enabled": true,

"appId": "cli_axxxxxx389cb5",

"appSecret": "0D52xxxxxxpteDPIX0VyHzB",

"domain": "feishu",

"groupPolicy": "disabled"

}

},

"gateway": {

"port": 18789,

"mode": "local",

"bind": "loopback",

"auth": {

"mode": "token",

"token": "1f9b3axxxxxxxxxx5fa3d492"

},

"tailscale": {

"mode": "off",

"resetOnExit": false

}

},

"plugins": {

"entries": {

"feishu": {

"enabled": true

}

},

"installs": {

"feishu": {

"source": "npm",

"spec": "@m1heng-clawd/feishu",

"installPath": "/root/.openclaw/extensions/feishu",

"version": "0.1.1",

"installedAt": "2026-01-29T12:45:17.121Z"

}

}

}

}{

"version": 1,

"profiles": {

"zai:default": {

"type": "api_key",

"provider": "zai",

"key": "08b0eb03xxxxxxxzQx6iMClPZ6v1sil"

},

"moonshot:default": {

"type": "api_key",

"provider": "moonshot",

"key": "sk-qsuPxxxxxxxxx9H5gNDCiIxDnDlbm"

},

"hallucodex:default": {

"type": "api_key",

"provider": "hallucodex",

"key": "sk-zIrxxxxxxxxx657a815924"

}

},

"lastGood": {

"zai": "zai:default",

"moonshot": "moonshot:default",

"hallucodex": "hallucodex:default"

},

"usageStats": {

"zai:default": {

"lastUsed": 1769730756847,

"errorCount": 0

},

"moonshot:default": {

"lastUsed": 1769739170729,

"errorCount": 0

}

}

}检查配置语法、重启&检验的步骤,看上边接入Kimi时的教程,都一样的,就不重复了

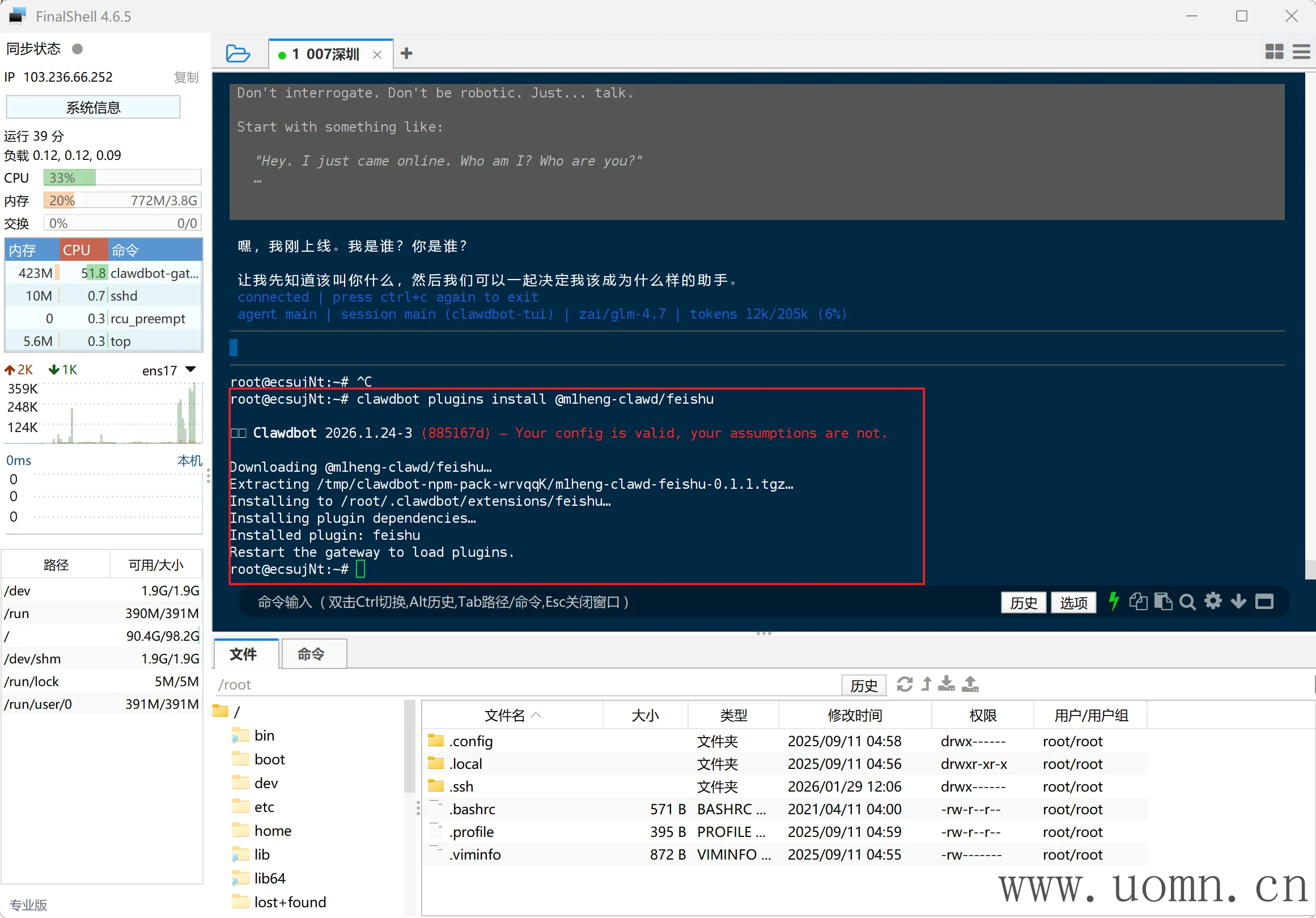

接入飞书

安装飞书渠道

官方库:https://github.com/m1heng/clawdbot-feishu

在终端中输入下方命令进行安装,预计安装耗时3-5分钟

openclaw plugins install @m1heng-clawd/feishu

# npm install @m1heng-clawd/feishu --registry https://registry.npmmirror.com

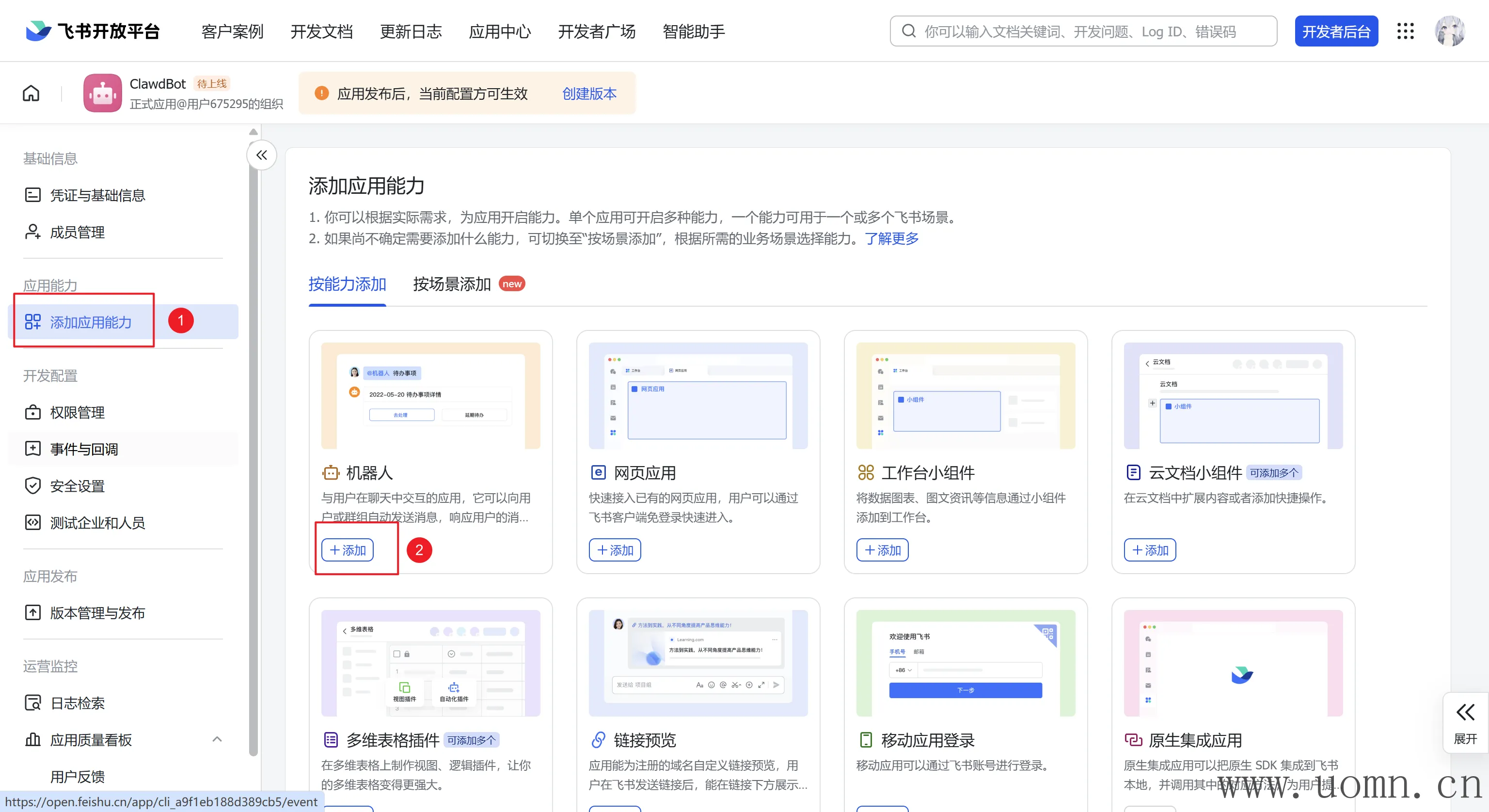

创建飞书机器人

打开飞书开放平台:https://open.feishu.cn/

创建企业自建应用

然后填一下应用名称和描述

添加机器人的应用能力

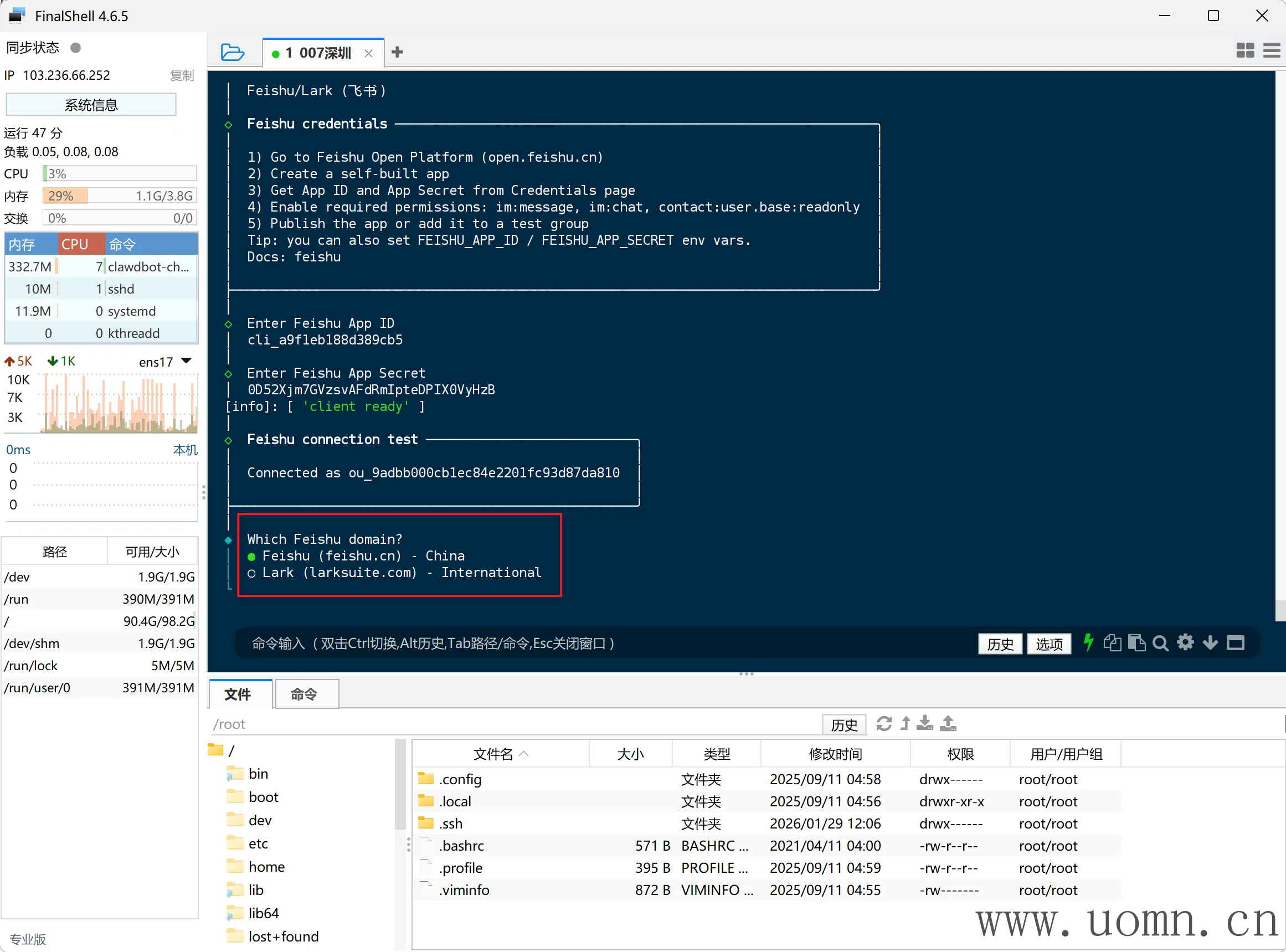

接入飞书机器人

emmm,还是先把openclaw的飞书渠道添加一下吧

返回终端执行下方命令,你就会发现飞书的渠道多出来了

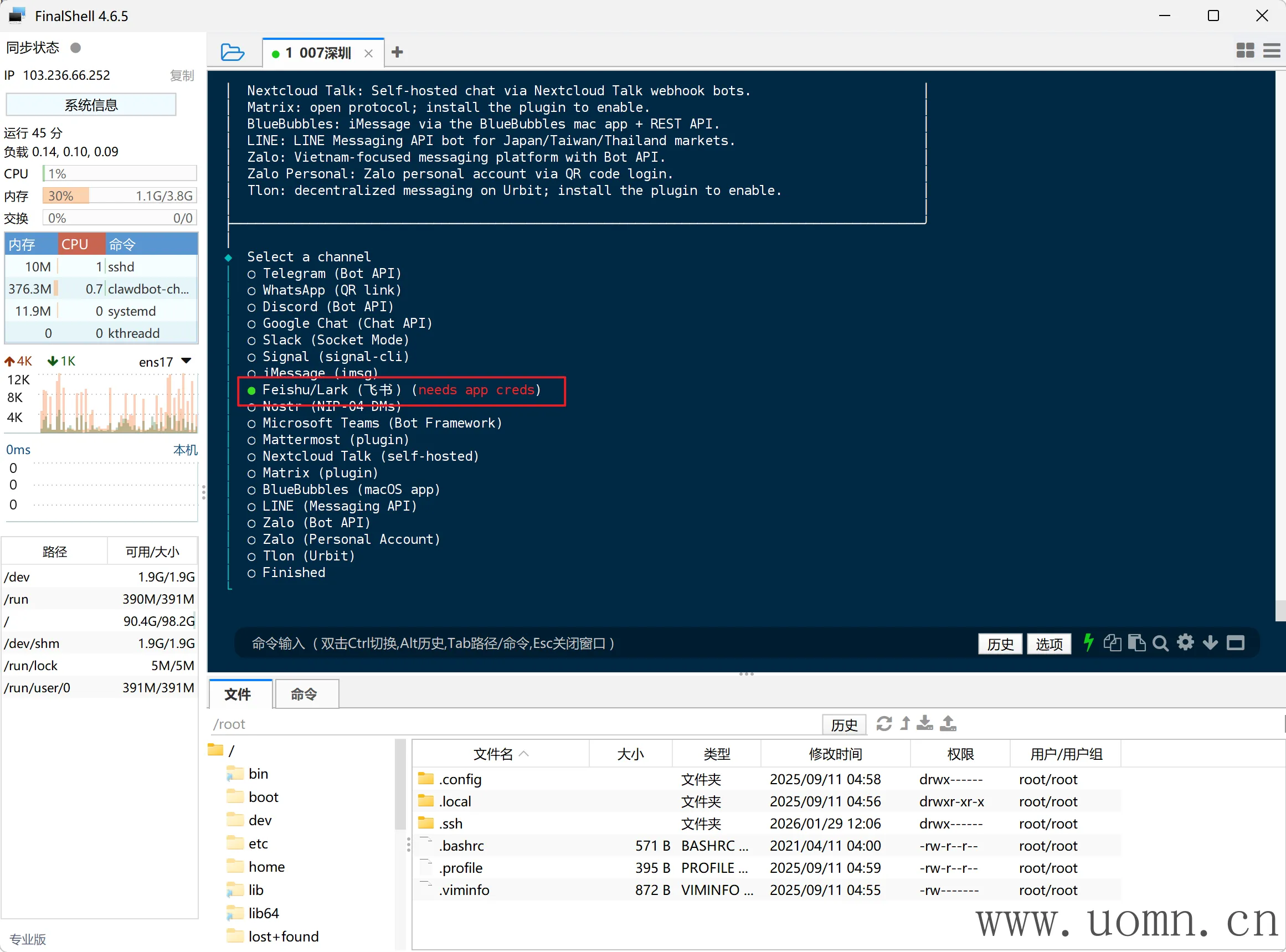

Tip:也可以直接修改配置文件,这里我是用的交互,后边几个渠道都是直接修改配置文件的

openclaw channels add

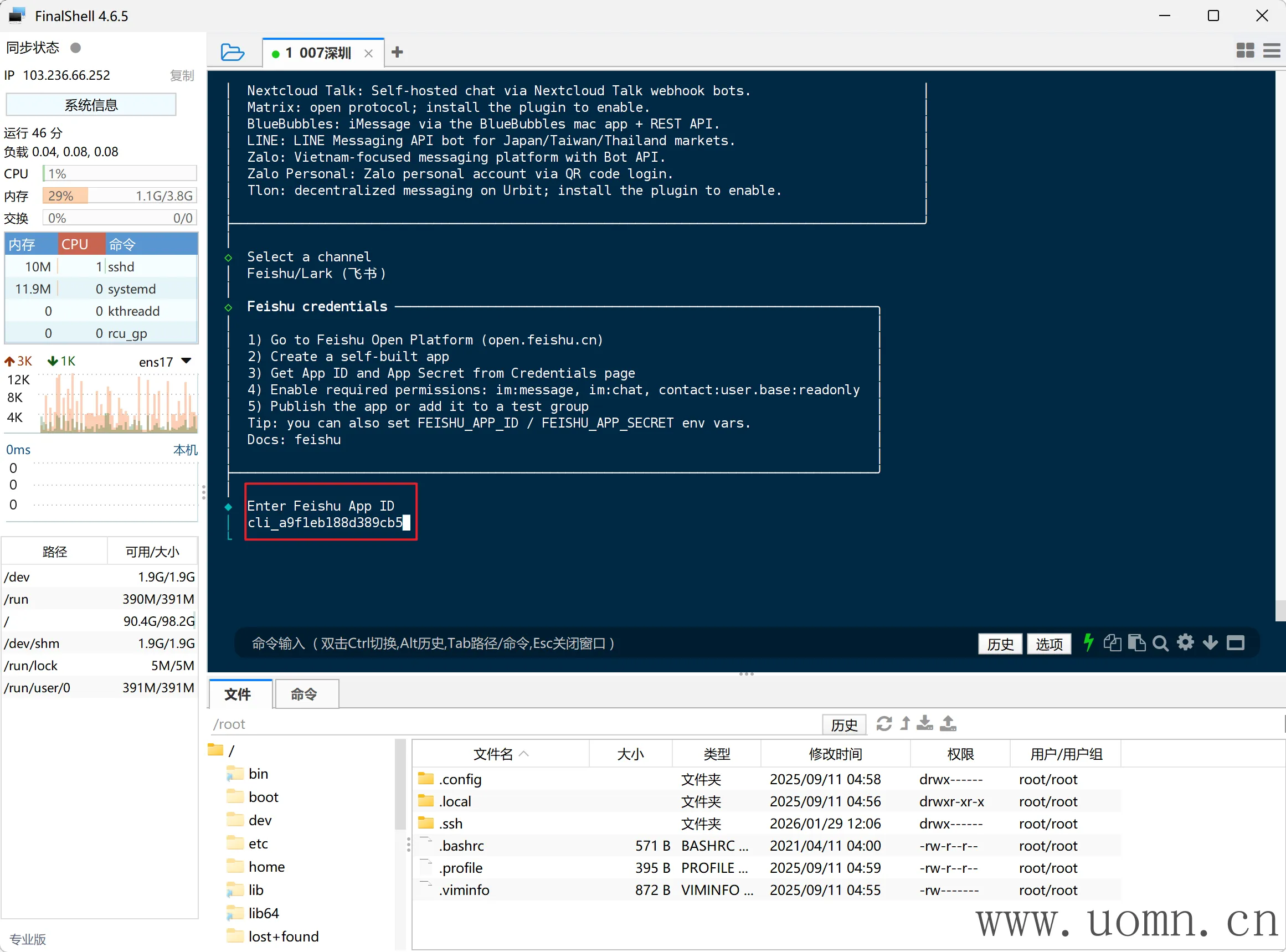

返回飞书的开放平台,能够看到ID、密钥

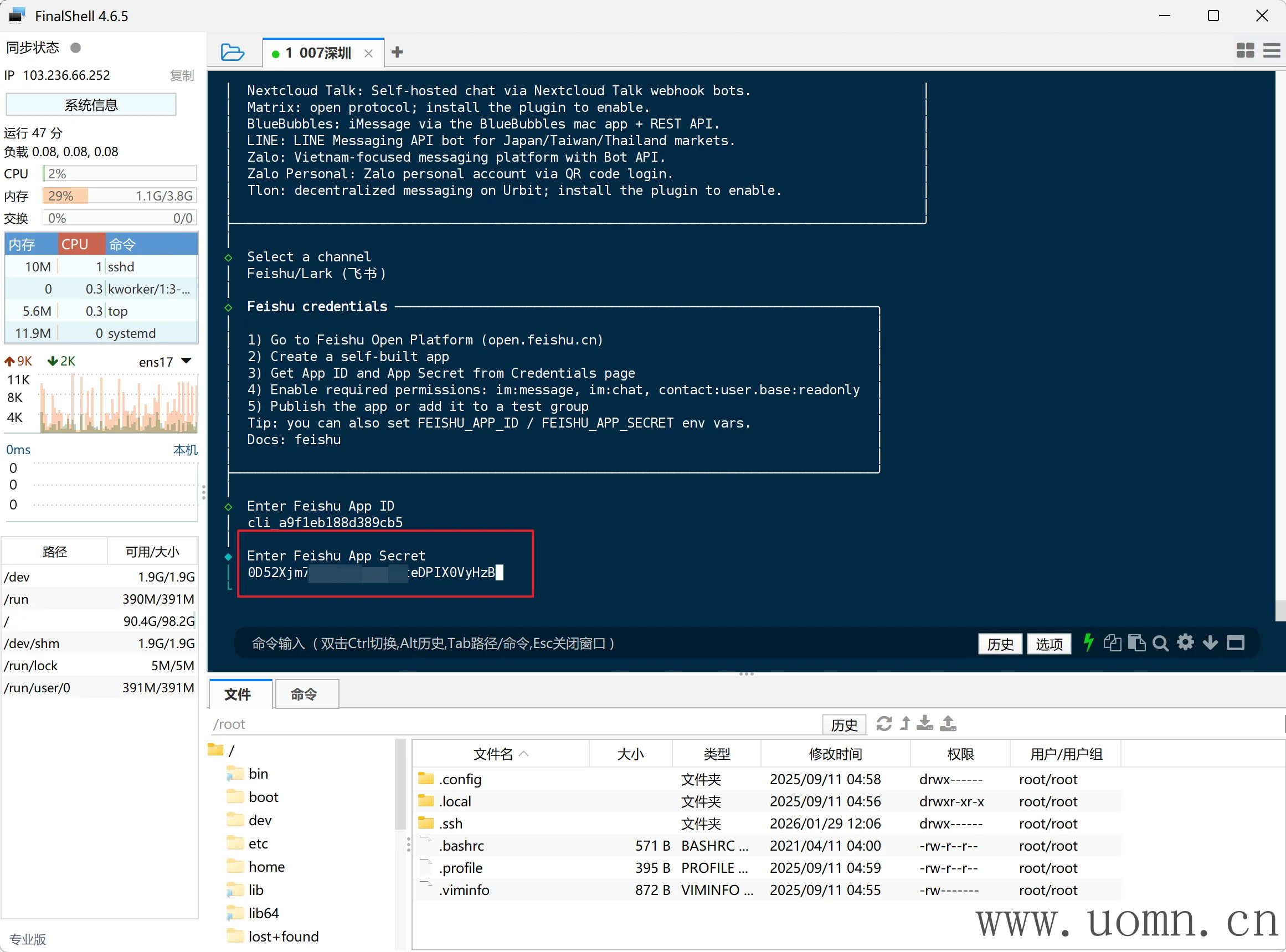

然后回到终端,输入ID

确认后,再输入密钥

然后让你选择飞书的域名,国内则选第一个,国外选第二个。一般都是选第一个

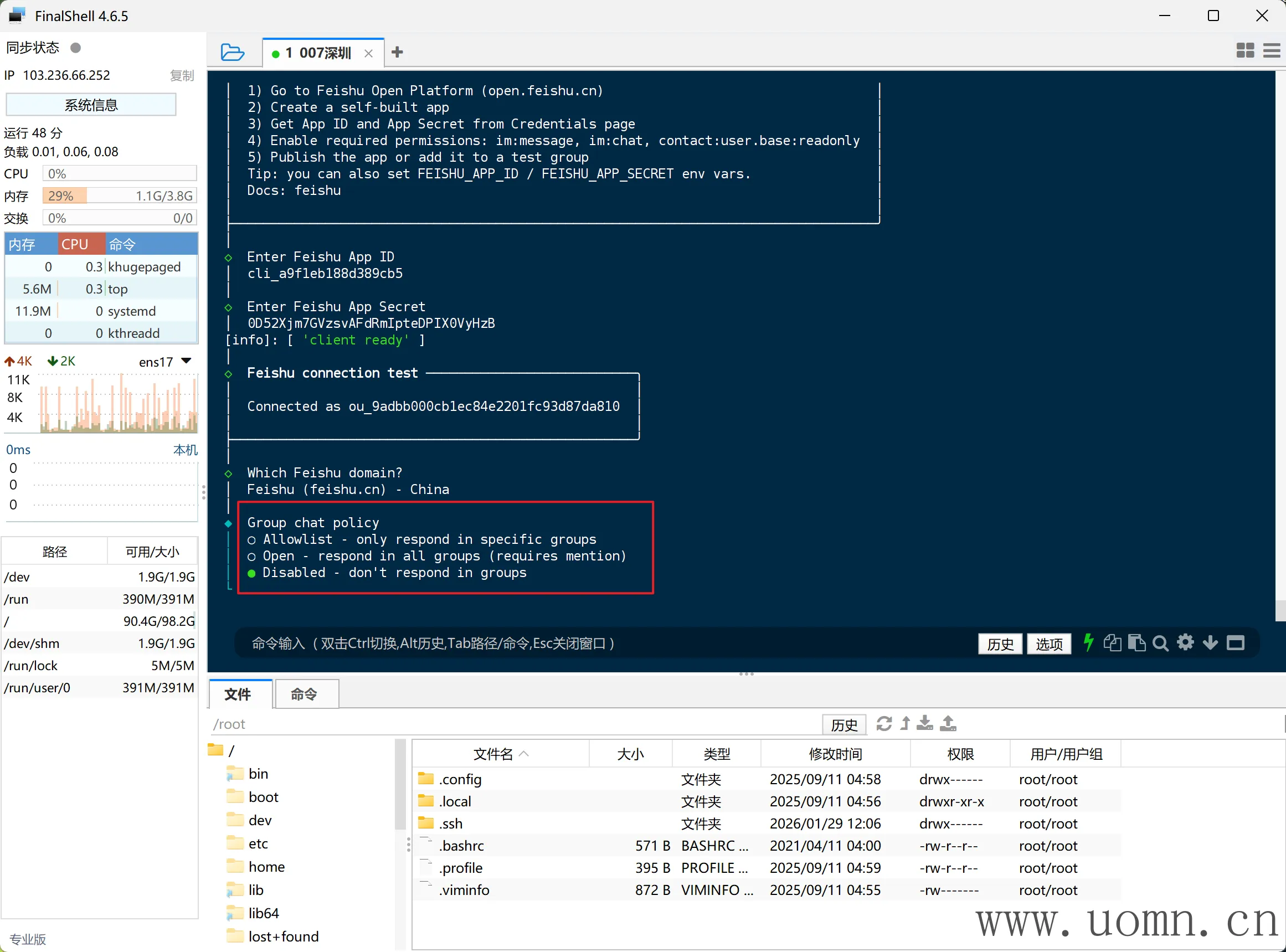

下一项是群聊策略,这里建议不开启,万一谁在群聊里用你机器人执行 rm -rf /* 你不炸了

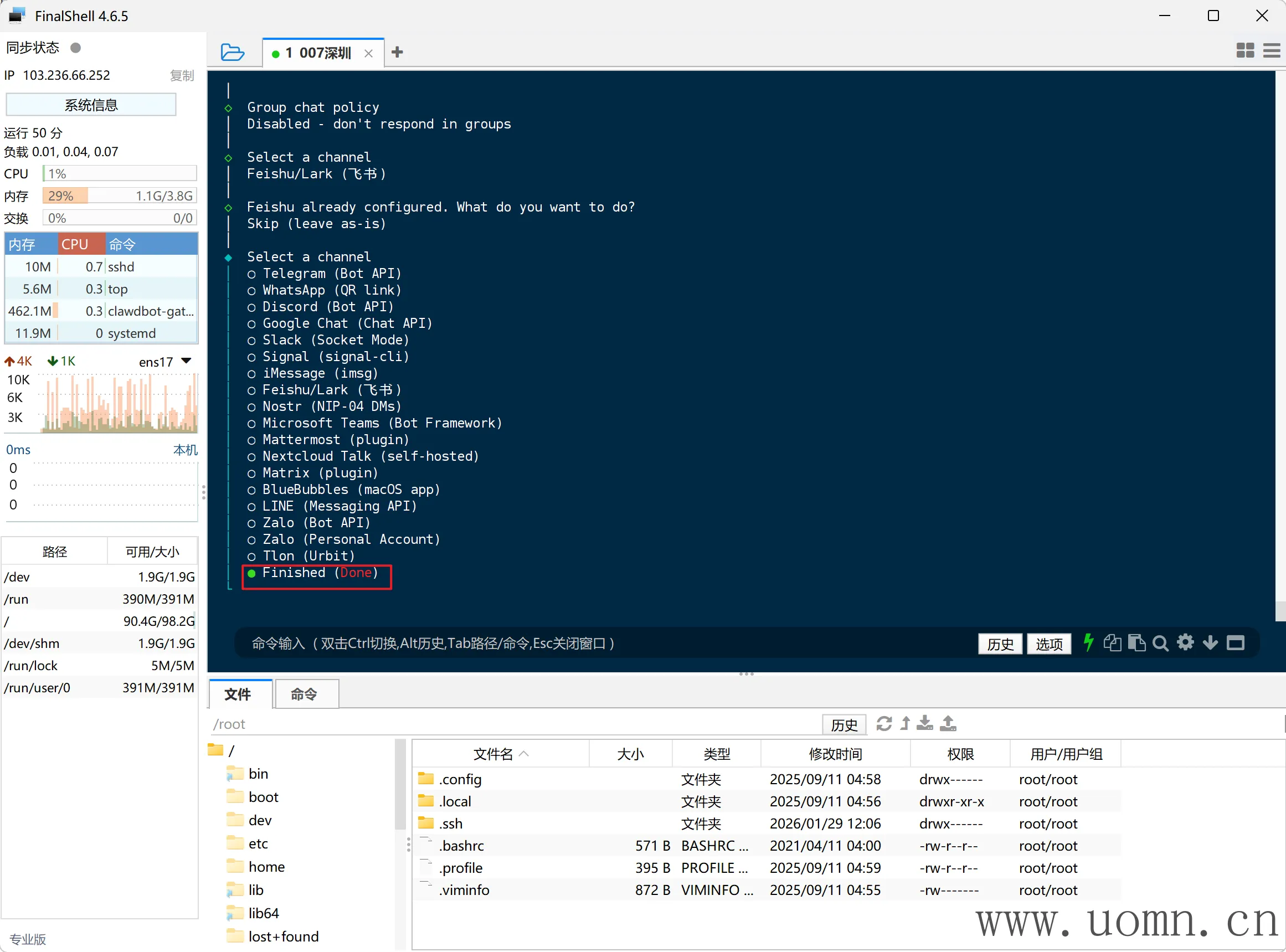

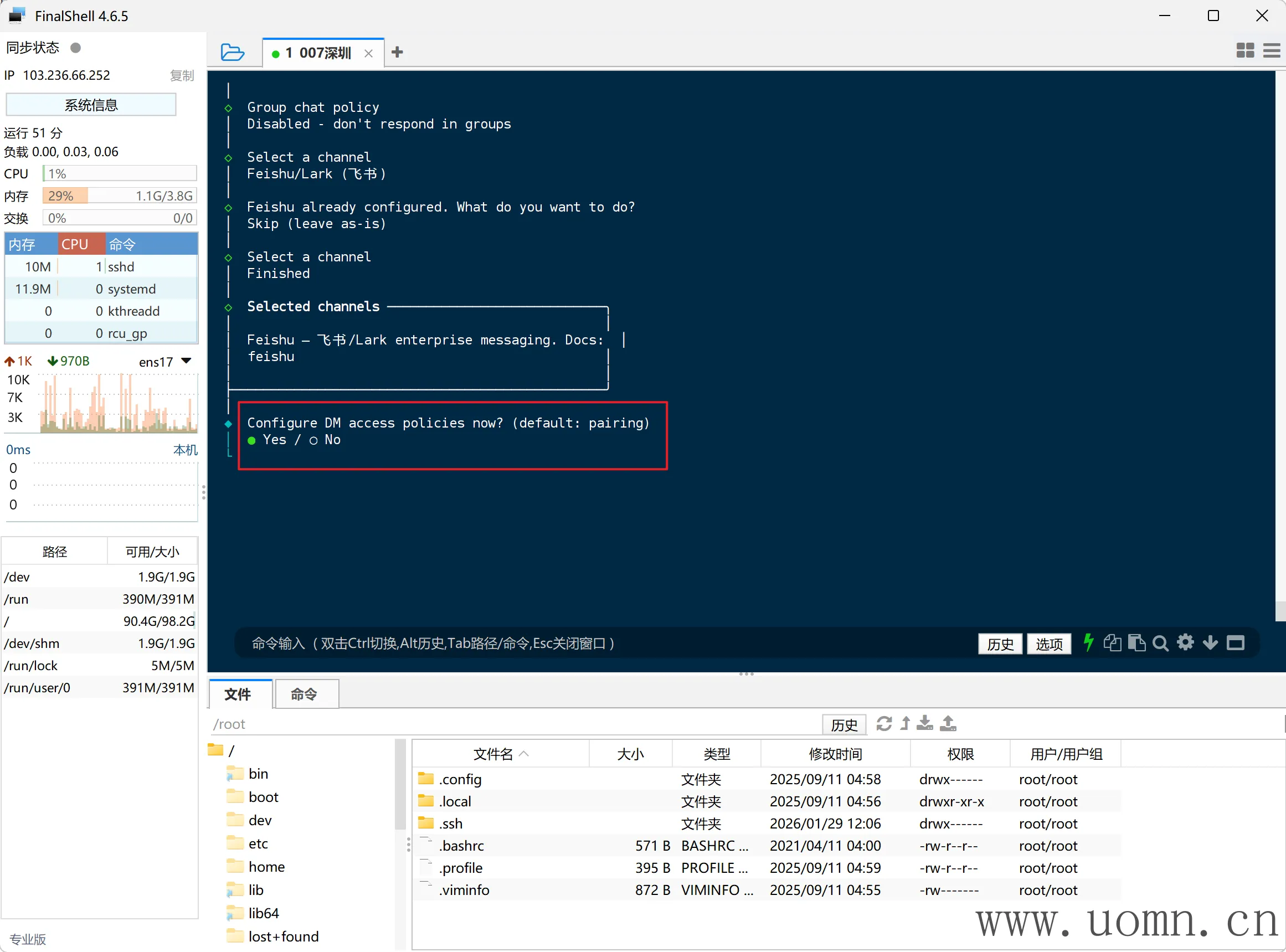

然后飞书配置完后,会回到渠道列表,选择最后一个完成

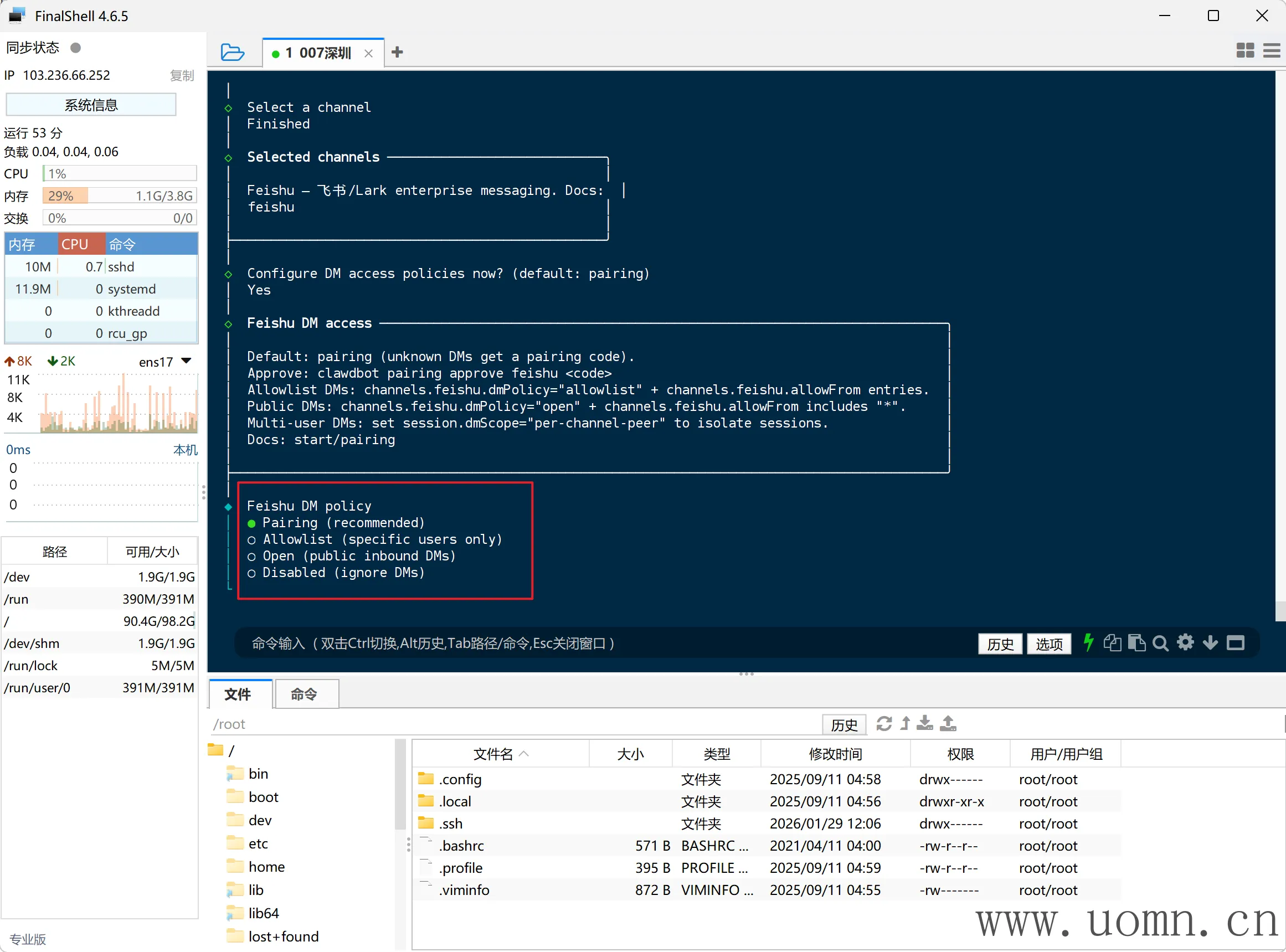

下一步会进入私聊策略的配置中,选择是

官方推荐是选择第一种,所以这里就选第一个:配对模式

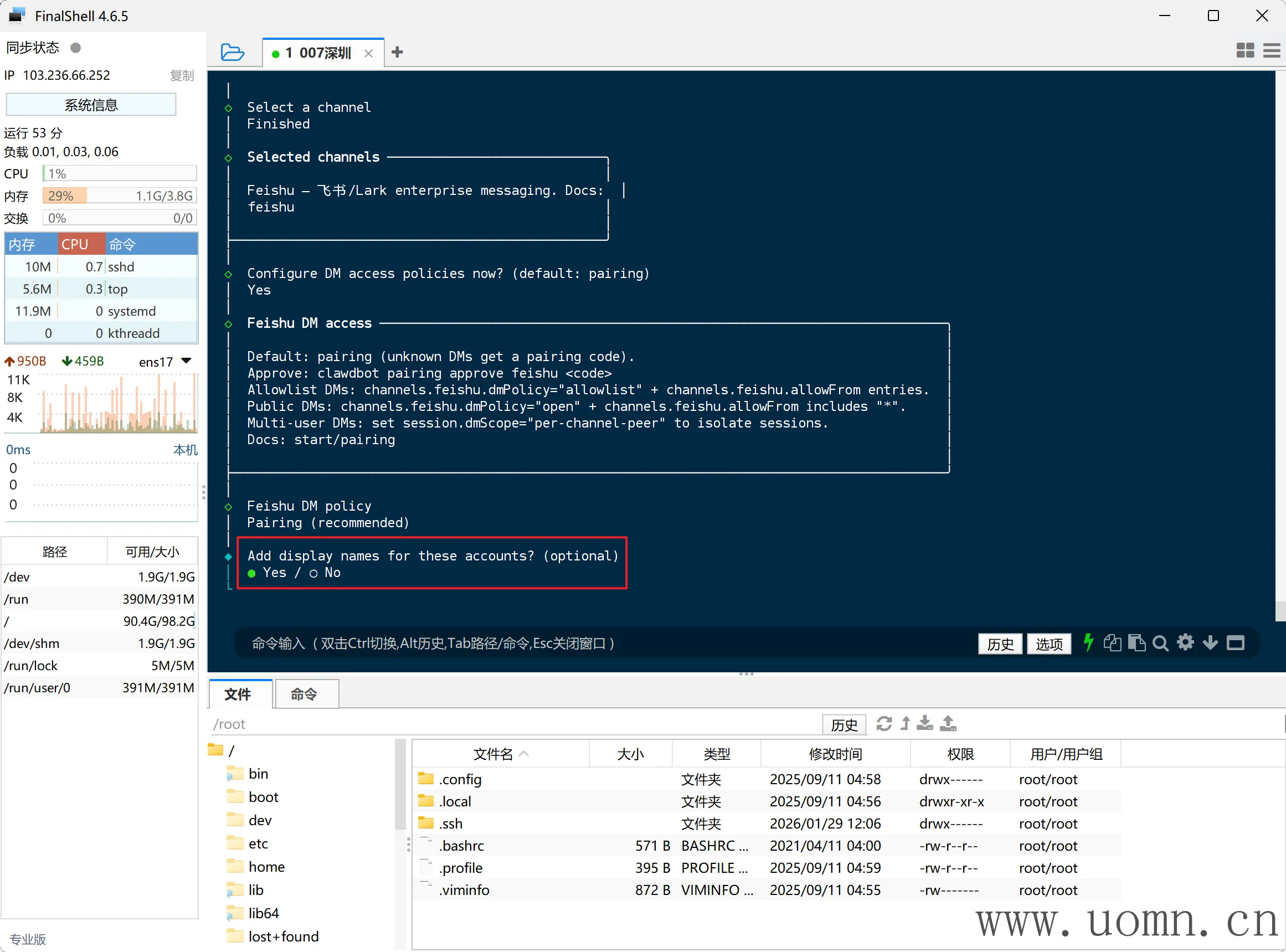

下一项是:是否为这些账号添加显示名称?选是

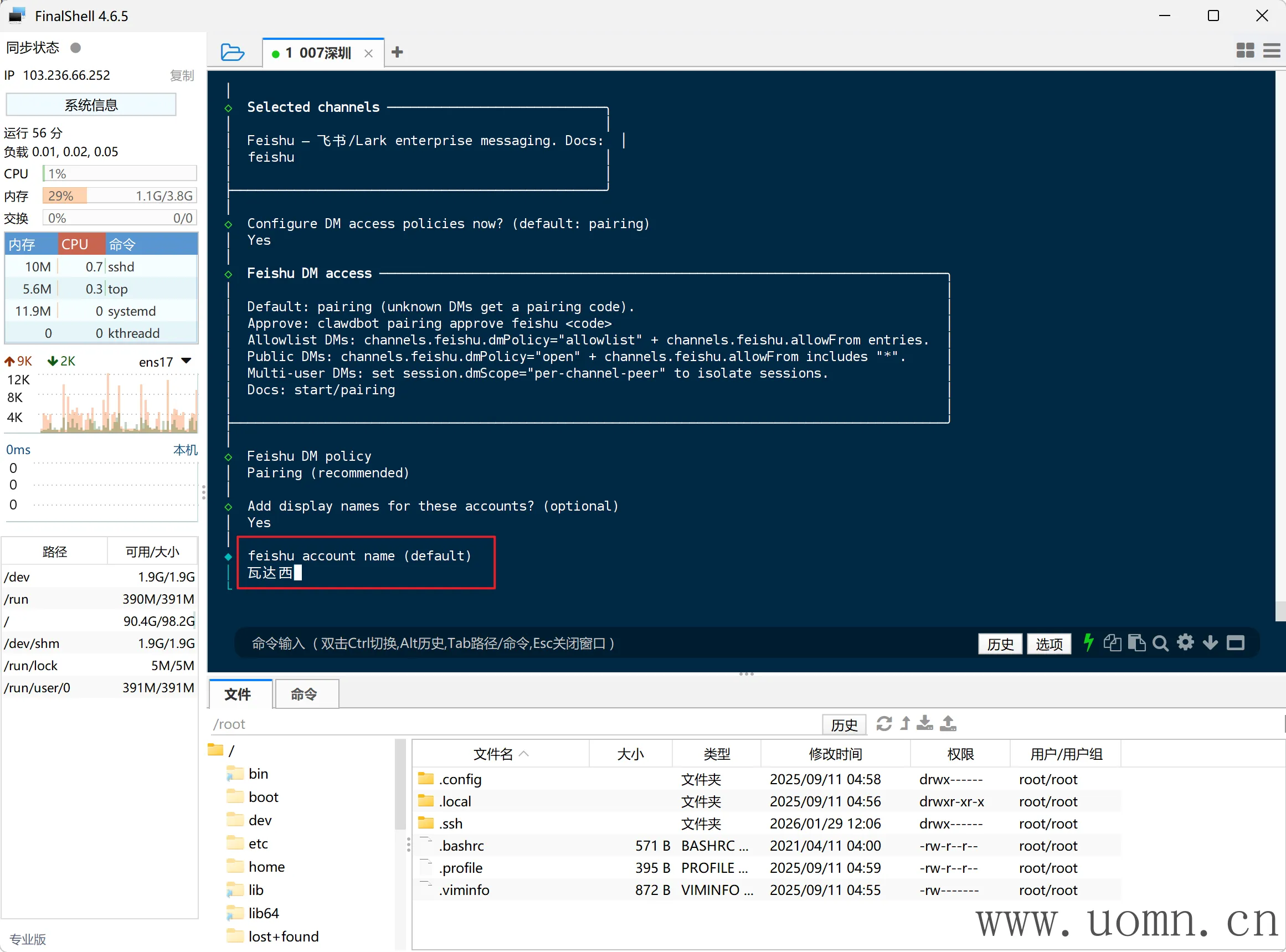

输入飞书名?

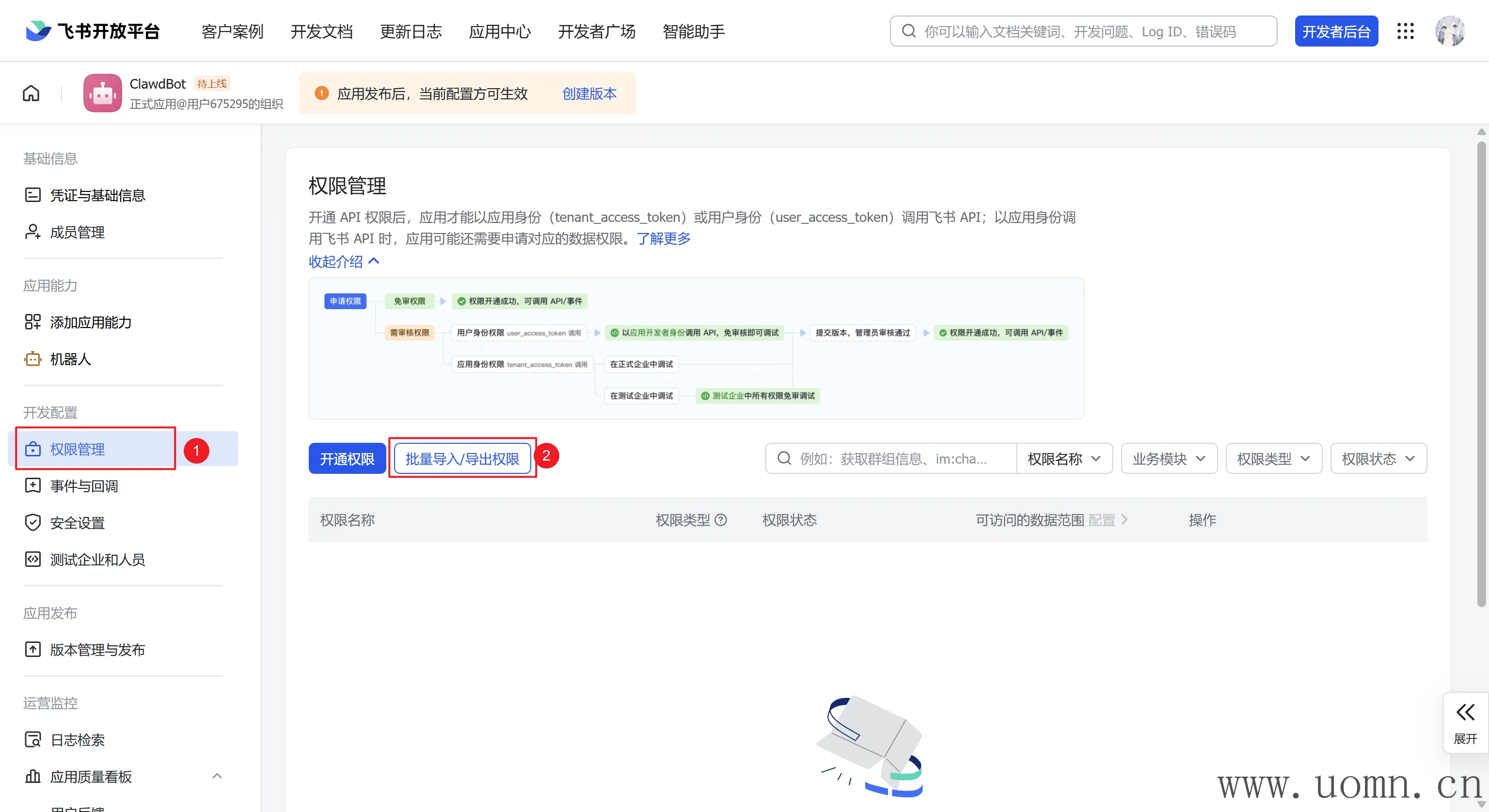

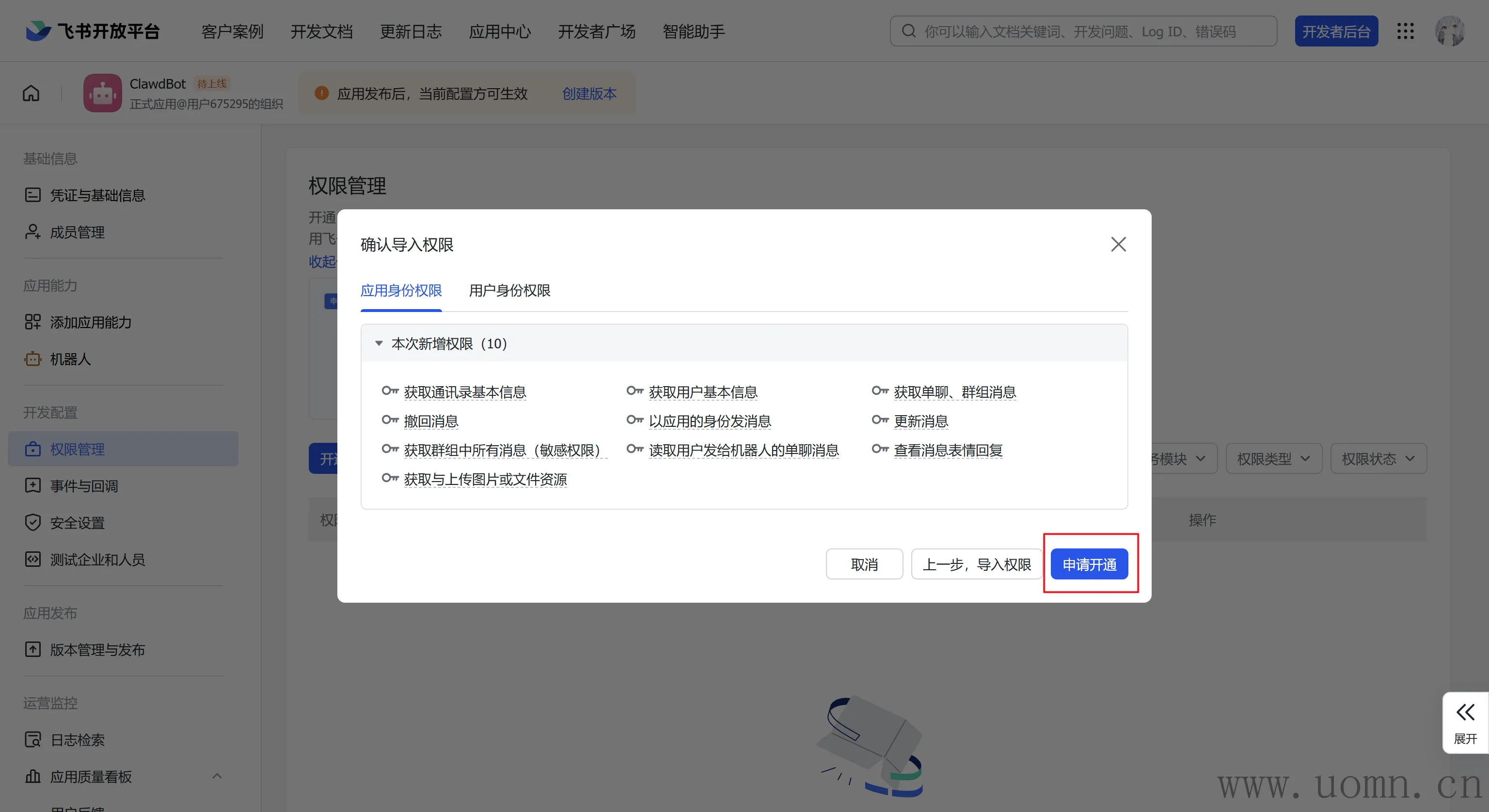

配置机器人权限

然后返回飞书的开放平台,开通一下子权限

{

"scopes": {

"tenant": [

"im:message.group_msg",

"im:message.p2p_msg:readonly",

"im:message.reactions:read",

"im:message:readonly",

"im:message:recall",

"im:message:send_as_bot",

"im:message:update",

"im:resource",

"contact:user.base:readonly",

"contact:contact.base:readonly"

],

"user": [

"docx:document:readonly"

]

}

}

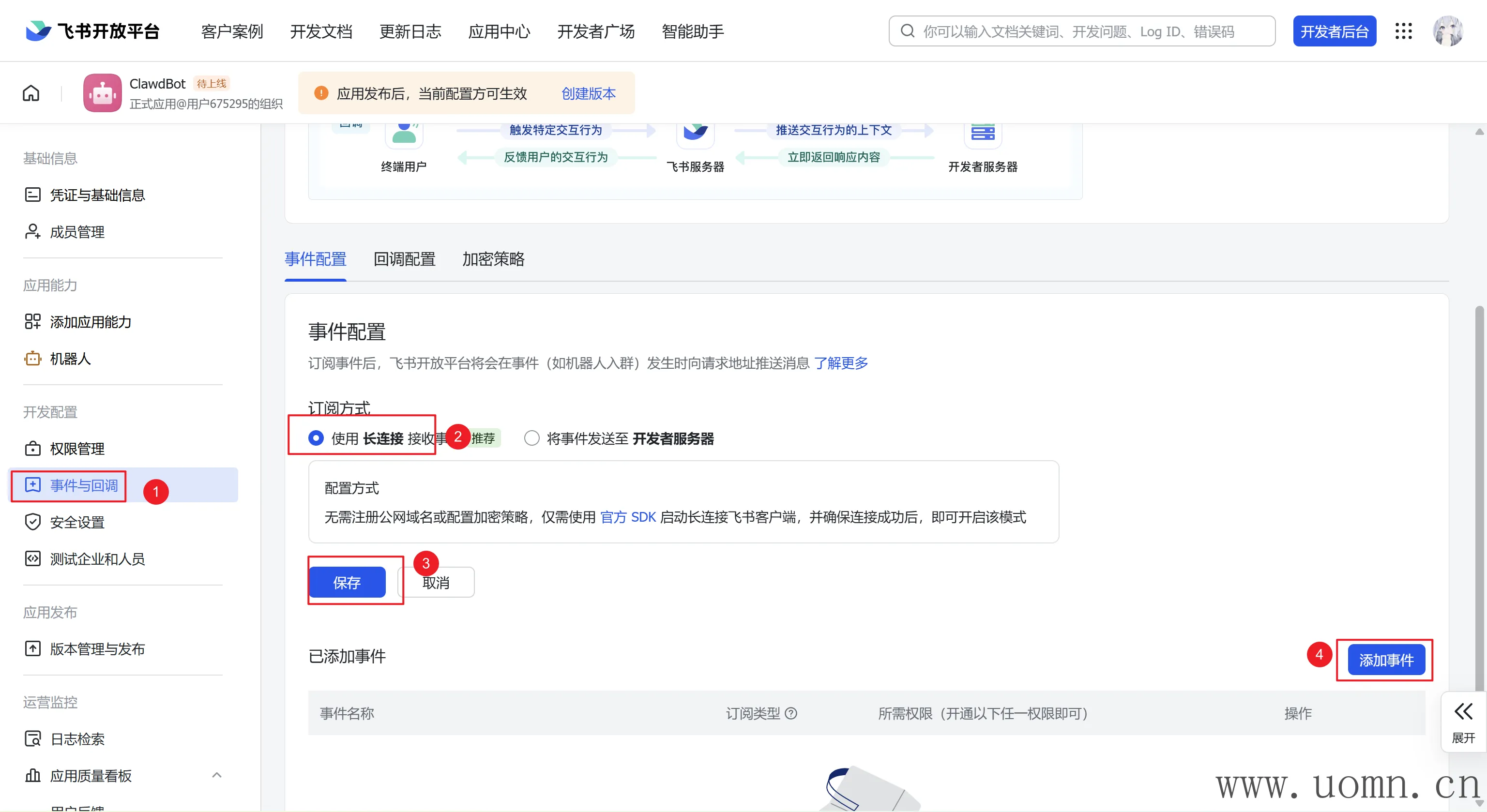

添加飞书消息事件

这里的订阅方式使用长连接

点击添加事件,找到接受消息的时间,选中后确认添加

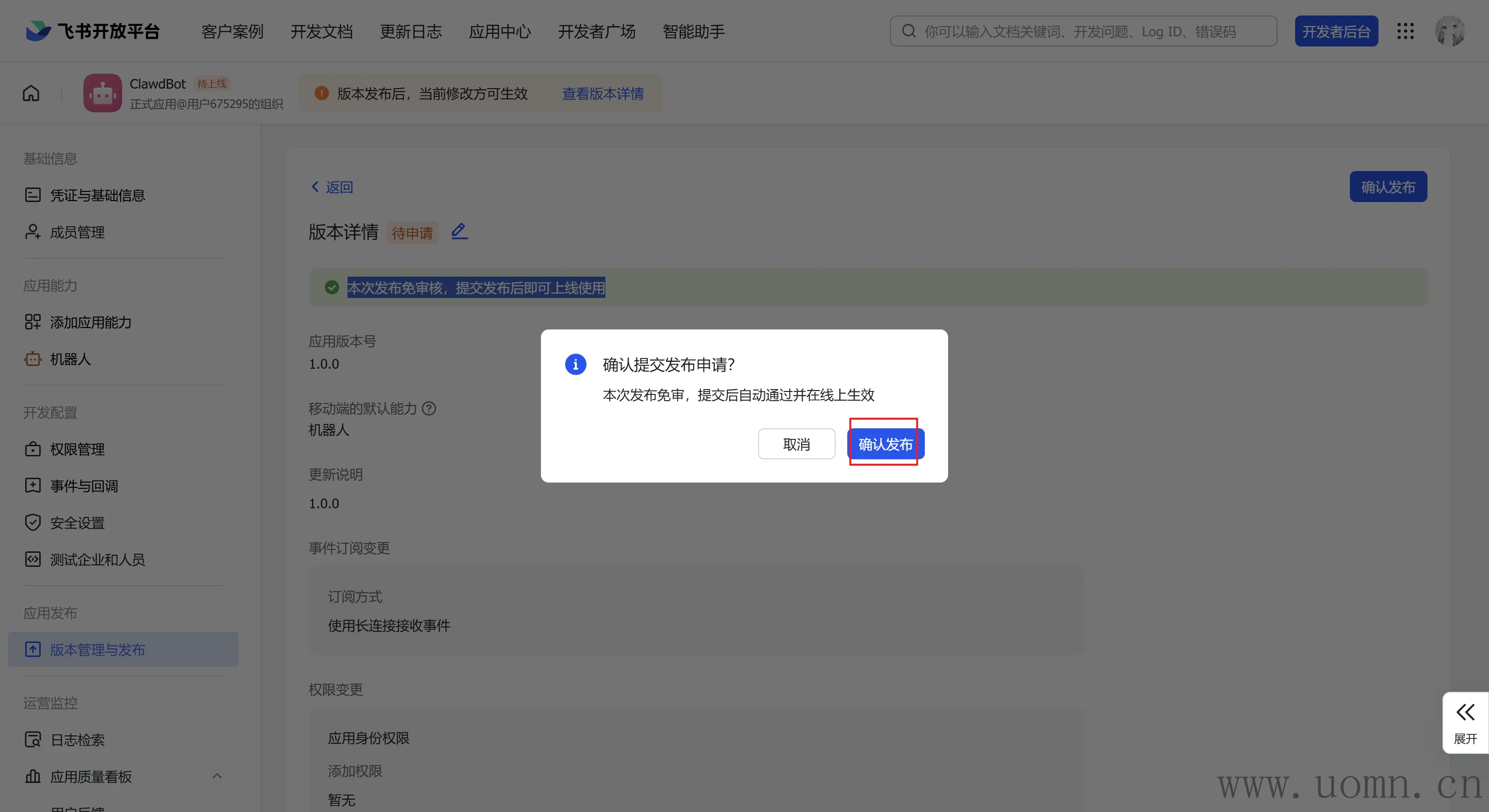

发布飞书机器人

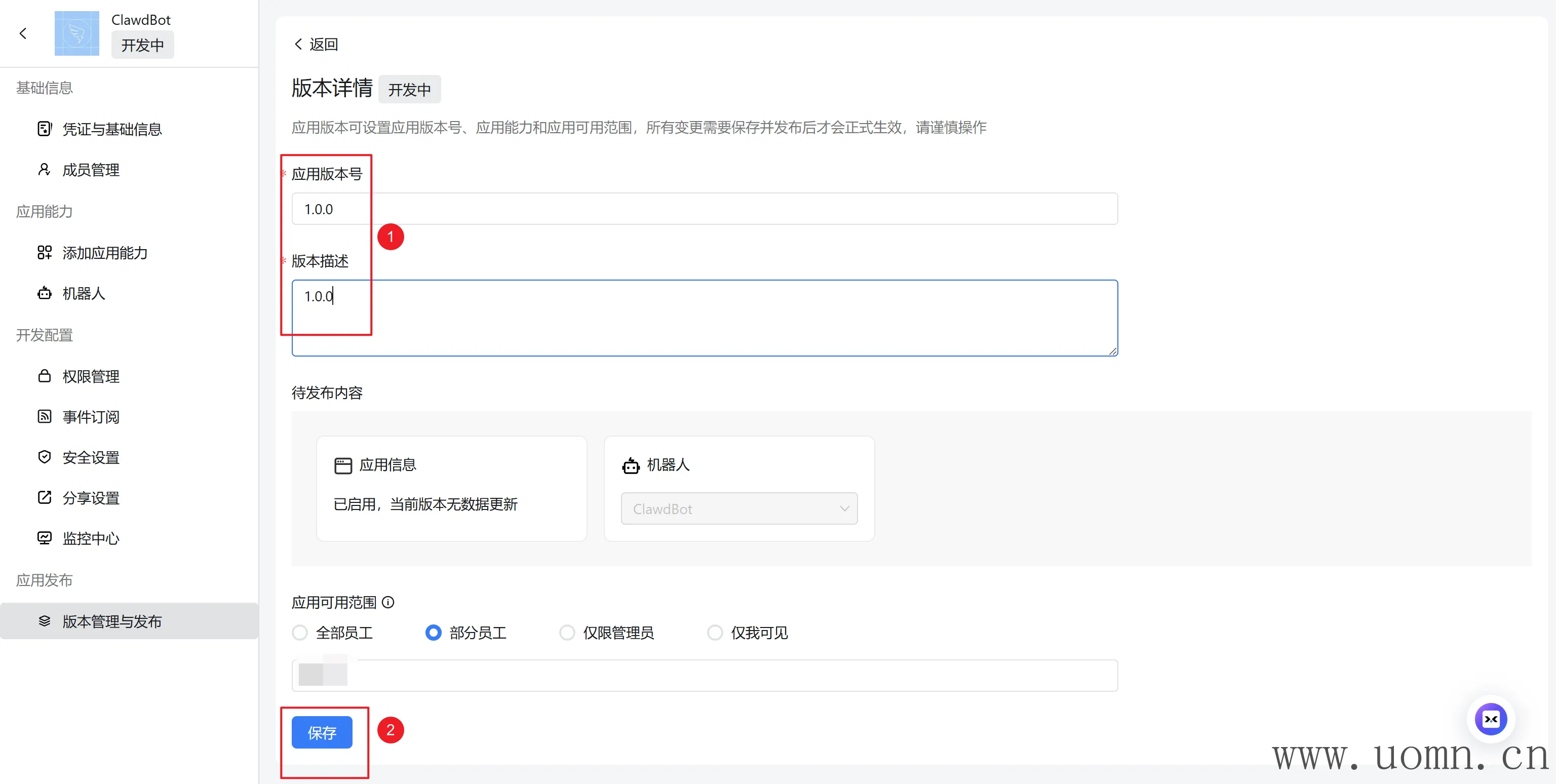

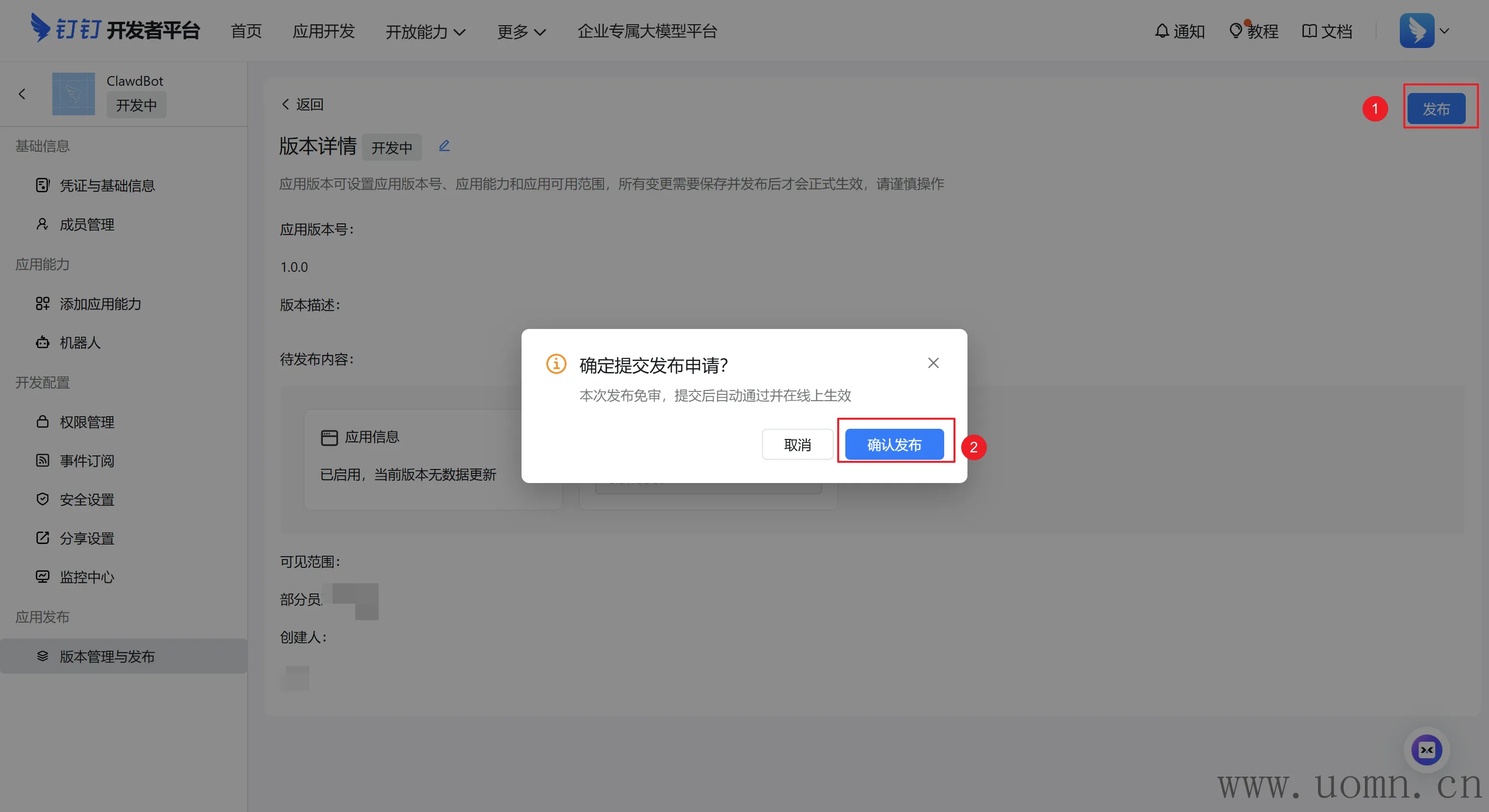

创建版本后发布机器人

若上方显示:本次发布免审核,提交发布后即可上线使用,则在发布后直接就能用,否则需要找企业中具有审核权限的人审核你发布的应用后才能用

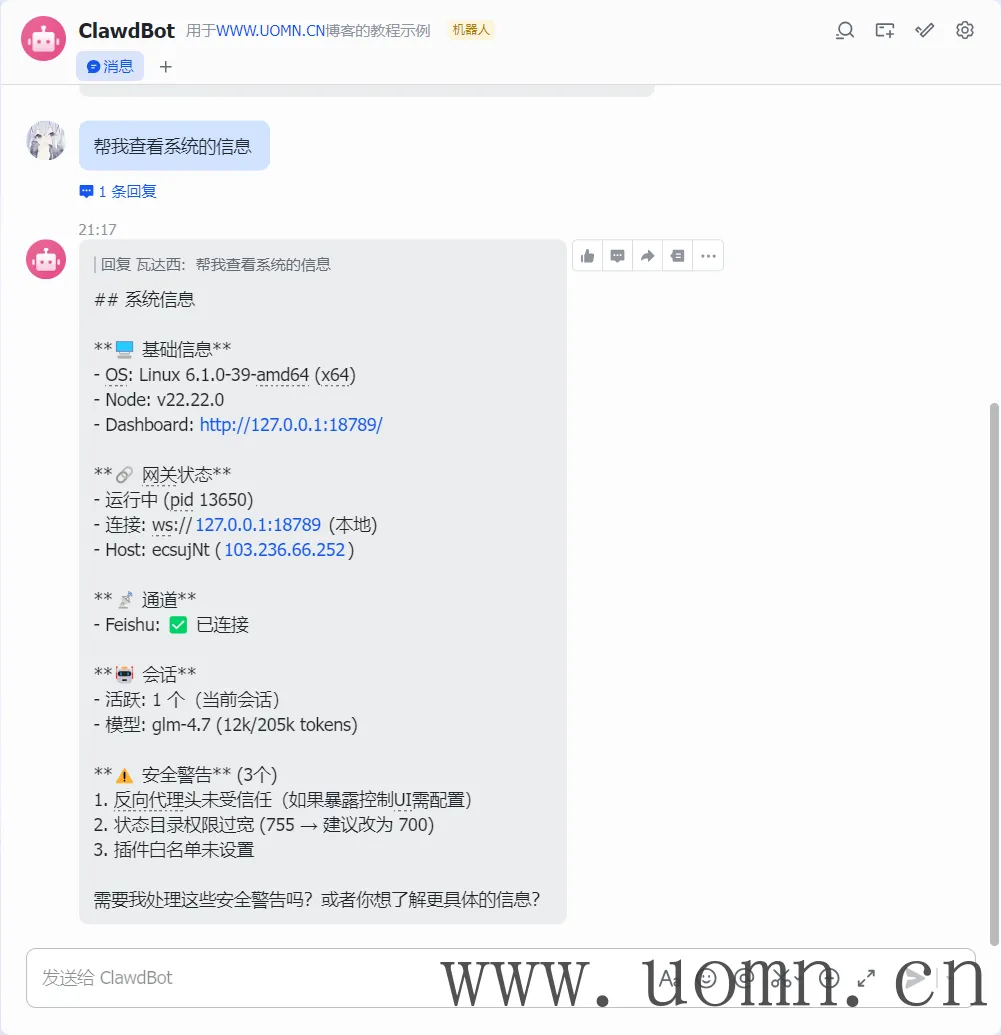

测试

在飞书的工作台中能找到你刚发布的机器人,双击进去就能用啦

接入钉钉

官方库:https://github.com/DingTalk-Real-AI/dingtalk-moltbot-connector

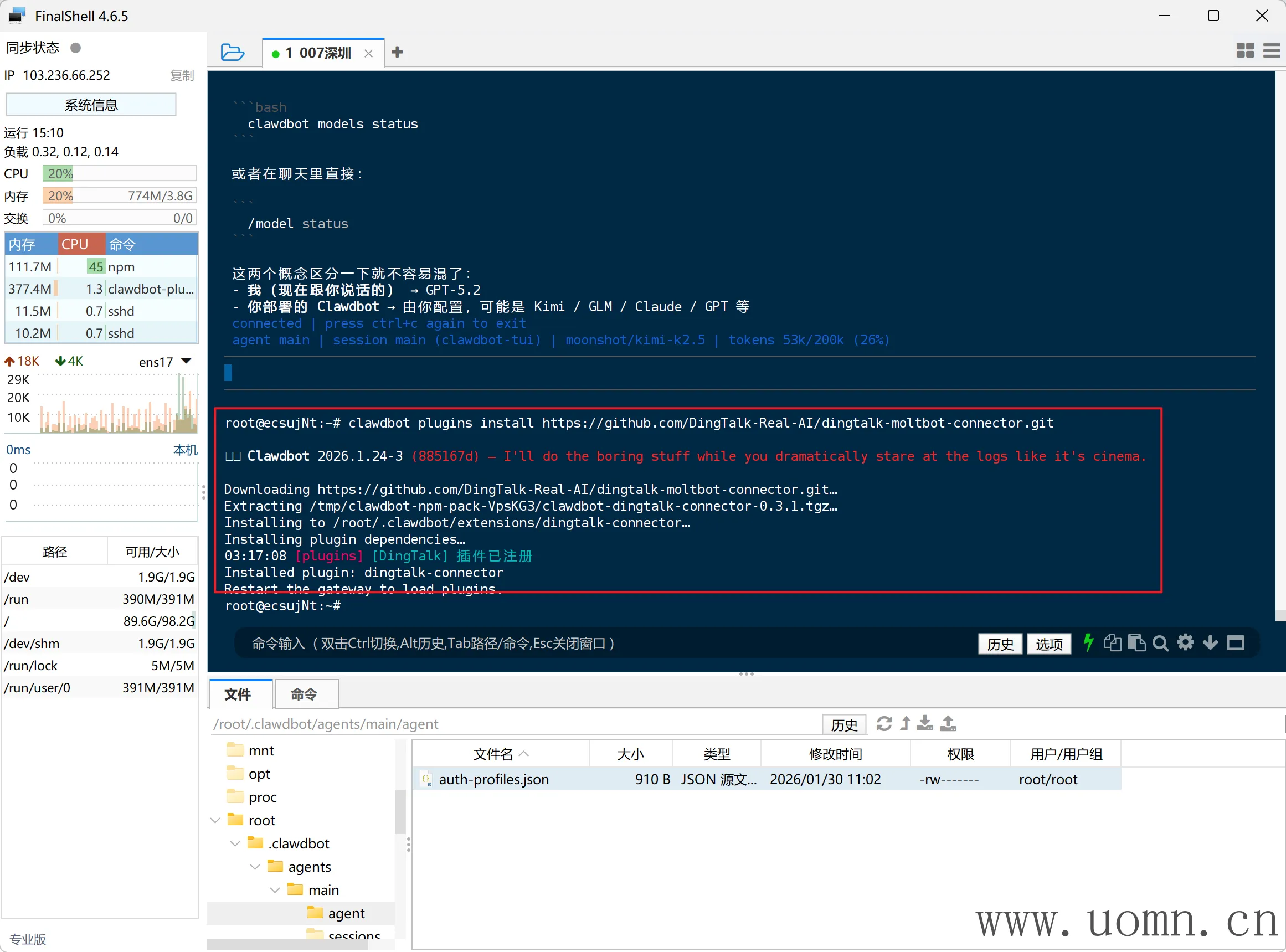

安装钉钉渠道

在终端中执行下方命令安装钉钉渠道

openclaw plugins install https://github.com/DingTalk-Real-AI/dingtalk-moltbot-connector.git

创建钉钉机器人

钉钉开放平台:https://open.dingtalk.com/

填好应用名称和描述后保存

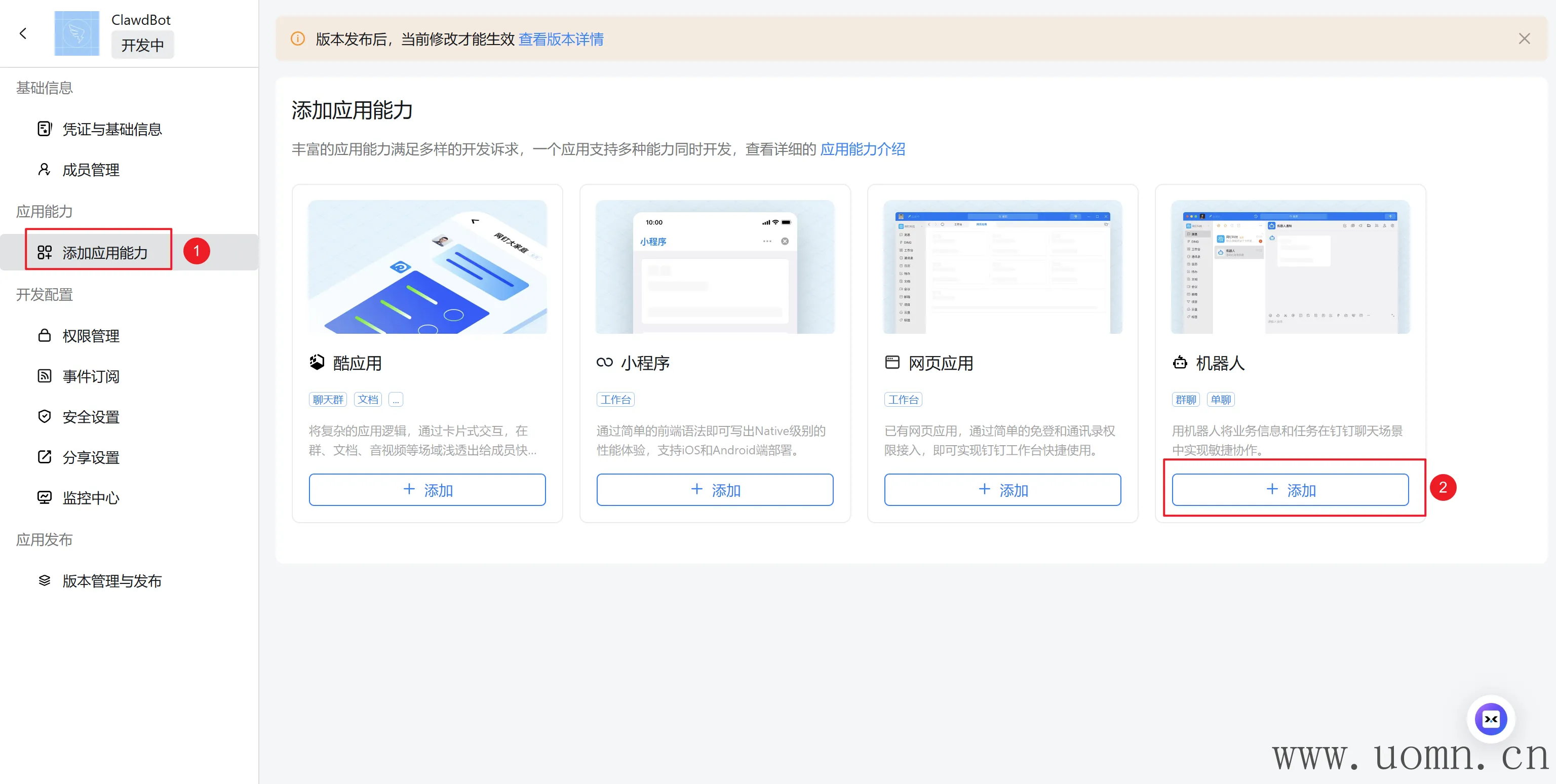

添加机器人的应用能力

启用机器人配置,必填项都填上,其余的默认即可

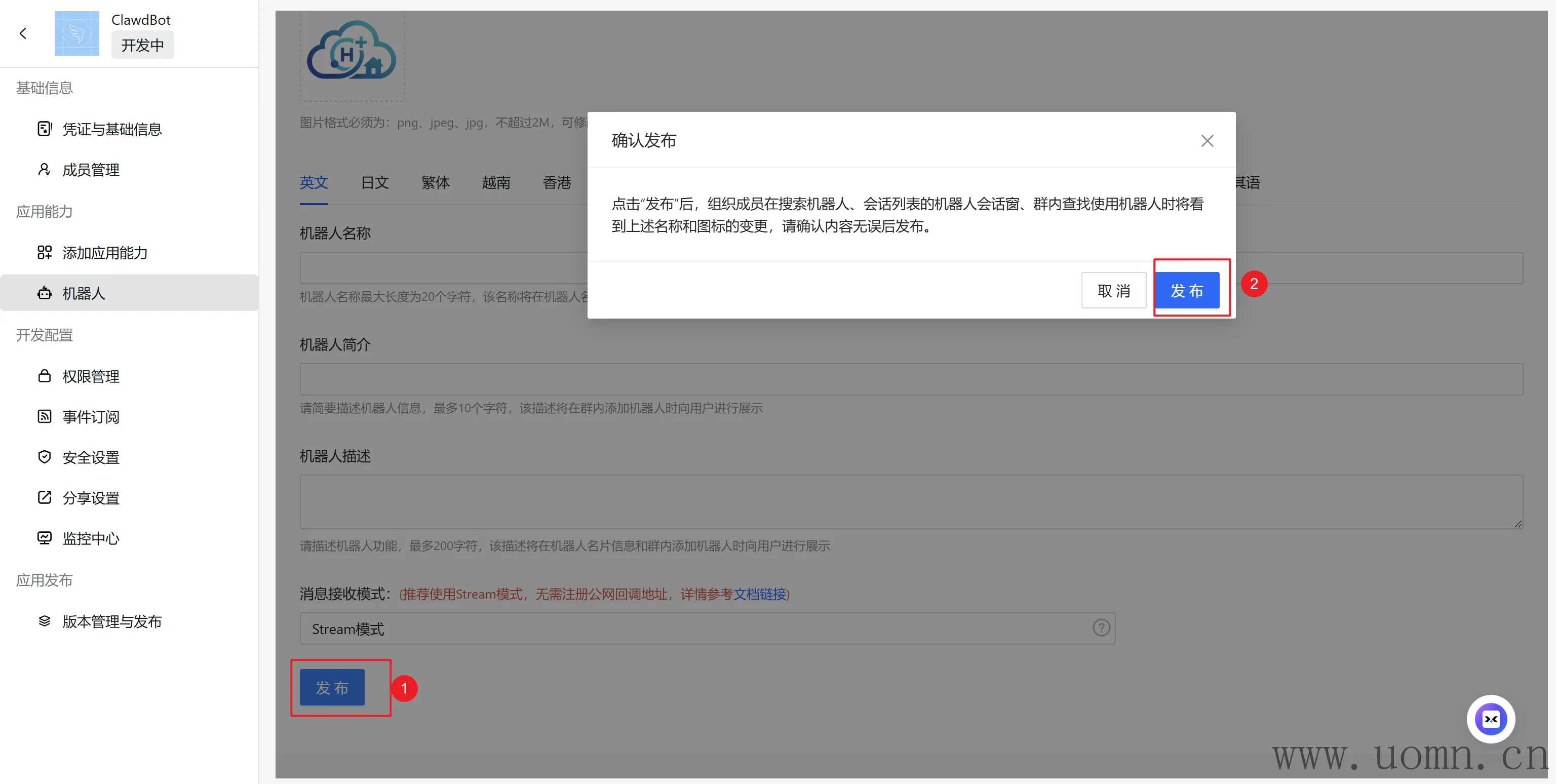

下滑到底,点发布保存配置

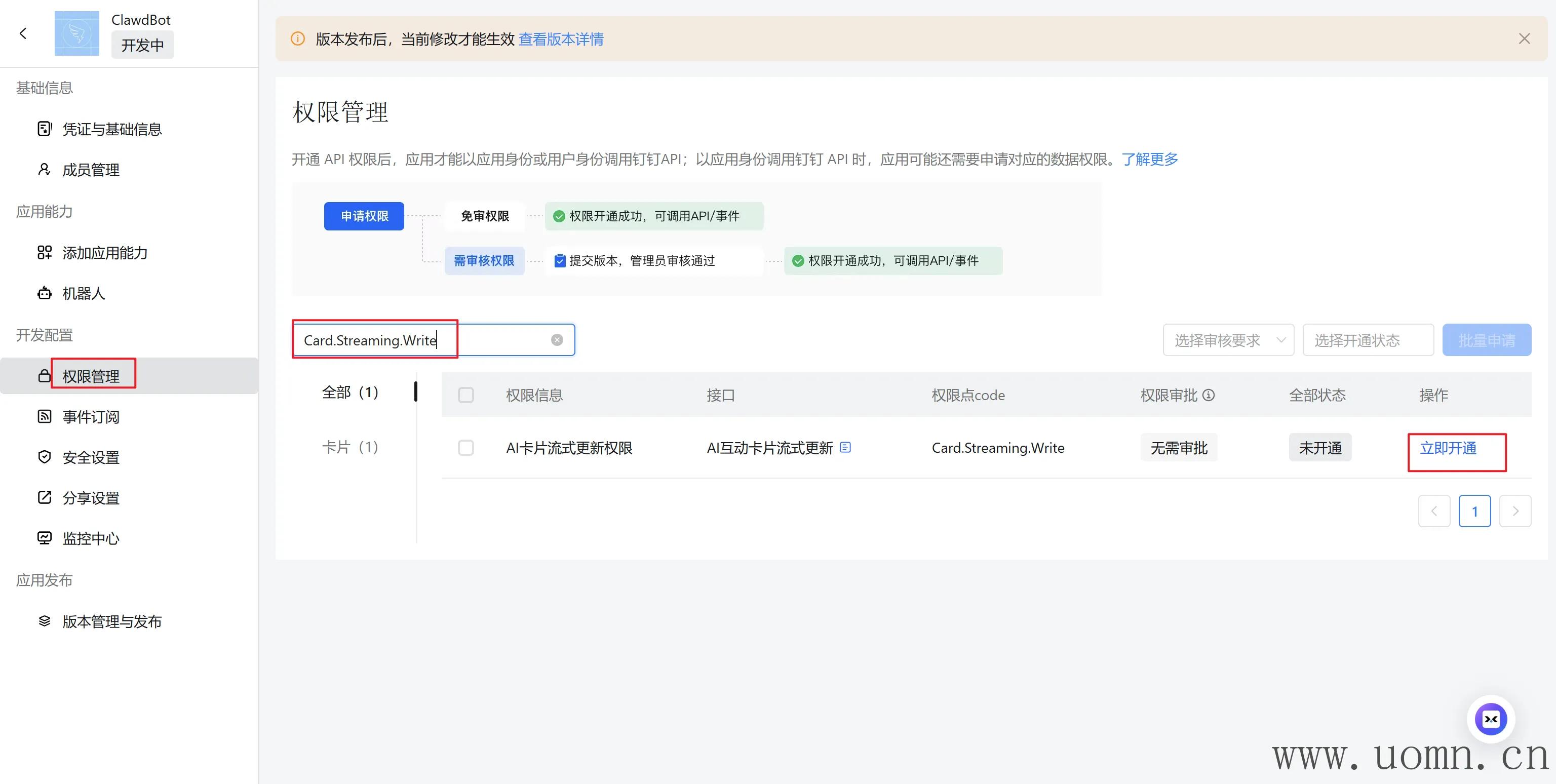

然后需要开通几个权限,一行一个,一个一个搜,然后开通

Card.Streaming.Write

Card.Instance.Write

qyapi_robot_sendmsg

发布机器人

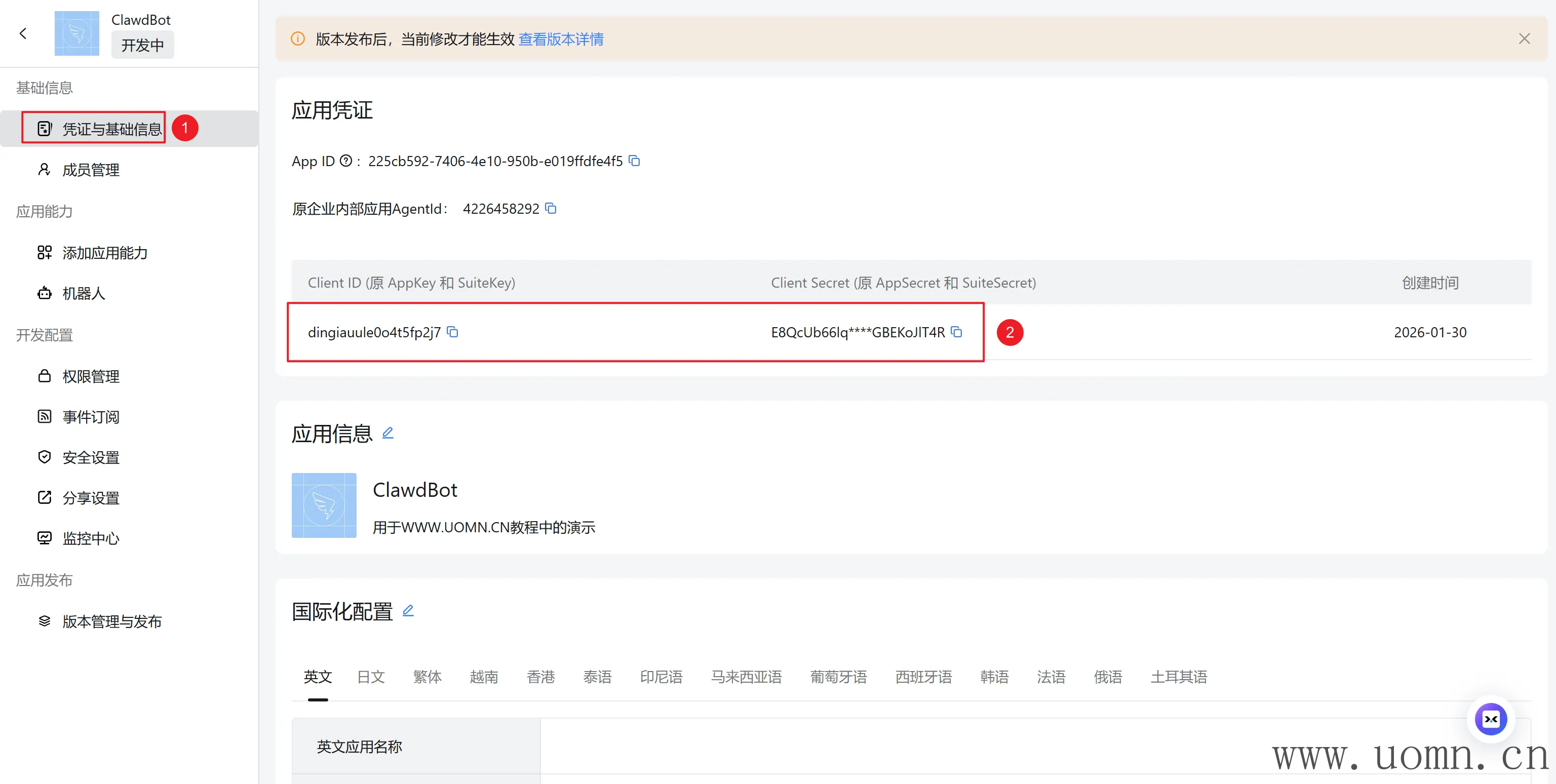

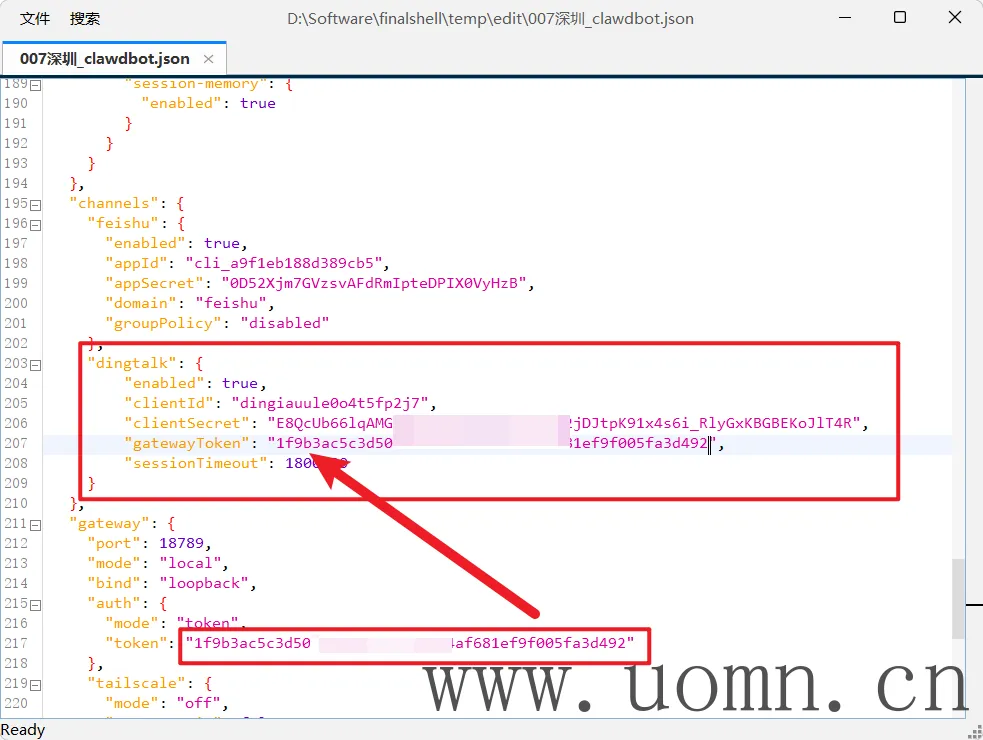

修改配置文件

修改openclaw.json 文件,新增钉钉配置

{

"dingtalk": {

"enabled": true,

"clientId": "你的钉钉AppKey",

"clientSecret": "你的钉钉AppSecret",

"gatewayToken": "你配置文件中的Token",

"sessionTimeout": 1800000

}

}下图中的两个信息替换上边配置文件中的值

启用 HTTP Chat Completions 端点

{

"http": {

"endpoints": {

"chatCompletions": {

"enabled": true

}

}

}

}

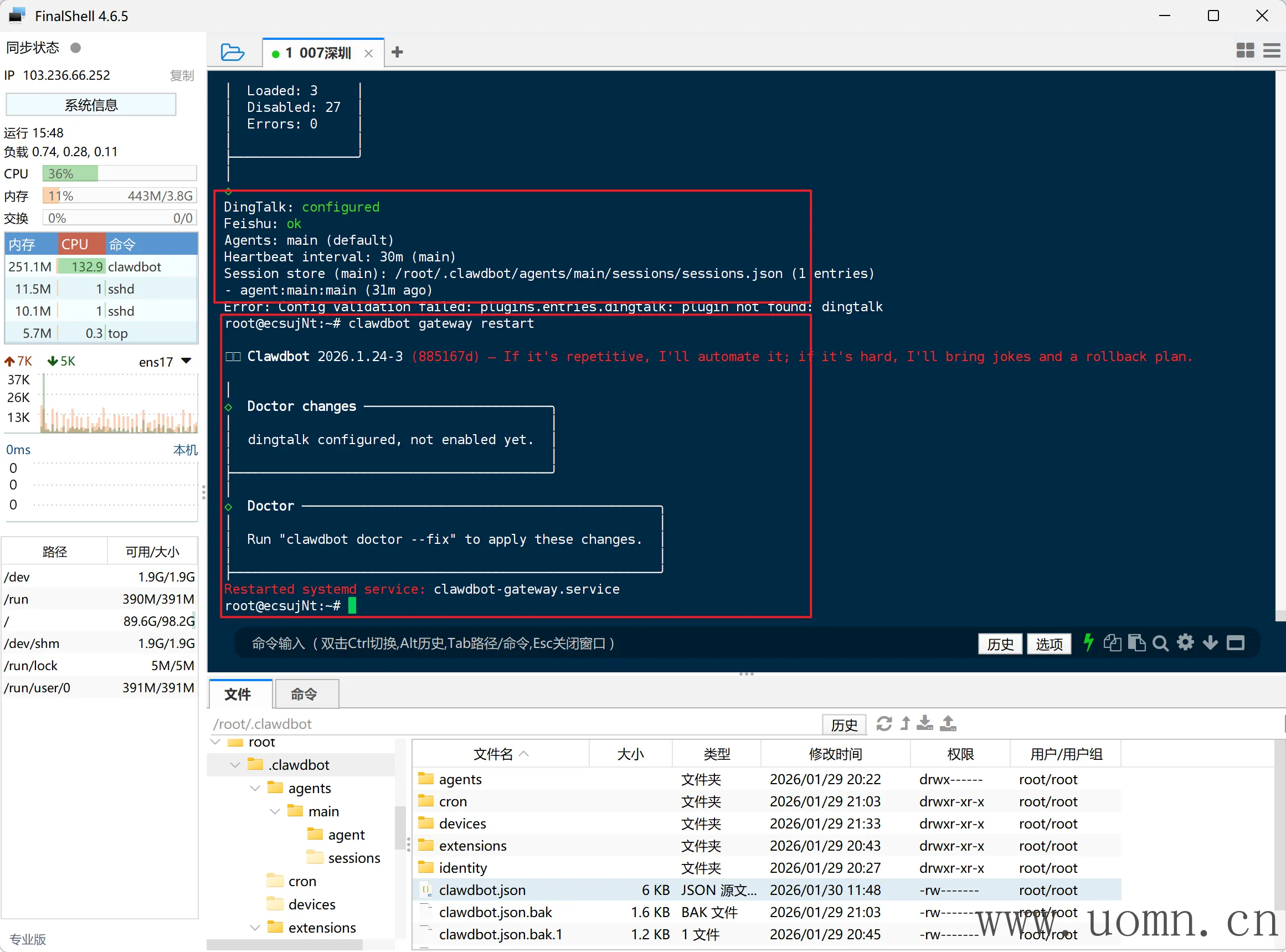

重启&测试

终端执行下方命令,第一个是检查,没报错就执行第二个重启命令

openclaw doctor

openclaw gateway restart

在钉钉中搜索你刚创建的钉钉应用名称,即可找到机器人

对话测试没问题就完事了

接入企业微信自建应用

事先声明:如果需要接入的企业微信已经完成企业认证,则需要准备一个该企业主体的备案域名。本次教程中所使用的企业微信没有进行认证,所以可以直接使用服务器IP接入

官方库:https://github.com/dingxiang-me/clawdbot-wechat

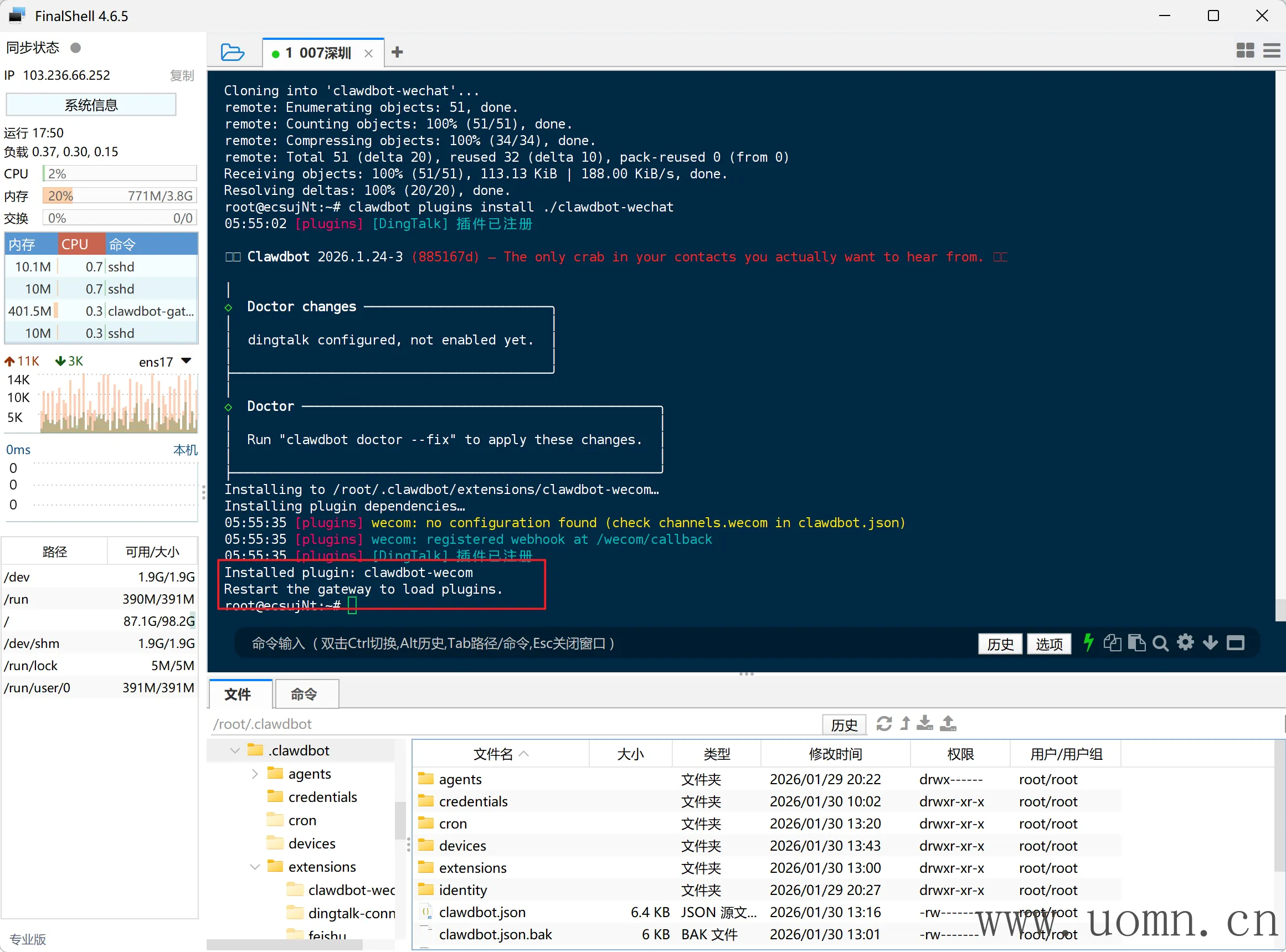

安装企业微信应用渠道

终端执行下方命令

# 国内机用这个

git clone https://ghfast.top/https://github.com/dingxiang-me/openclaw-wechat.git && openclaw plugins install ./openclaw-wechat

# 国外机用这个

git clone https://github.com/dingxiang-me/openclaw-wechat.git && openclaw plugins install ./openclaw-wechat

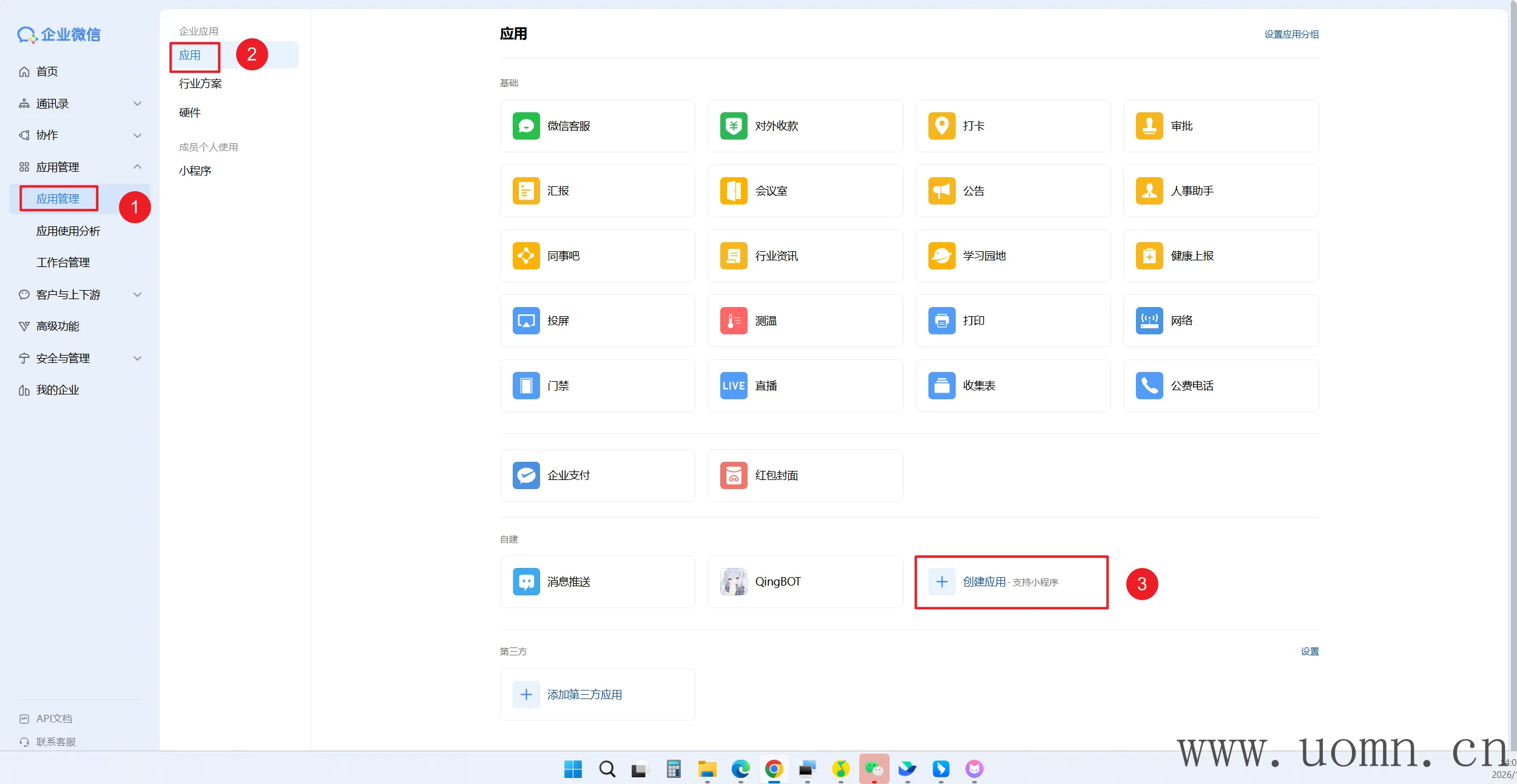

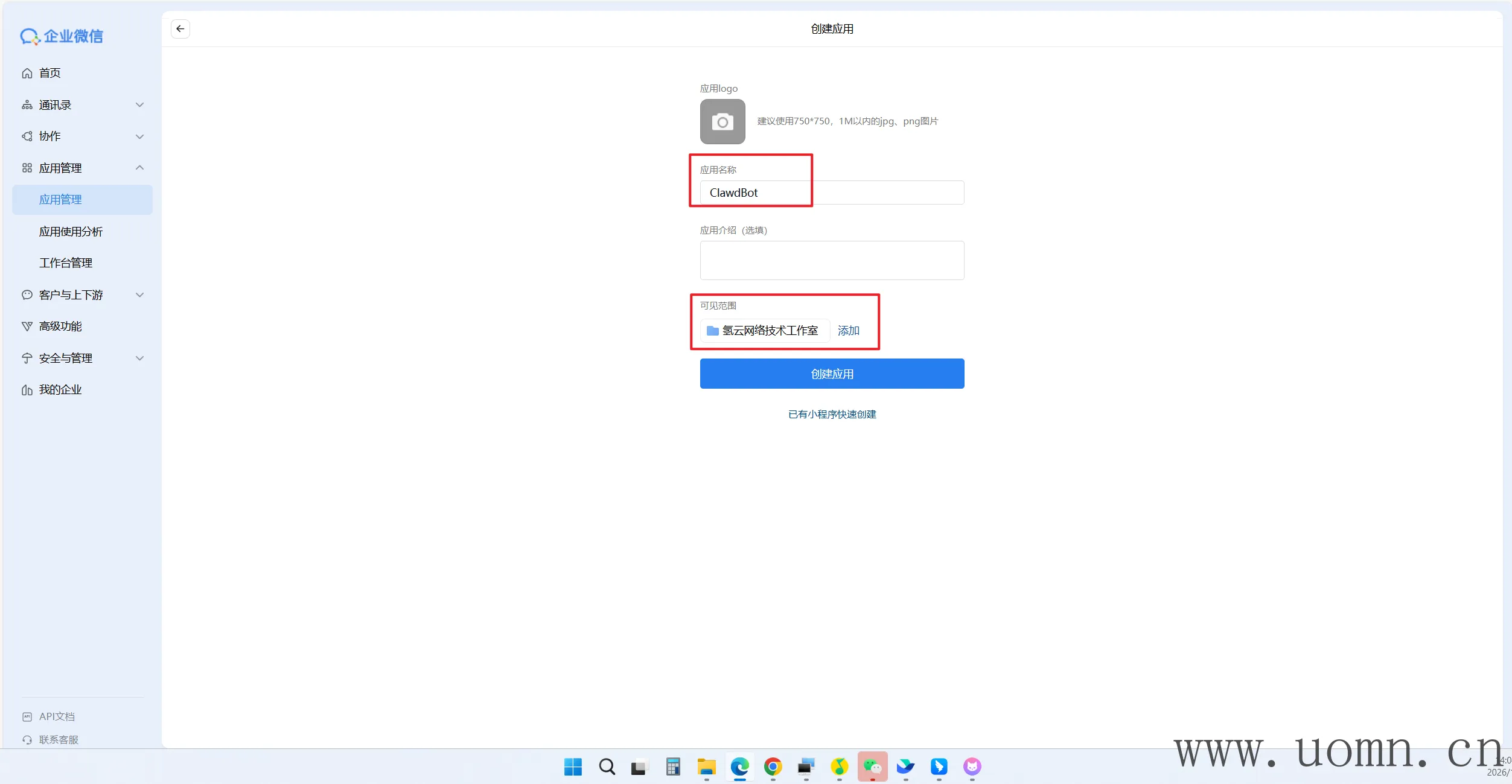

创建企业微信自建应用

企业微信网页版:https://work.weixin.qq.com/

填一下上传一下logo、应用名称、可见范围就行了

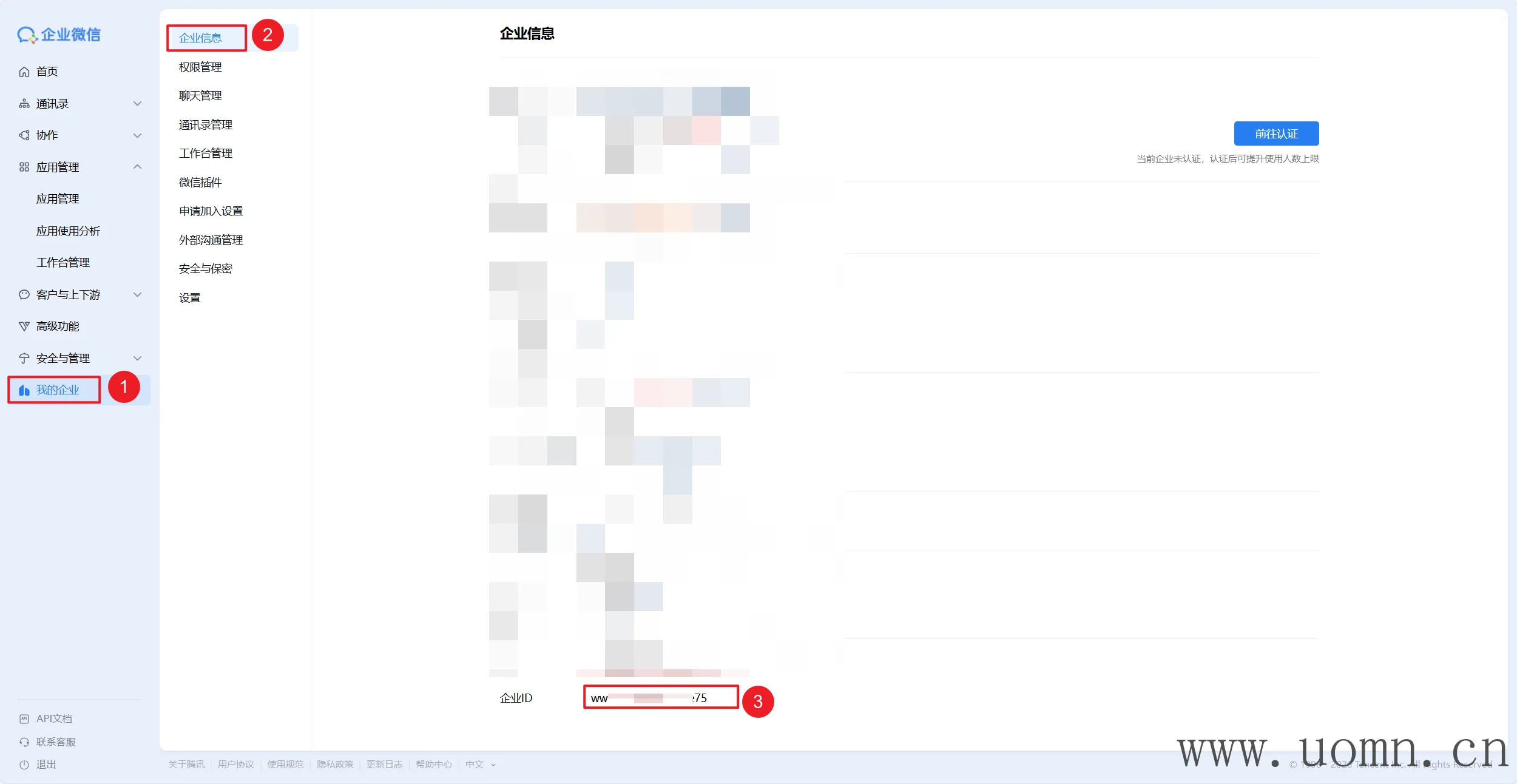

获取第一个配置信息:企业ID

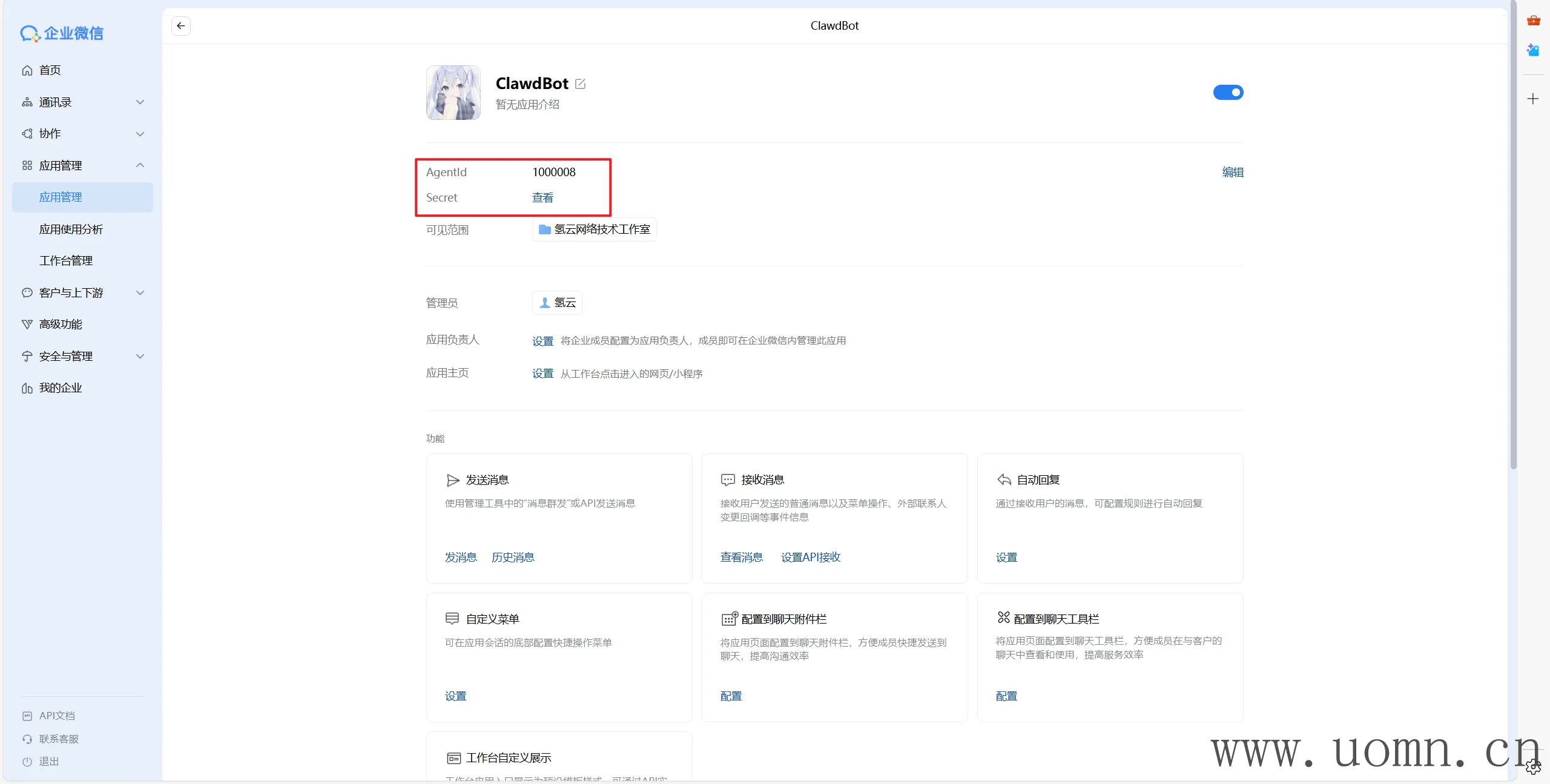

获取第二、三个配置信息,应用ID和密钥,获取密钥的时候,会把密钥发送到手机的企业微信上

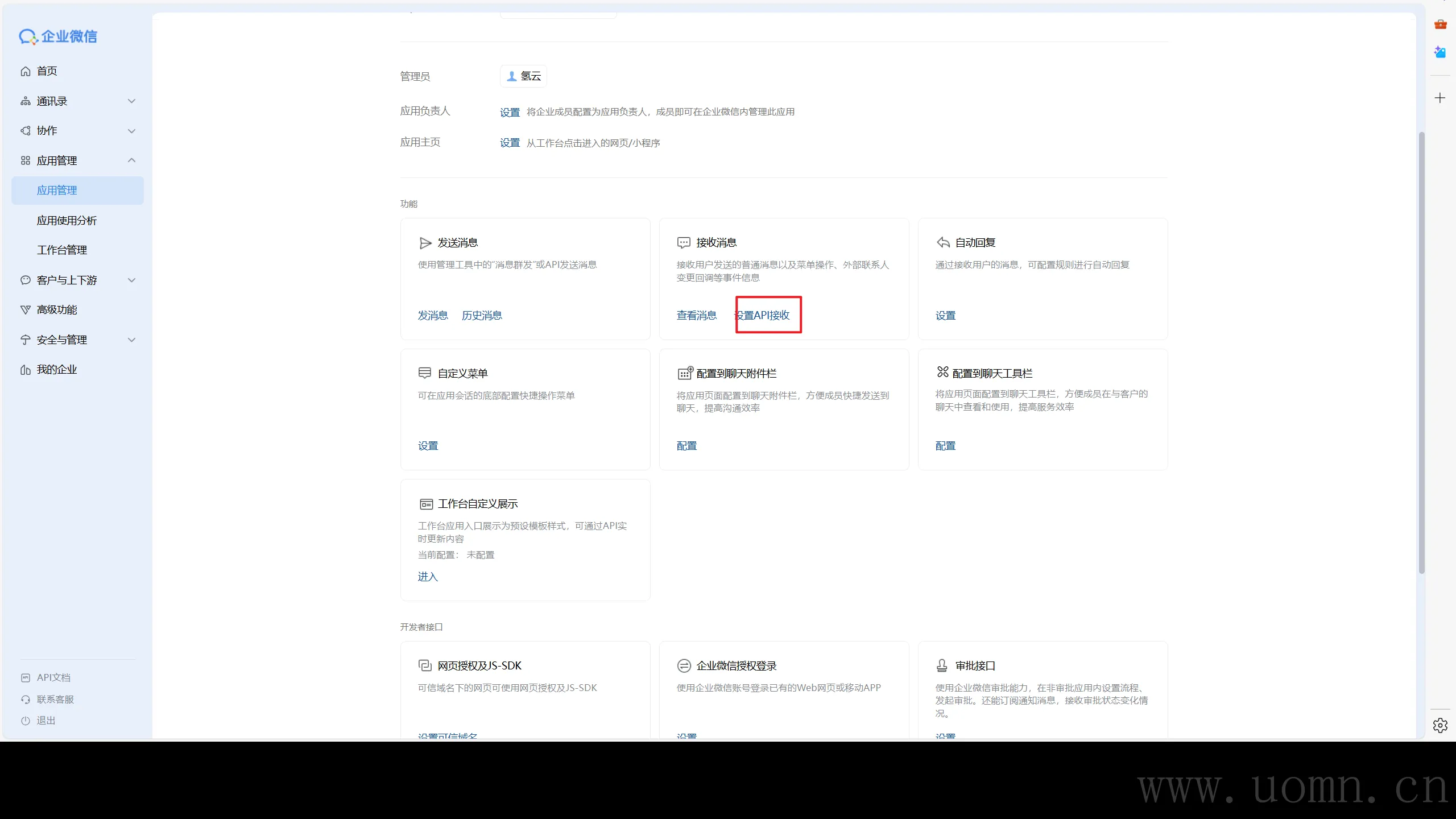

设置API接收

获取第四个、第五个配置信息(点随机获取)

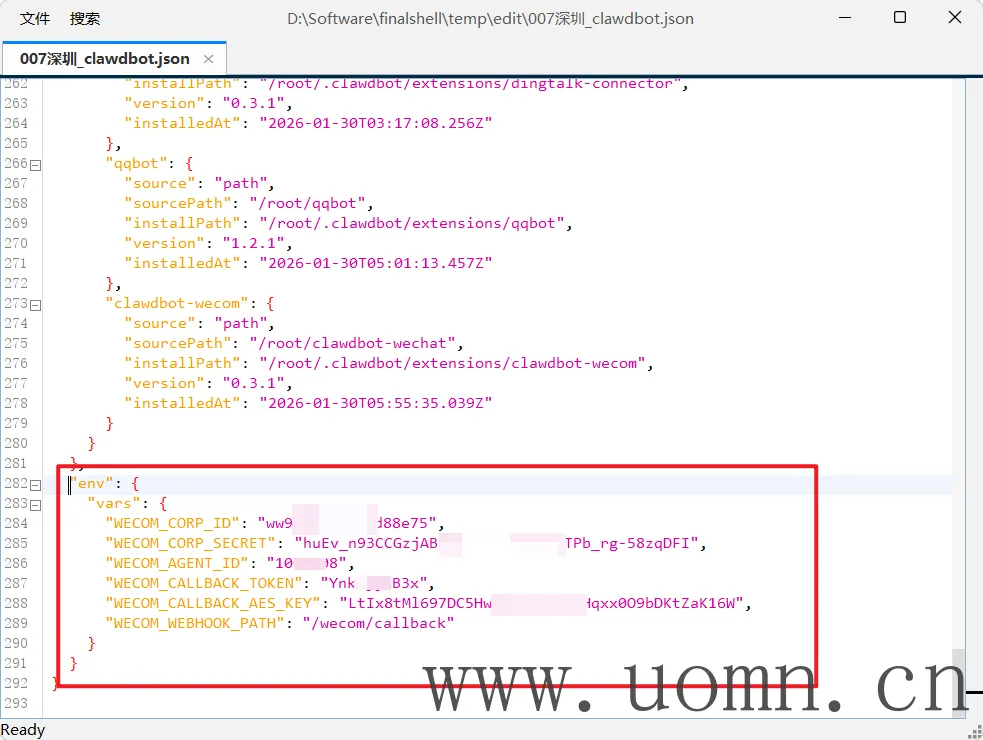

修改配置文件

修改openclaw.json 文件,在文件末尾新增一个配置,将上边获取的5个配置信息填进去

{

"env": {

"vars": {

"WECOM_CORP_ID": "你的企业ID",

"WECOM_CORP_SECRET": "你的应用Secret",

"WECOM_AGENT_ID": "你的应用AgentId",

"WECOM_CALLBACK_TOKEN": "你设置的Token",

"WECOM_CALLBACK_AES_KEY": "你生成的EncodingAESKey",

"WECOM_WEBHOOK_PATH": "/wecom/callback"

}

}

}

目前openclaw还没开放外网访问,所以没法完成企业微信的回调,所以需要修改监听,将bind的值改成lan

保存配置后,重启服务

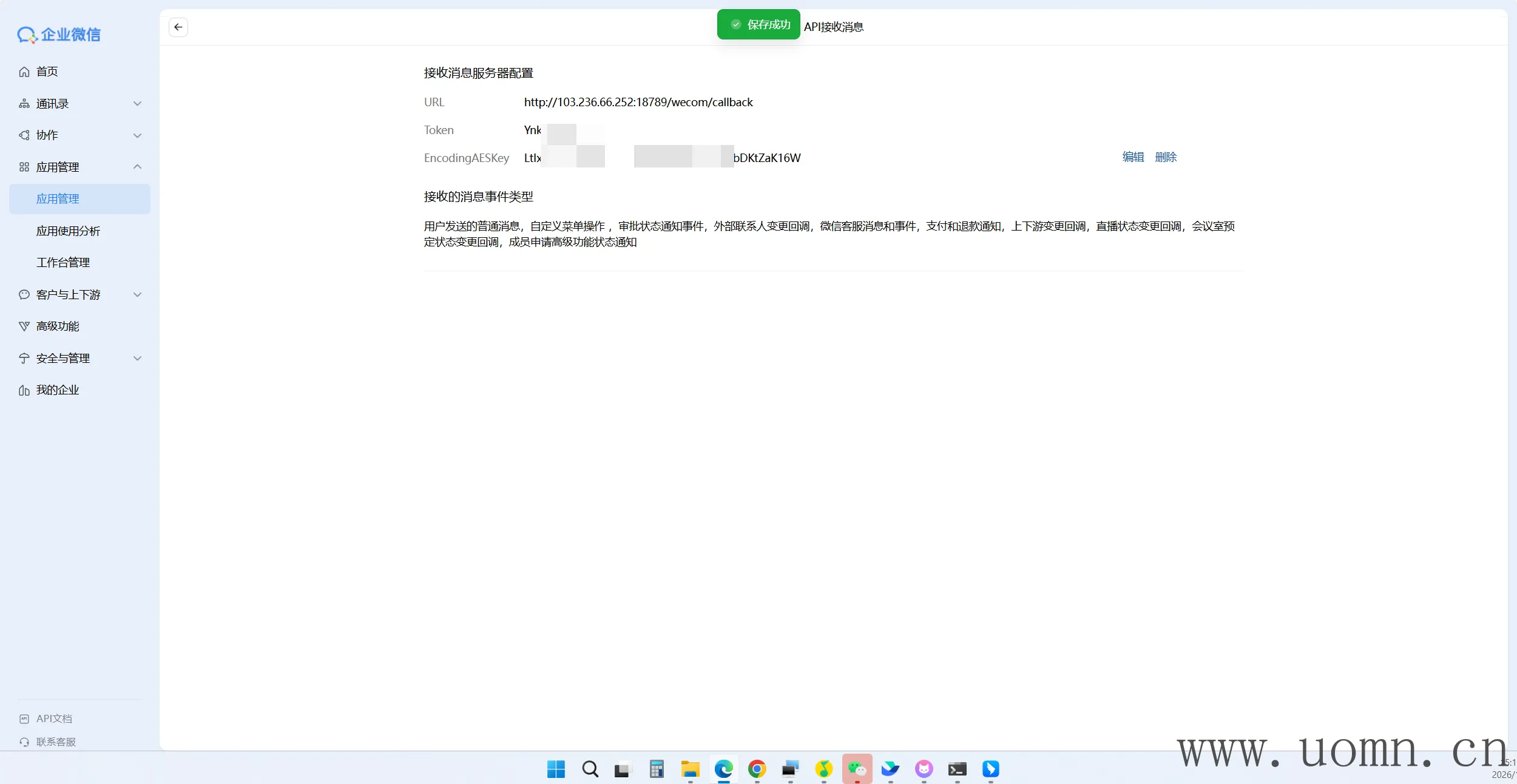

openclaw gateway restart验证回调

URL处填写:http://<服务器IP/企业备案域名>:18789/wecom/callback

然后点保存,显示保存成功就OK了

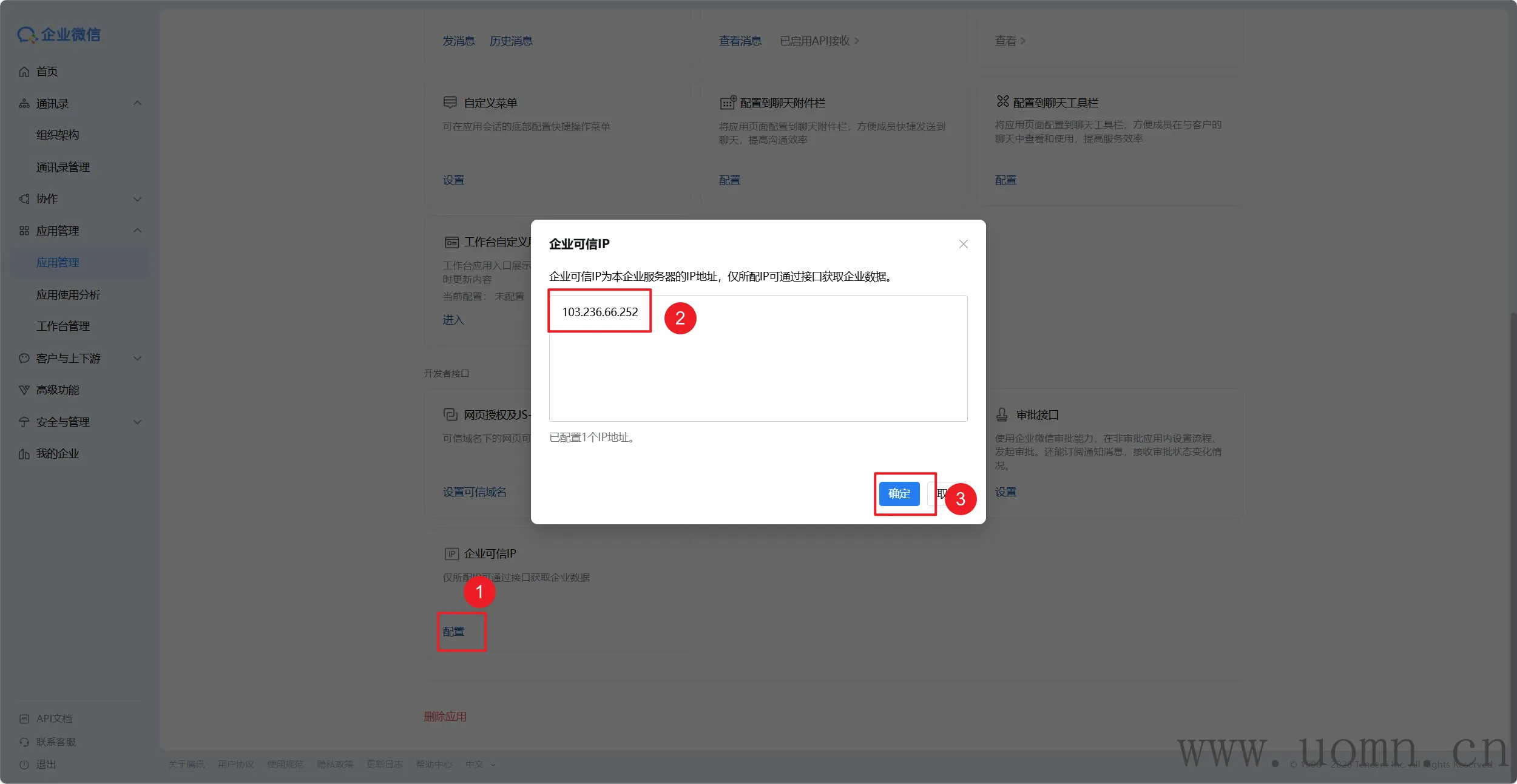

最后一步,将你的服务器IP填到白名单

测试

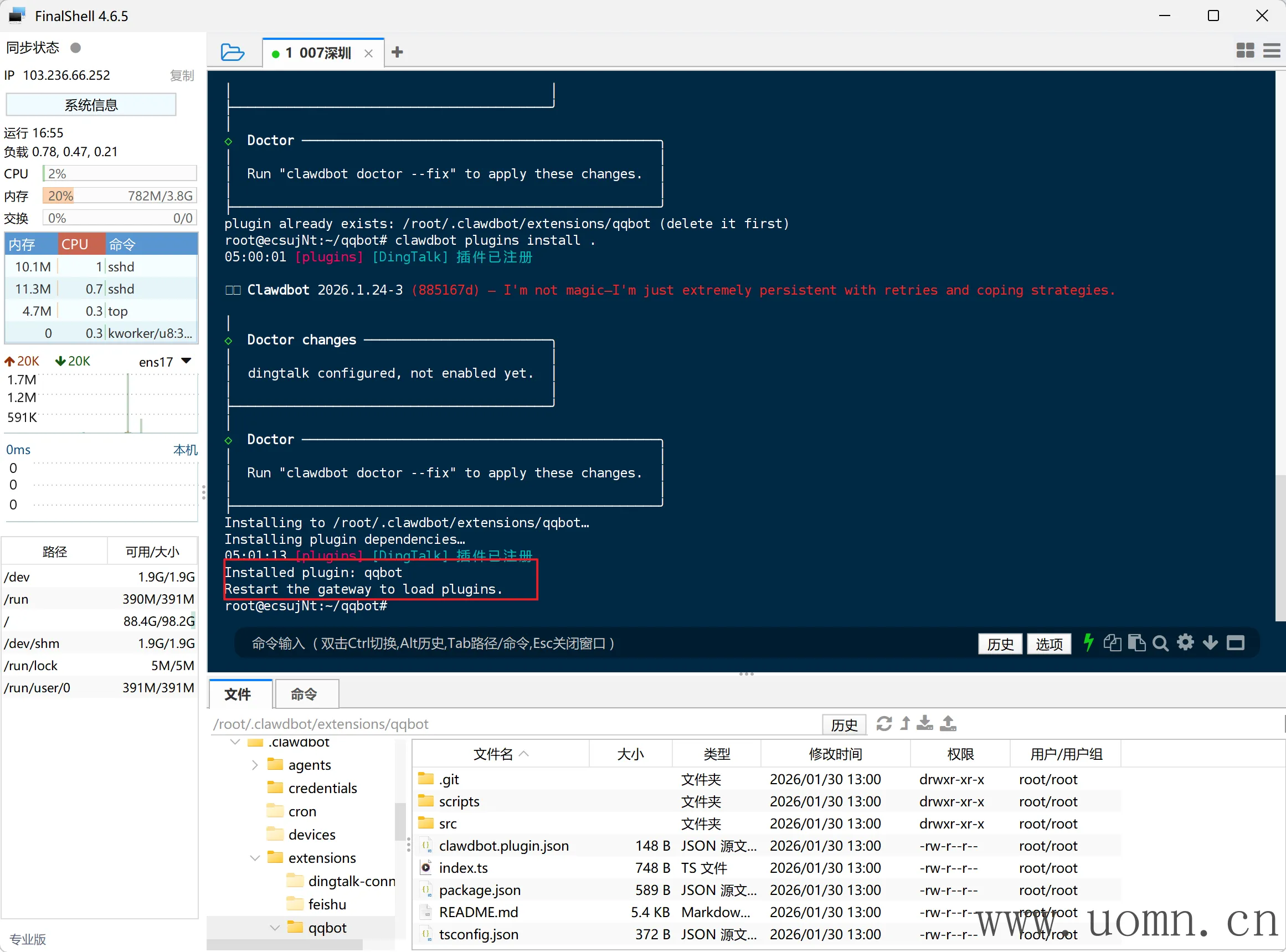

接入QQ机器人(不推荐,易超时)

官方库:https://github.com/sliverp/qqbot

安装QQ机器人渠道

终端执行下方命令

# 国内机用这个

git clone https://ghfast.top/https://github.com/sliverp/qqbot.git && openclaw plugins install ./qqbot

# 国外机用这个

git clone https://github.com/sliverp/qqbot.git && openclaw plugins install ./qqbot

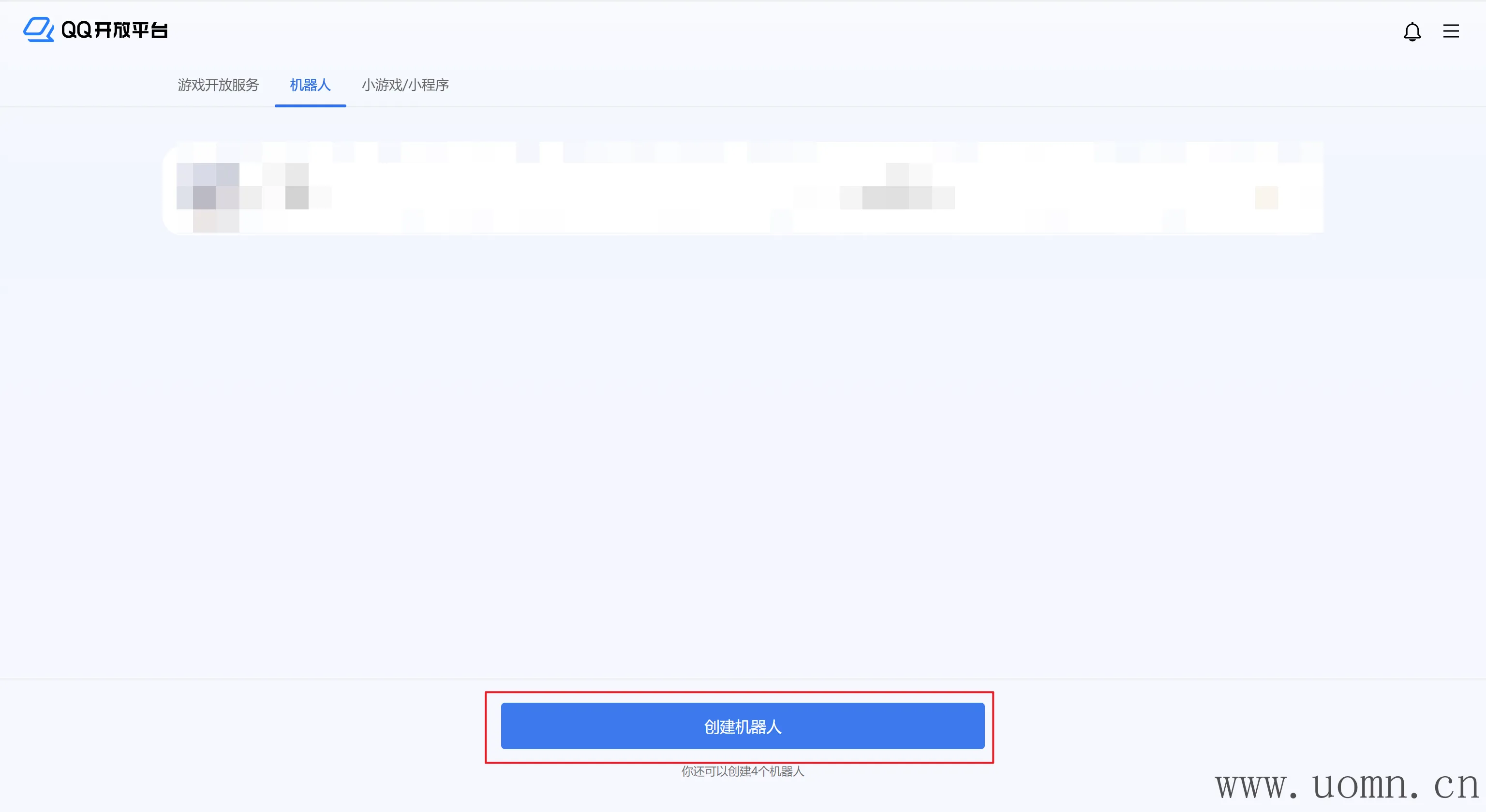

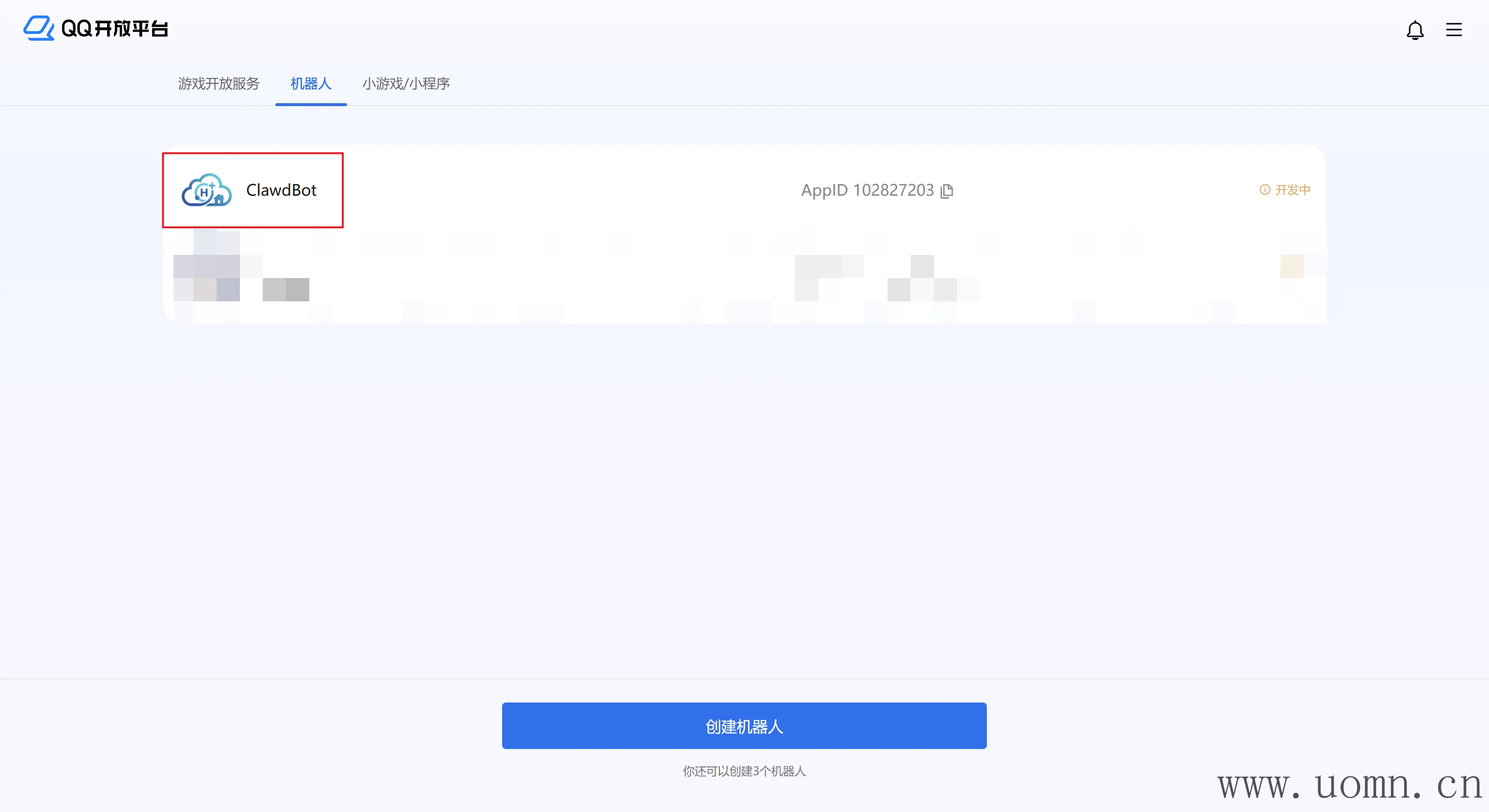

创建QQ机器人

QQ开放平台:https://q.qq.com/

填一下基础信息,然后确认

修改IP白名单,填入服务器的IP

修改配置文件

修改openclaw.json 文件新增QQ机器人配置信息

{

"channels": {

"qqbot": {

"enabled": true,

"appId": "你的AppID",

"clientSecret": "你的AppSecret"

}

}

}

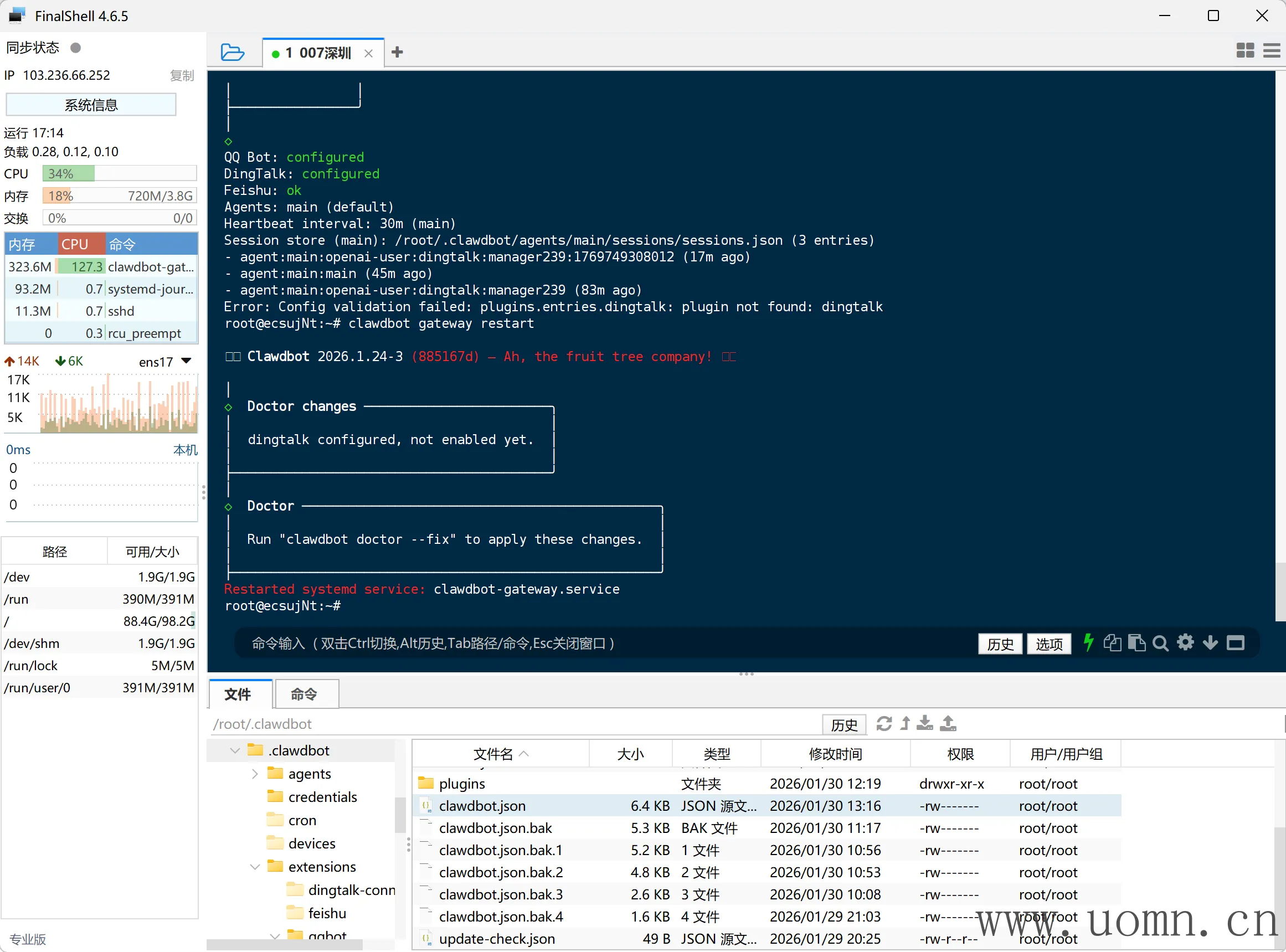

重启&测试

终端执行命令,先检测配置文件,然后重启服务

openclaw doctor

openclaw gateway restart

返回QQ开放平台,由于正式审核有一些麻烦,这里就不写了,暂时用沙箱测试

一般不建议接入群聊使用,所以我这里只接了私聊测试

接入企业微信智能机器人

官方库:https://github.com/sunnoy/openclaw-plugin-wecom

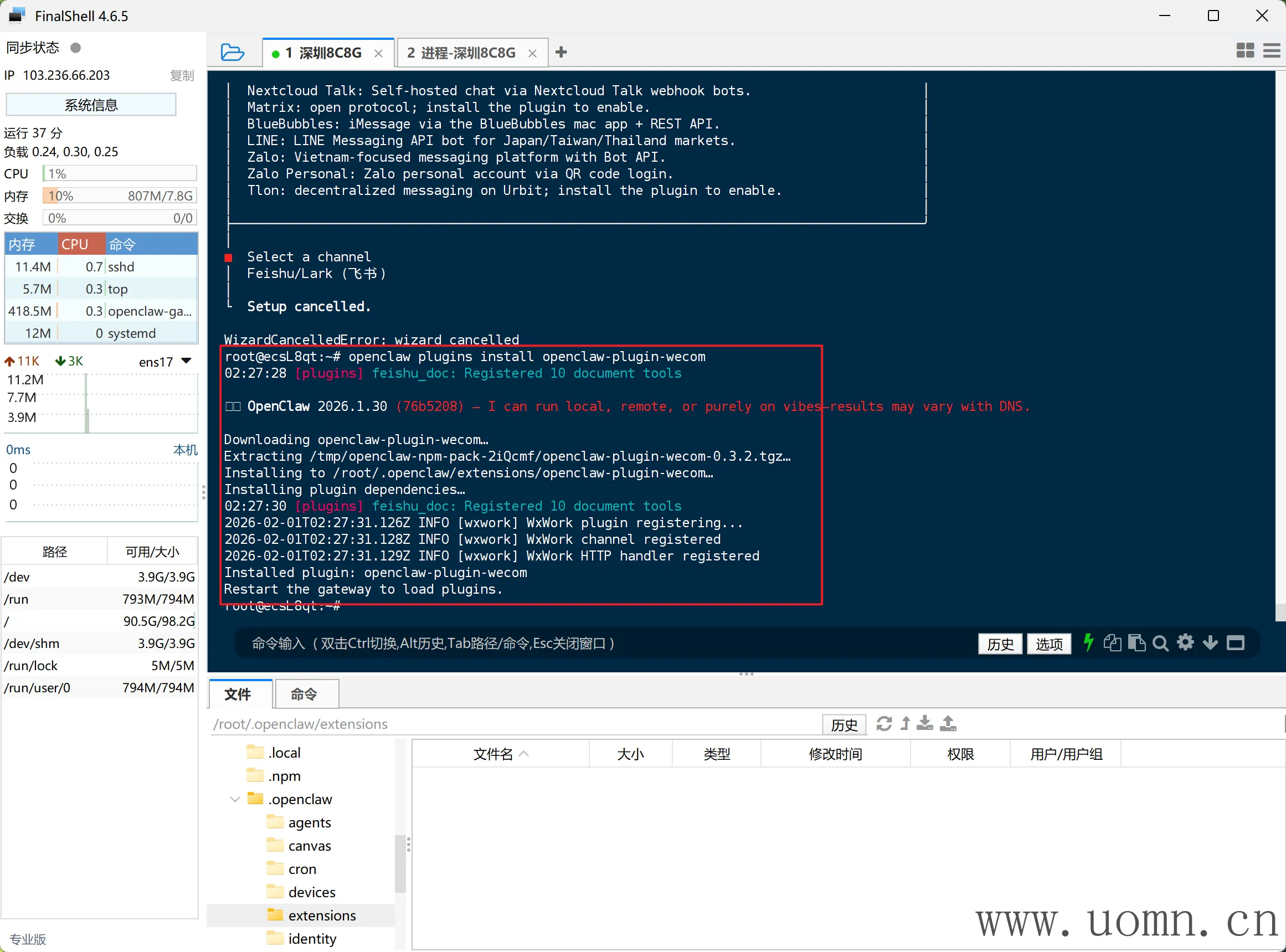

安装企业微信智能机器人渠道

终端执行下方命令

openclaw plugins install openclaw-plugin-wecom

# npm install openclaw-plugin-wecom --registry https://registry.npmmirror.com

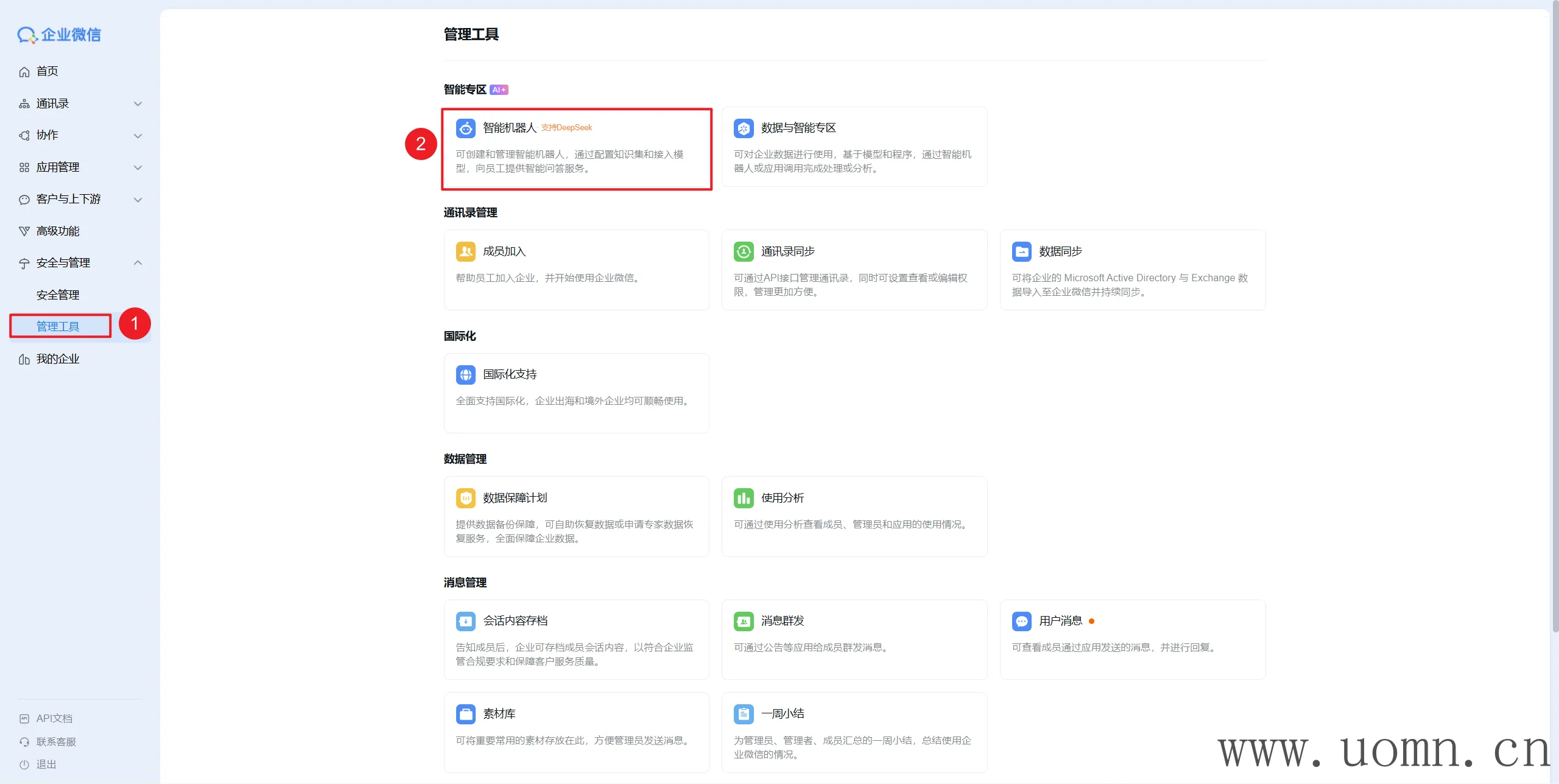

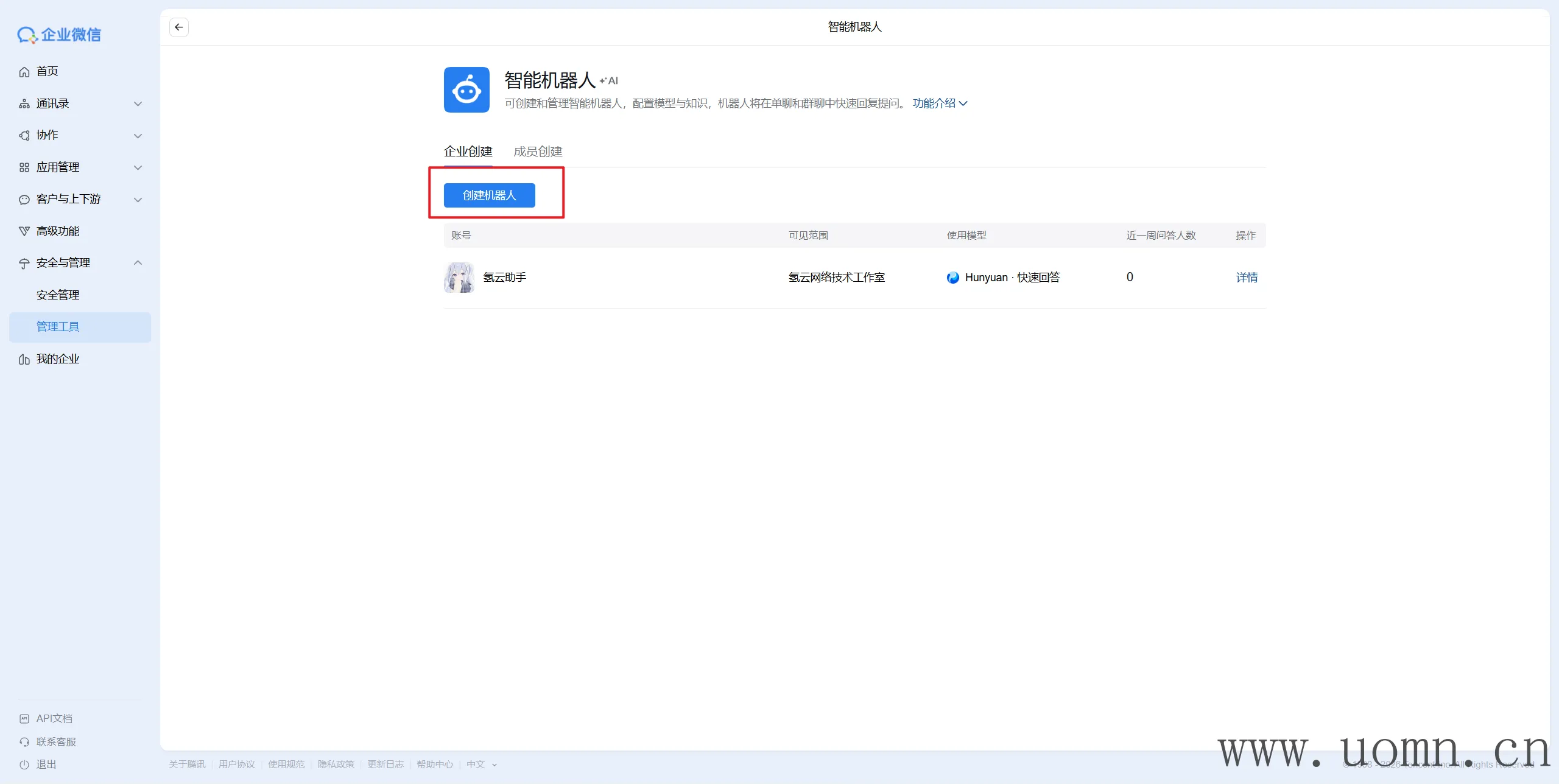

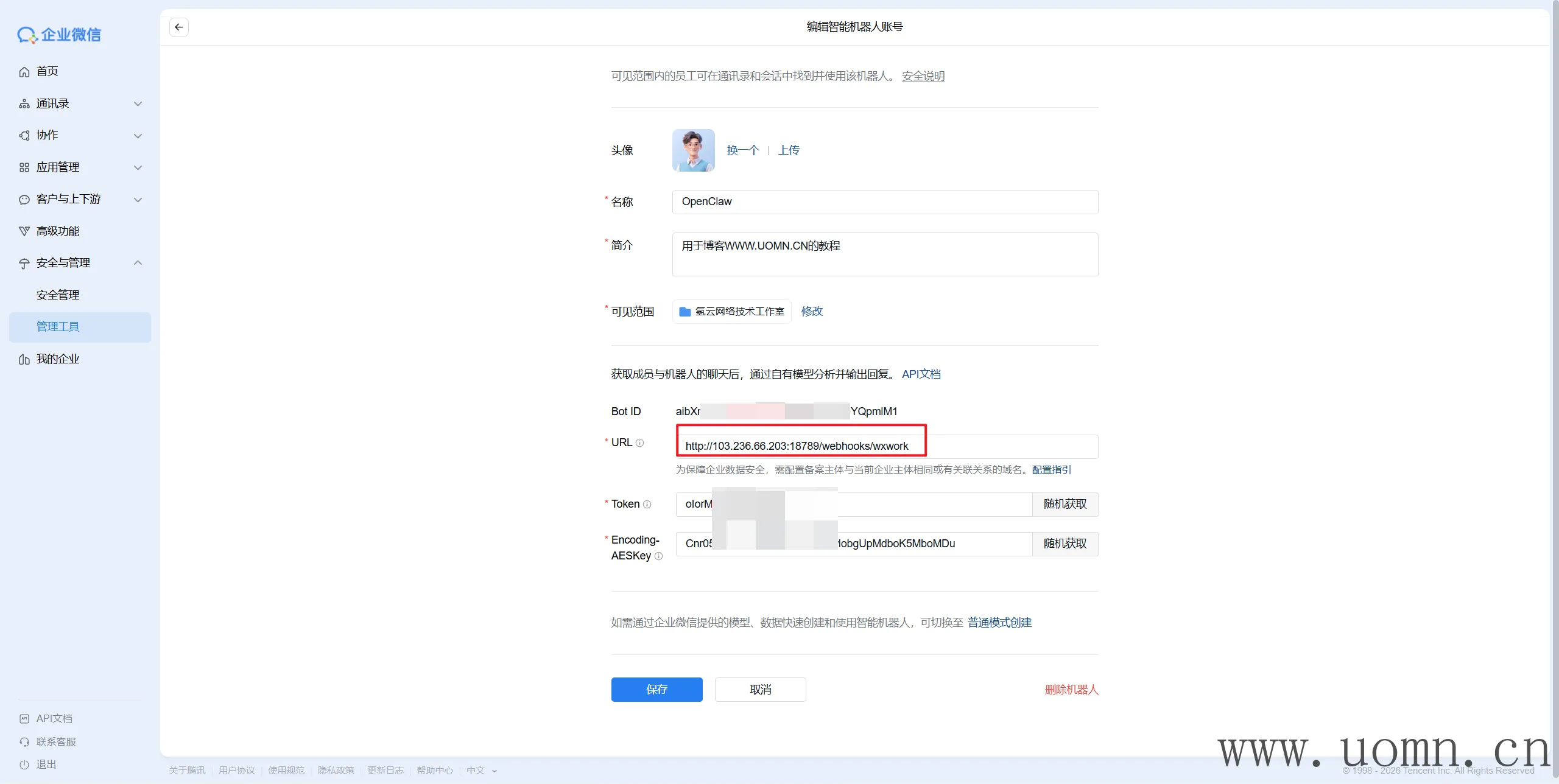

创建智能机器人

企业微信:https://work.weixin.qq.com/

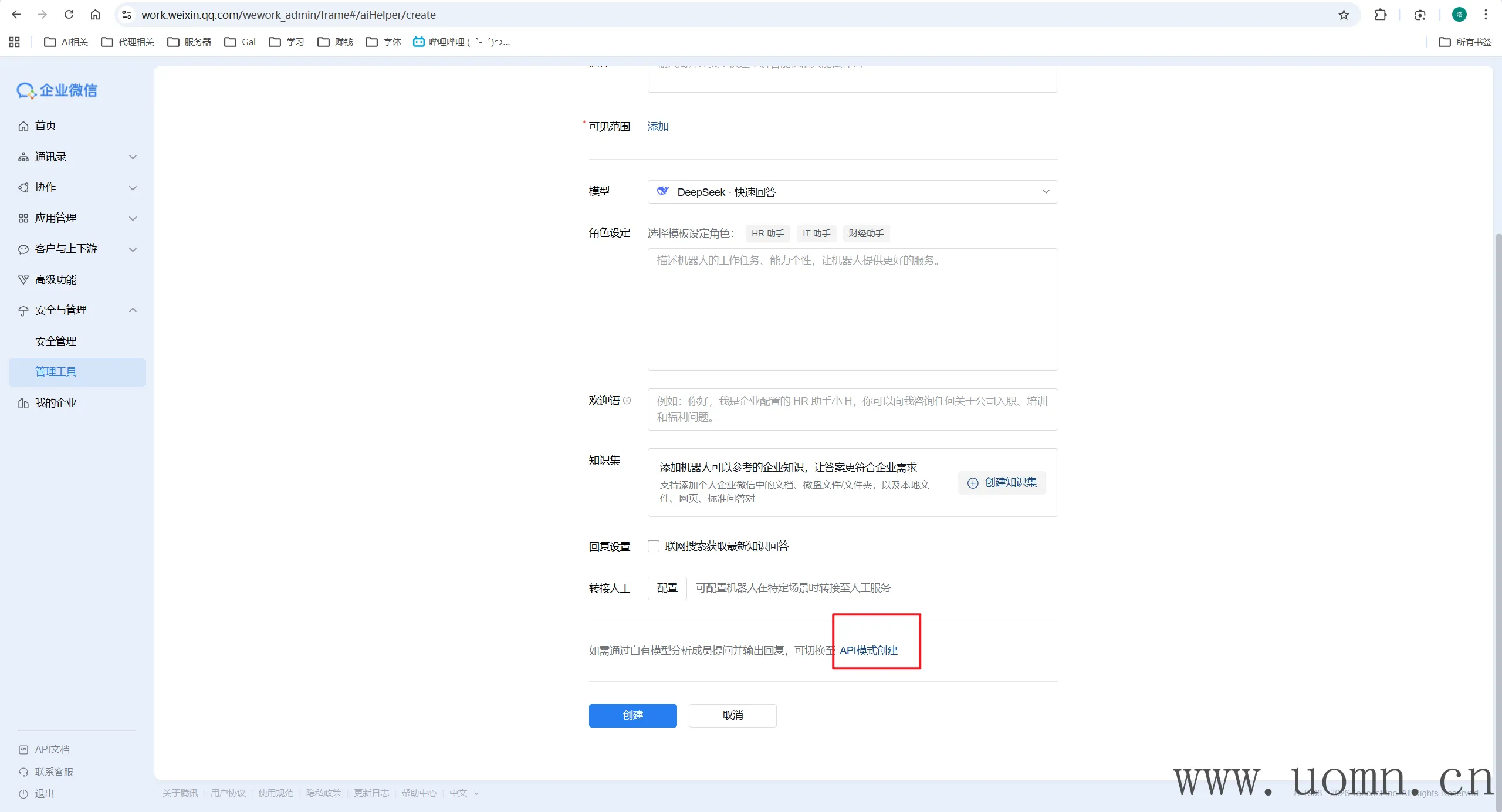

下滑到底,选择API模式创建

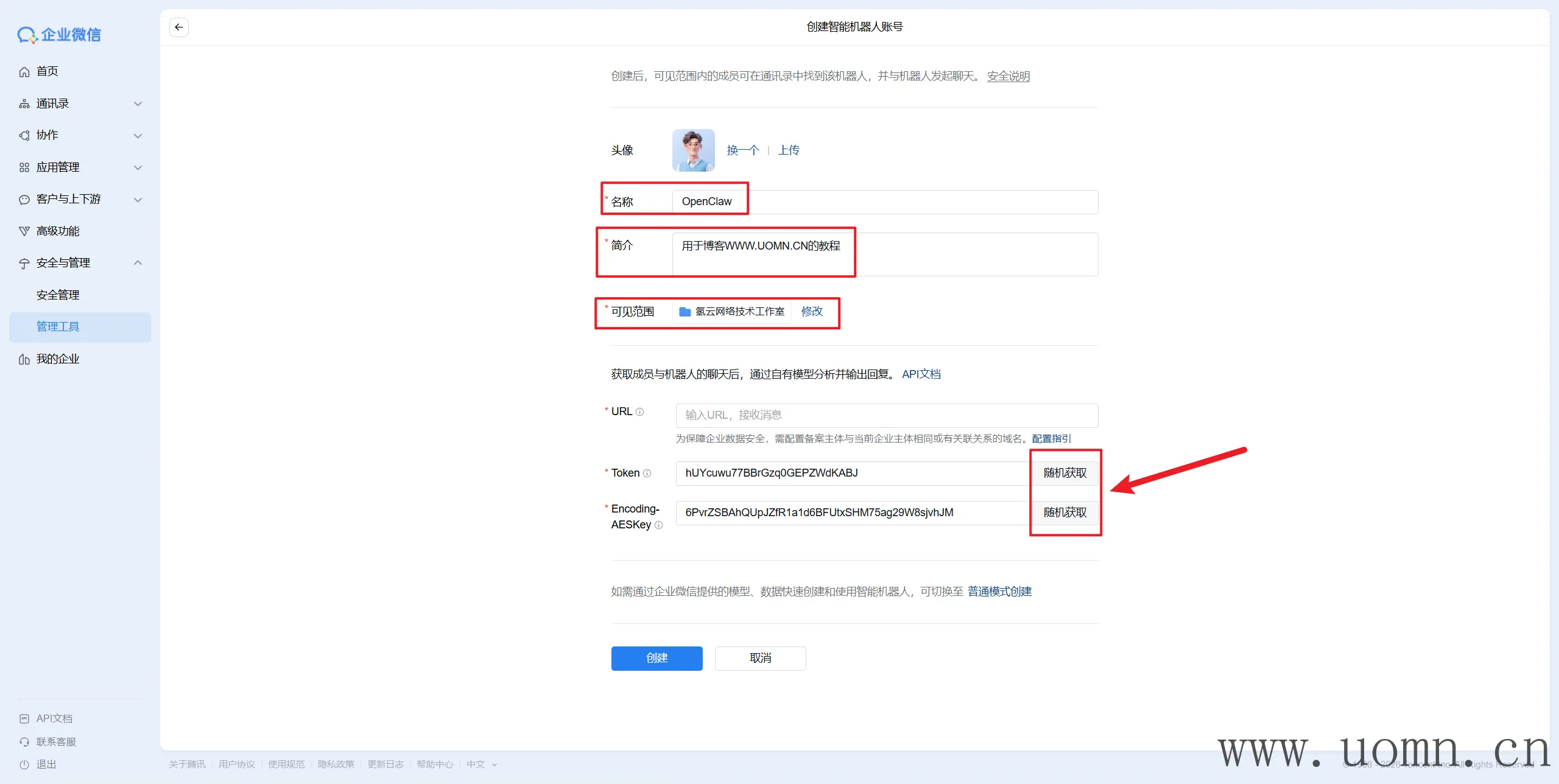

如下图,名称就是机器人名称,URL先不填

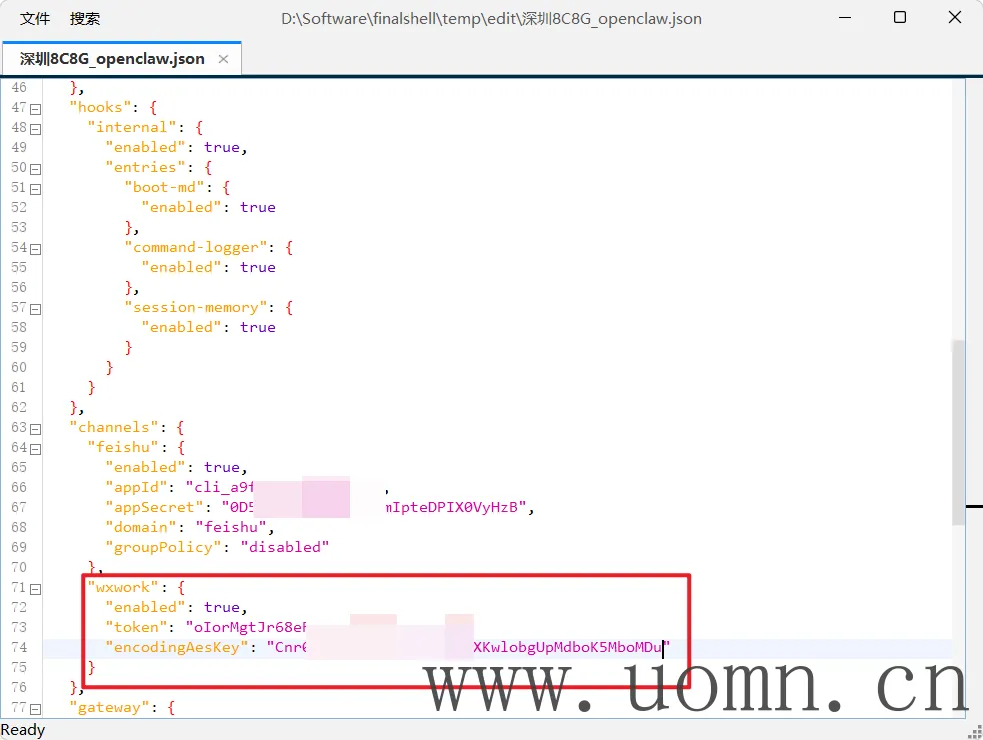

修改配置文件

修改openclaw.json 文件,添加下方配置,把上边随机生成的字符串填到这里

"wxwork": {

"enabled": true,

"token": "你的 Token",

"encodingAesKey": "你的 EncodingAESKey"

}

同时确保gateway配置中的监听值是lan

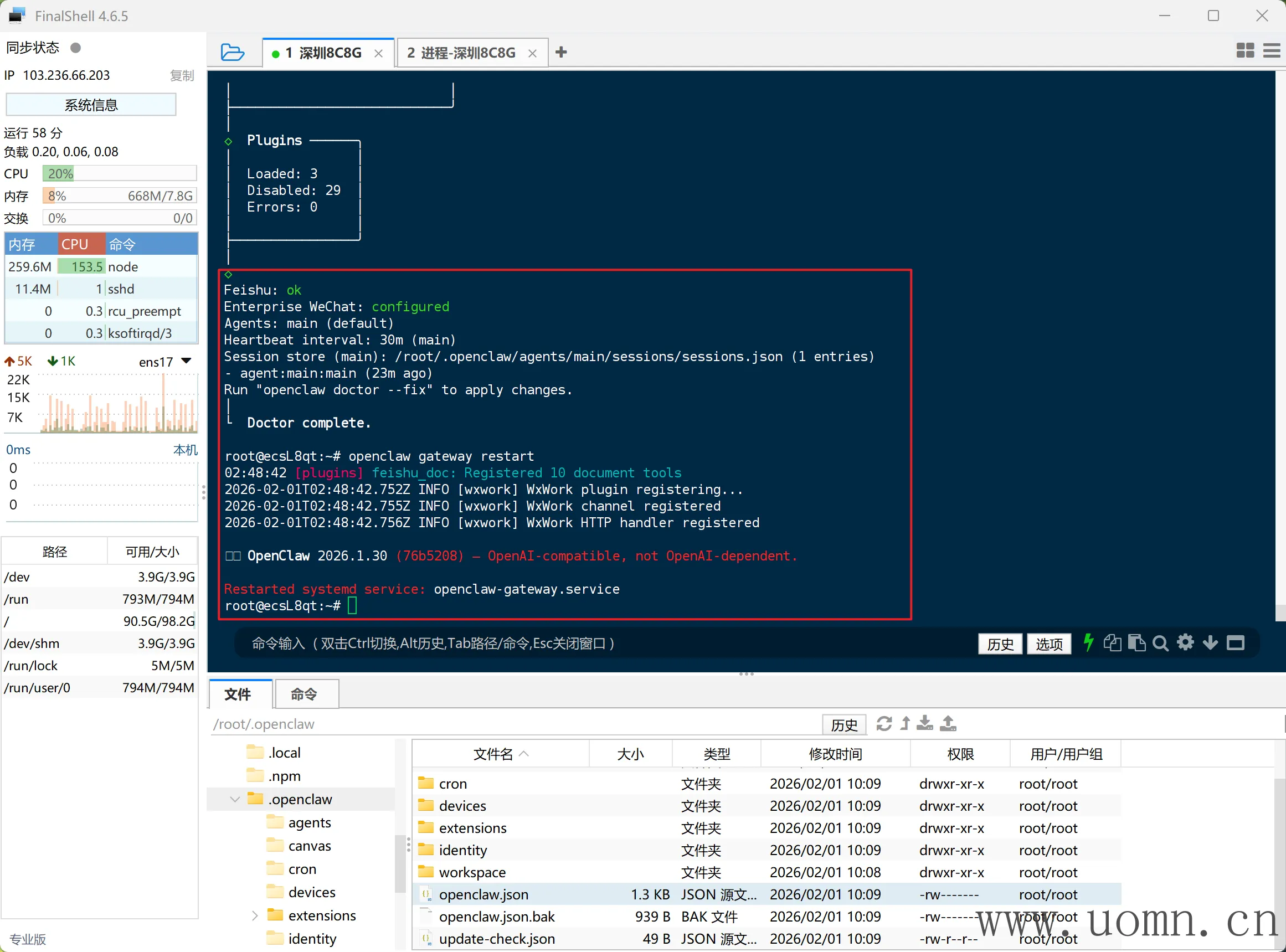

保存后执行下方命令检查配置并重启服务

openclaw doctor

openclaw gateway restart

返回企业微信页面,填入URL,格式为:http://<服务器IP/企业备案域名>:18789/webhooks/wxwork

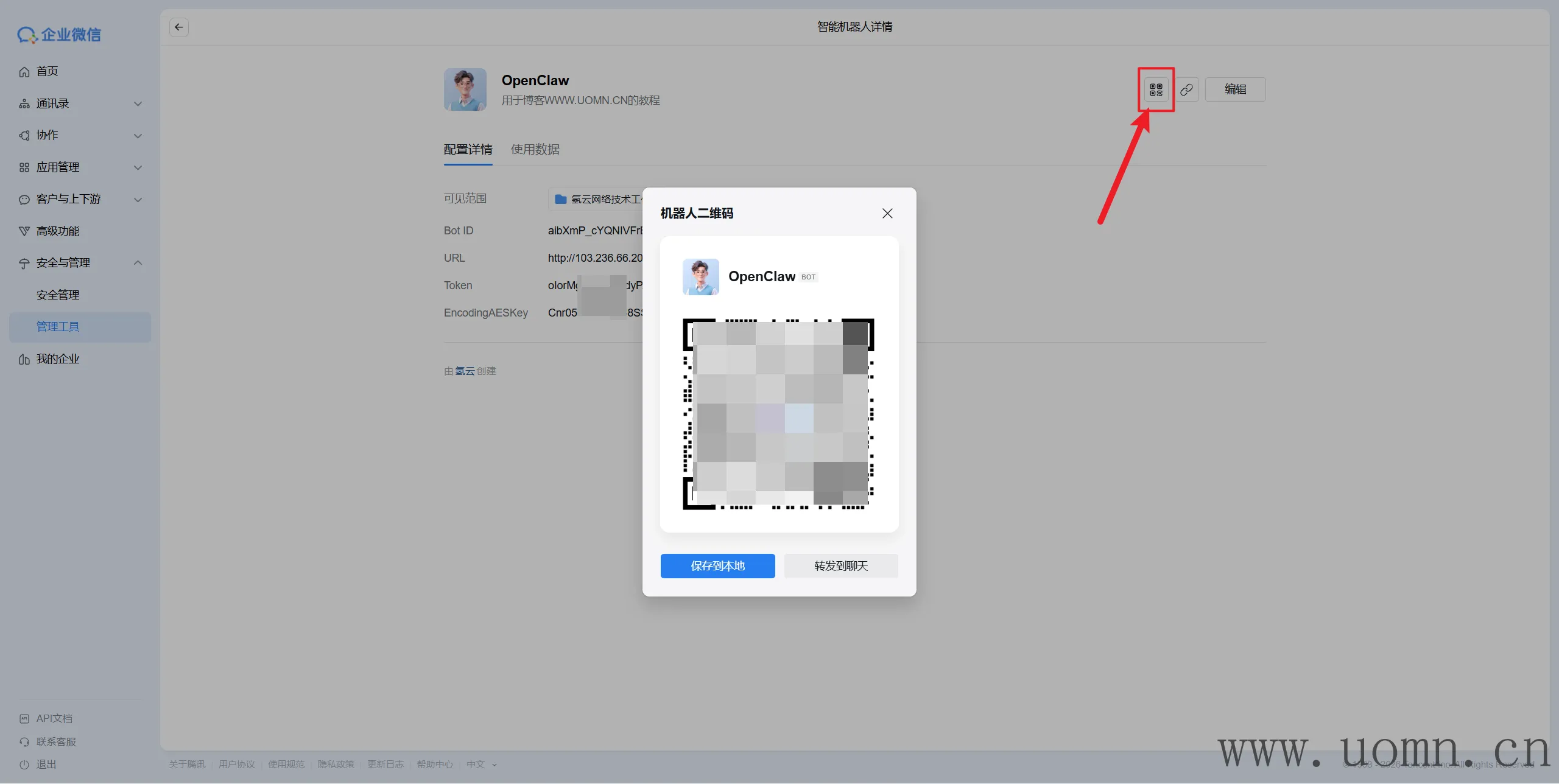

测试

初次使用,可以扫码使用

接入企业微信个人账号&微信个人账号

能拉外部群、内部群、私聊用,不过,也就那样了,拉群里用风险太大,就不写这个教程了

云部署OpenClaw连接本地浏览器

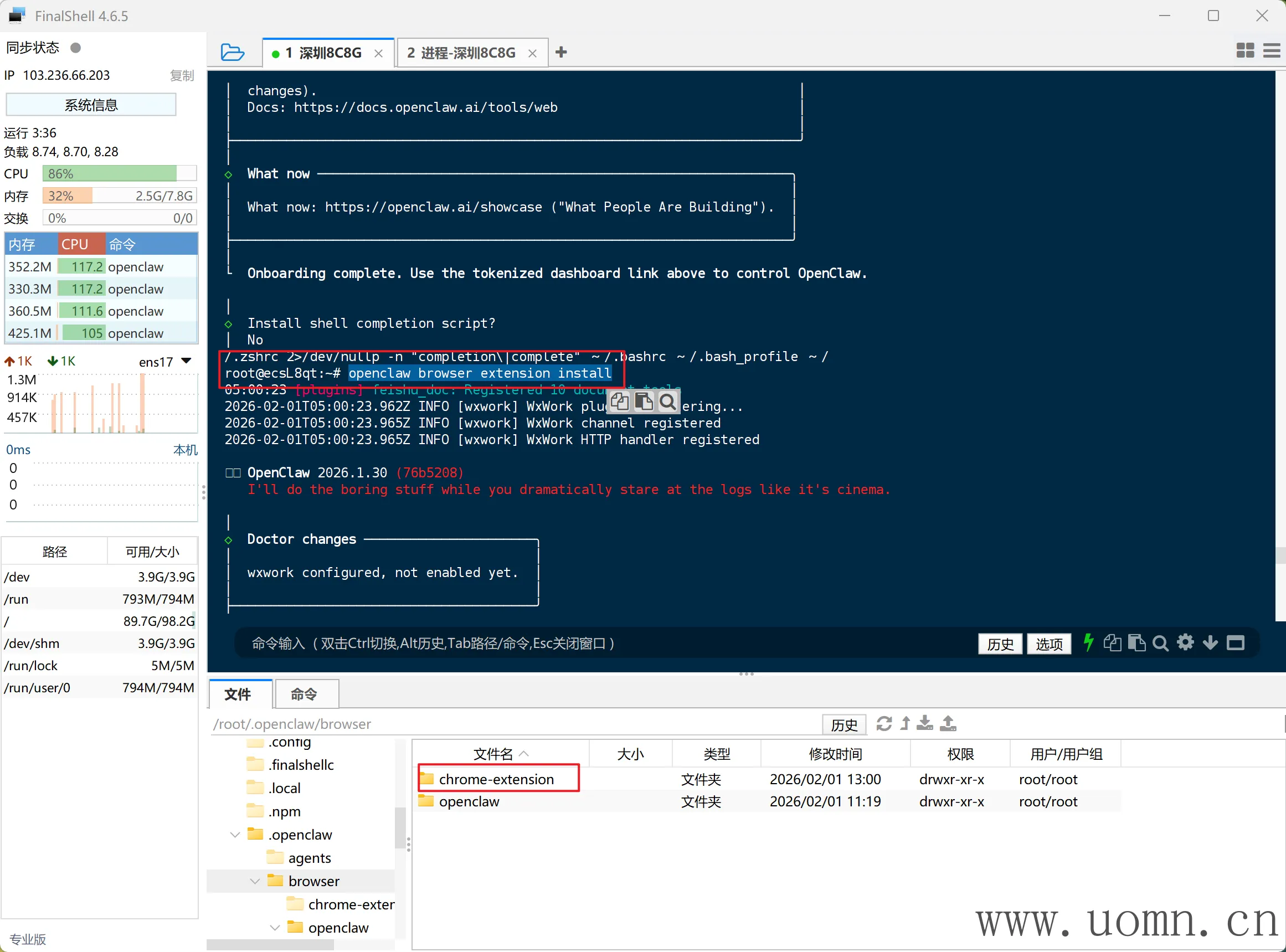

终端执行,会将浏览器插件下载到服务器上

openclaw browser extension install

然后把这个目录下载到电脑上,如果是使用的我同样的SSH工具,可以直接右键文件夹下载

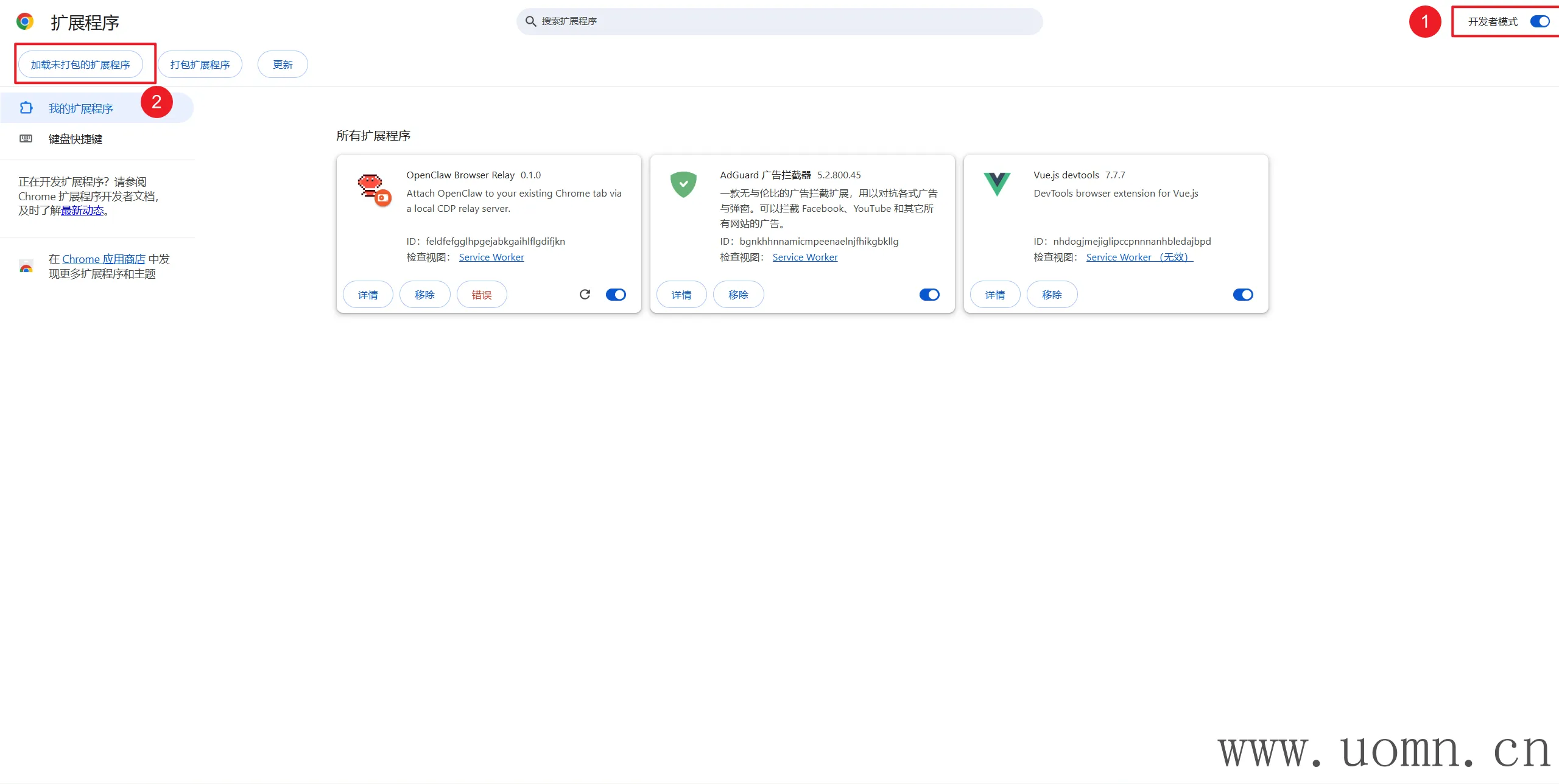

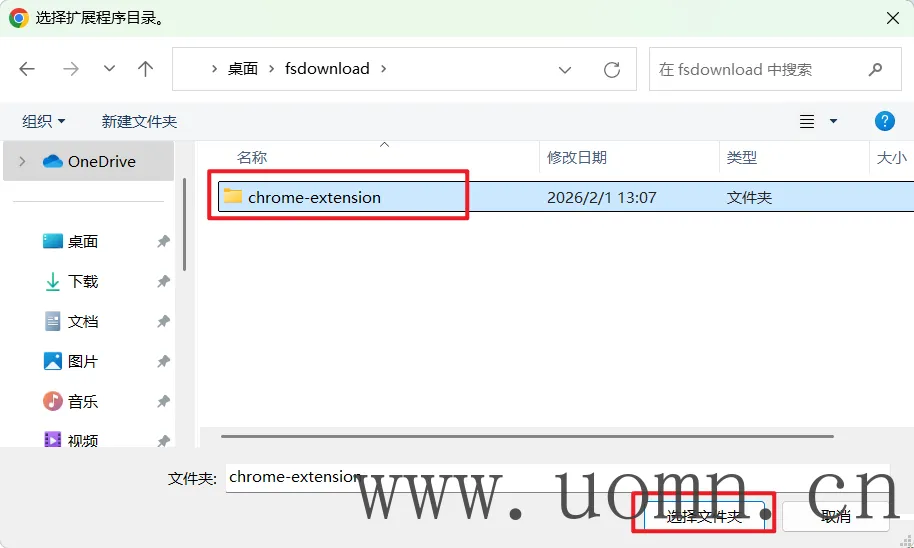

然后打开谷歌浏览器或者Edge浏览器,安装扩展

然后打开CMD命令行,输入下方命令

s之后会让你输入服务器密码,输入时密码不可见,然后这个CMD窗口不要关

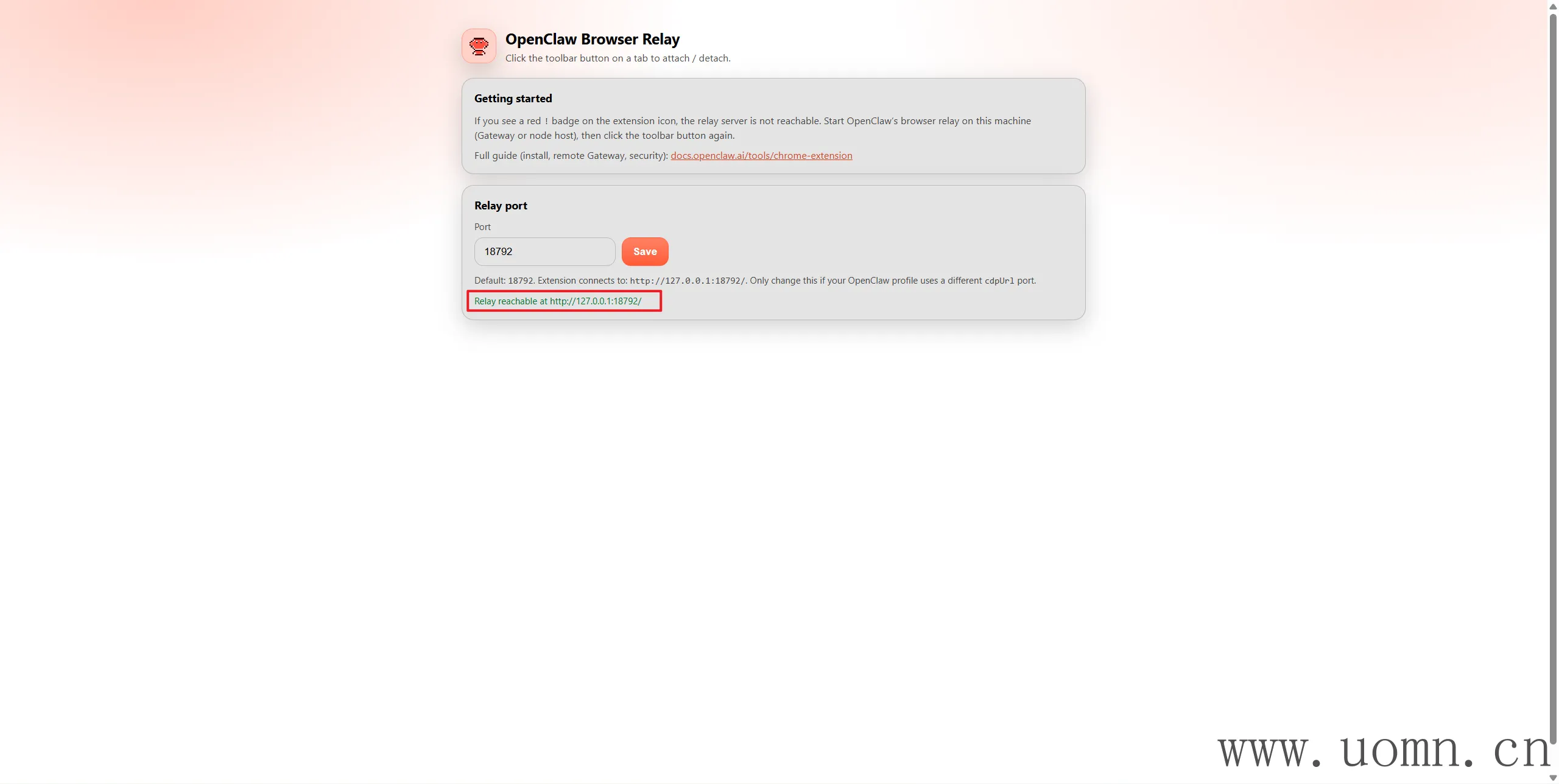

回到浏览器,下图标出来的位置是绿的就行了

然后点一下扩展,会发现图标中有个on的字样,就OK了

后记

如果看了教程也不会的话,可以联系微信AO-XU-OA有偿部署

警告信息!!!

不要将MoltBot接入任何开放的群聊,或提供给多人使用,该程序在部署的系统上几乎有所有的权限,能够随时获取你设备上的一切信息,稍有不慎,便是万丈深渊

举个栗子:偷拍你、种病毒、偷你密钥、玩弄你的浏览器、在你的电脑上播放奇奇怪怪的东西

# 技能网站

clawdhub.ai/skills

# 浏览器控制插件(让机器人安装)

执行npm install -g clawhub

安装agent-brower以及相关的依赖

# 有用的开源地址

https://github.com/justlovemaki/AIClient-2-API

https://github.com/justlovemaki/OpenClaw-Docker-CN-IM

默认评论

Halo系统提供的评论